티스토리 뷰

Paper/TTS

[Paper 리뷰] DurIAN-E2: Duration Informed Attention Network with Adaptive Variational Autoencoder and Adversarial Learning for Expressive Text-to-Speech Synthesis

feVeRin 2024. 5. 23. 10:16반응형

DurIAN-E2: Duration Informed Attention Network with Adaptive Variational Autoencoder and Adversarial Learning for Expressive Text-to-Speech Synthesis

- Expressive, high-fidelity text-to-speech를 위해 duration informed attention model을 고려할 수 있음

- DurIAN-E2

- Multiple stacked SwishRNN-based Transformer block을 linguistic encoder로 채택하고 Style-Adaptive Instance Normalization layer를 frame-level encoder에 추가하여 expressiveness 모델링을 향상

- Normalizing flow로 augment 된 variational autoencoder와 adversarial training strategy를 적용한 BigVGAN waveform generator를 활용

- 논문 (ICASSP 2024) : Paper Link

1. Introduction

- Neural Text-to-Speech (TTS) 모델은 우수한 합성 품질을 보이고 있지만, 여전히 expressiveness 측면에서 human speech와 큰 차이를 보임

- 특히 speaking style control은 expressive TTS에서 중요한 topic으로, 크게 2가지 approach를 사용함

- Pre-defined categorical style label을 TTS 모델의 global control condition으로 사용하는 방법

- 보다 직관적이고 interpretable 한 style control이 가능하다는 장점 - 주어진 reference speech에 대한 speaking style을 imitate 하는 방법

- 추가적인 label 없이 dataset에서 추출된 global style token을 통해 diversity를 높일 수 있다는 장점

- Pre-defined categorical style label을 TTS 모델의 global control condition으로 사용하는 방법

- Duration Informed Attention Network for Expressive TTS (DurIAN-E)는 autoregressive (AR) model로써, input linguistic information과 duration model에서 추론된 output acoustic feature 간의 alignment를 활용함

- 이때 모델은 pre-defined rich categorical style label을 사용하는 AR decoder를 통해 frame by frame으로 linguistic feature에서 mel-spectrogram을 생성

- 추가적으로 expressiveness를 향상하기 위해 Style-Adaptive Instance Normalization (SAIN) layer를 도입하여 mel-spectrogram의 각 channel에 대한 style-specific distribution을 학습

- 이때 denoiser로써 SAIN layer를 포함한 Denoising Diffusion Probabilistic Model (DDPM)을 채택하여 AR decoder에서 생성된 output mel-spectrogram을 개선함 - 한편으로 SwishRNN은 feed-forward transformer block을 대체하고 pronunciation stability 향상을 위해 사용됨

- BUT, 해당 DurIAN-E는 acoustic model과 개별적인 vocoder로 구성되는 2-stage approach에 기반함

- 따라서 acoustic model에서 예측된 acoustic feature distribution과 vocoder 학습에 사용된 distribution 간의 mismatch로 인해 artifact가 발생할 가능성이 높고, 합성 품질이 저하됨 - 위 문제를 해결하기 위해 acoustic model과 vocoder를 통합하여 linguistic information에서 latent representation을 학습한 다음, waveform을 직접 생성하는 end-to-end 방식을 고려할 수 있음

- 특히 speaking style control은 expressive TTS에서 중요한 topic으로, 크게 2가지 approach를 사용함

-> 그래서 fully end-to-end TTS 모델을 기반으로 DurIAN-E를 개선한 DurIAN-E2를 제안

- DurIAN-E2

- Glow-TTS, VITS와 같은 end-to-end model을 기반으로 기존 DurIAN-E의 AR decoder와 DDPM-based denoiser를 BigVGAN decoder로 교체함으로써 2-stage 방식의 mismatch 문제를 해결

- Prior encoder의 hidden sequence와 style label로 condition 된 normalizing flow를 도입하여 SAIN-based Variational AutoEncoder (VAE)의 linear spectrogram에서 학습된 latent representation을 모델링

< Overall of DurIAN-E2 >

- DurIAN-E를 기반으로 end-to-end framework를 구성하기 위해, normalizing flow로 augment 된 VAE와 BigVGAN decoder를 활용

- 결과적으로 기존보다 뛰어난 expressive TTS 성능을 달성

2. Method

- Architecture

- DurIAN-E2는 아래 그림과 같이 prior encoder가 linguistic information으로 condition 되고 posterior encoder가 acoustic feature로 condition 되는 VAE로 볼 수 있음

- 전체적으로 DurIAN-E2는 variance predictor, state-skip prior encoder, SAIN-based posterior encoder, BigVGAN decoder/discriminator로 구성됨

- 여기서 DurIAN-E2는 기존 DurIAN-E와 동일한 variance predictor를 사용하므로 각 phoneme의 duration, pitch, pitch range 등을 예측할 수 있음 - 한편으로 모델 수렴과 stability를 위해 VITS, Glow-TTS 등에서 사용된 Monotonic Alignment Search 대신 GMM-HMM을 사용한 force alignment를 통해 각 phoneme에 대한 ground-truth duration을 얻음

- 전체적으로 DurIAN-E2는 variance predictor, state-skip prior encoder, SAIN-based posterior encoder, BigVGAN decoder/discriminator로 구성됨

- Prior Encoder

- DurIAN-E에서 도입된 two-level hierarchical skip-encoder는 pronunciation error를 크게 줄이고 expressiveness와 합성 품질을 크게 향상하는데 도움을 줌

- 해당 two-level hierarchical skip-encoder는,

- 아래 그림 (a)의 SwishRNN-based Transformer block을 stack 한 phoneme-level linguistic encoder와

- (b)의 multiple convolutional Transformer block과 SAIN-based layer를 가지는 frame-level encoder로 구성됨

- 이때 DurIAN-E2에서는 기존 DurIAN-E와 달리 skip-encoder를 VAE의 prior encoder로 취급하고, linear projection layer를 통해 prior distribution을 구성하는 데 사용되는 평균과 분산 값을 생성함

- 결과적으로 논문은 prior distribution의 flexibility를 향상하기 위해, affine coupling layer와 WaveNet residual block stack을 사용한 normalizing flow $f_{\theta}$를 도입함

- 여기서 factorized normal prior distribution은 다음의 invertible transformation set을 통해 complexifiy 됨:

(Eq. 1) $p_{\theta}(z|c)=\mathcal{N}(f_{\theta}(z);\mu_{\theta}(c),\sigma_{\theta}(c))\left| \det\frac{\partial f_{\theta}(z)}{\partial z}\right|$

- $c$ : frame-level SAIN-based encoder의 output sequence - Style embedding은 global condition으로써 normalizing flow에서 각 WaveNet residual block에 추가됨

- 여기서 factorized normal prior distribution은 다음의 invertible transformation set을 통해 complexifiy 됨:

- 해당 two-level hierarchical skip-encoder는,

- SAIN-based Posterior Encoder

- Posterior encoder는 주어진 acoustic feature condition $x$에 대해 latent variable $z$의 posterior distribution $q_{\phi}(z|x)$를 근사함

- 이때 위 그림의 (c)와 같이, Glow-TTS의 gated activation unit과 skip connection을 가지는 dilated convolution layer로 구성된 non-causal WaveNet residual block을 활용

- Categorical style label의 style embedding은 global condition으로써 residual block에 추가됨

- 한편으로 multiple style의 서로 다른 acoustic feature를 잘 distinguish 하기 위해, prior encoder와 마찬가지로 SAIN layer와 additional linear projection을 WaveNet block에 추가함

- 이를 통해 normal posterior distribution의 평균과 분산을 생성 - 결과적으로 모델은 KL divergence를 계산하는 것으로 최적화할 수 있음:

(Eq. 2) $\mathcal{L}_{KL}=\log q_{\phi}(z|x)-\log p_{\theta}(z|c)$

- $z\sim q_{\phi}(z|x)=\mathcal{N}(z;\mu_{\phi}(x),\sigma_{\phi}(x))$

- $x$ : acoustic detail을 제공하기 위한 target speech의 high-resolution linear-scale spectrogram

- BigVGAN Decoder

- 논문은 VAE의 latent hidden variable $z$에 따라 condition 된 waveform decoder로써, HiFi-GAN이 아닌 BigVGAN generator을 활용

- 이때 generator는 transposed convolution stack과 Anti-aliased Multi-Periodicity composition (AMP) module로 구성됨

- AMP module은 dilated 1D convolution 이전에 서로 다른 channel-wise periodicity에 대한 multiple residual block을 추가함

- 이때 periodic inductive bias를 위해 Snake function을 도입하고 anti-aliasing을 위해 low-pass filter를 적용

- Global condition을 위해, style embedding이 input latent representation $z$에 추가됨 - 논문에서는 BigVGAN의 discriminator architecture를 따라 time-frequency domain에서 Multi-Resolution Discriminator (MRD)를 사용함

- 이때 MRD는 서로 다른 STFT resolution에 대한 multiple 2D linear spectrogram에서 동작하고, Multi-Period Discriminator (MPD)는 multiple periodic structure를 capture 하기 위해 사용됨 - 결과적으로 generator objective $\mathcal{L}_{G}$와 discriminator objective $\mathcal{L}_{D}$는:

(Eq. 3) $\mathcal{L}_{G}=\sum_{k=1}^{K}\left[\mathcal{L}_{adv}(G;D_{k})+\lambda_{fm}\mathcal{L}_{fm}(G;D_{k}) \right]+\lambda_{mel}\mathcal{L}_{mel}(G)$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\mathcal{L}_{D}=\sum_{k=1}^{K}\left[\mathcal{L}_{adv}(D_{k};G)\right]$

- $D_{k}$ : $k$-th MPD/MRD의 sub-module, $\mathcal{L}_{adv}$ : least-square GAN loss

- $\mathcal{L}_{fm}$ : feature matching loss로써 discriminator layer의 모든 intermediate feature에 대한 $\ell_{1}$ distance로 계산됨

- $\mathcal{L}_{mel}(G)$ : 합성된 mel-spectrogram과 ground-truth 간의 spectral $\ell_{1}$ regression loss

- 이때 generator는 transposed convolution stack과 Anti-aliased Multi-Periodicity composition (AMP) module로 구성됨

3. Experiments

- Settings

- Dataset : Chinese speech corpus

- Comparisons : DurIAN, DurIAN-E, FastSpeech2, DiffSpeech, VITS

- Results

- MCD, BAP, $F0$, V/UV prediction error 측면에서, 제안된 DurIAN-E2가 가장 우수한 성능을 보임

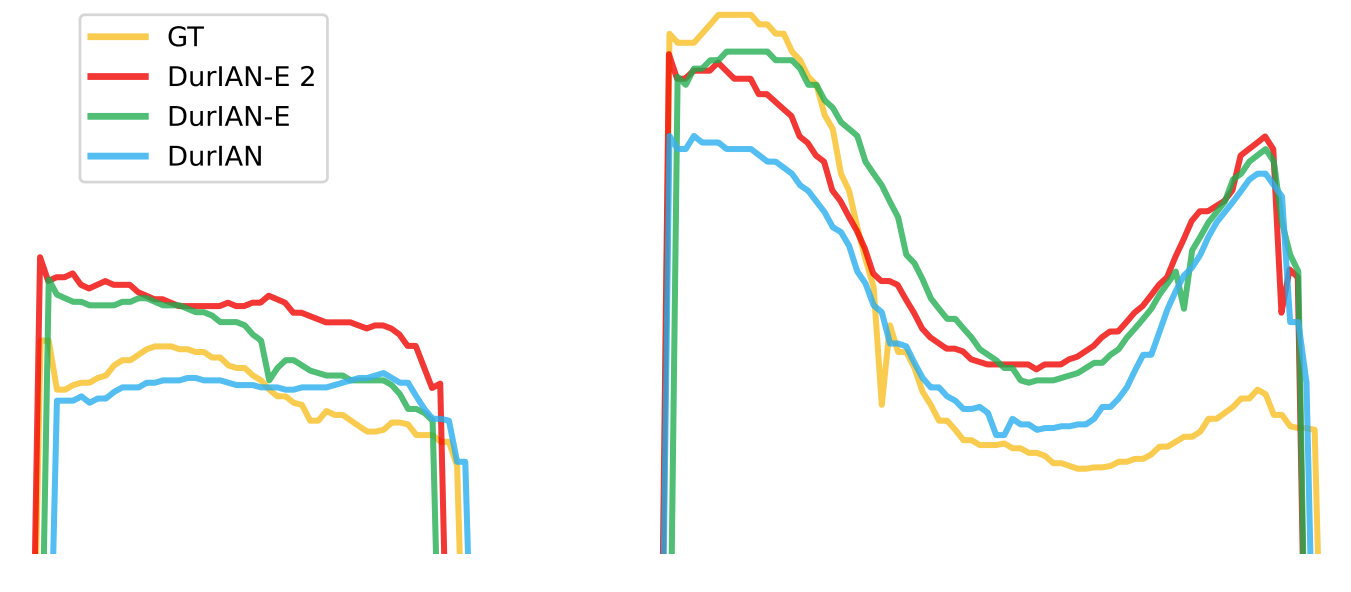

- Pitch contour 측면에서 비교해 보면, DurIAN-E2는 기존 DurIAN 보다 변화가 큰 $F0$ curve를 나타냄

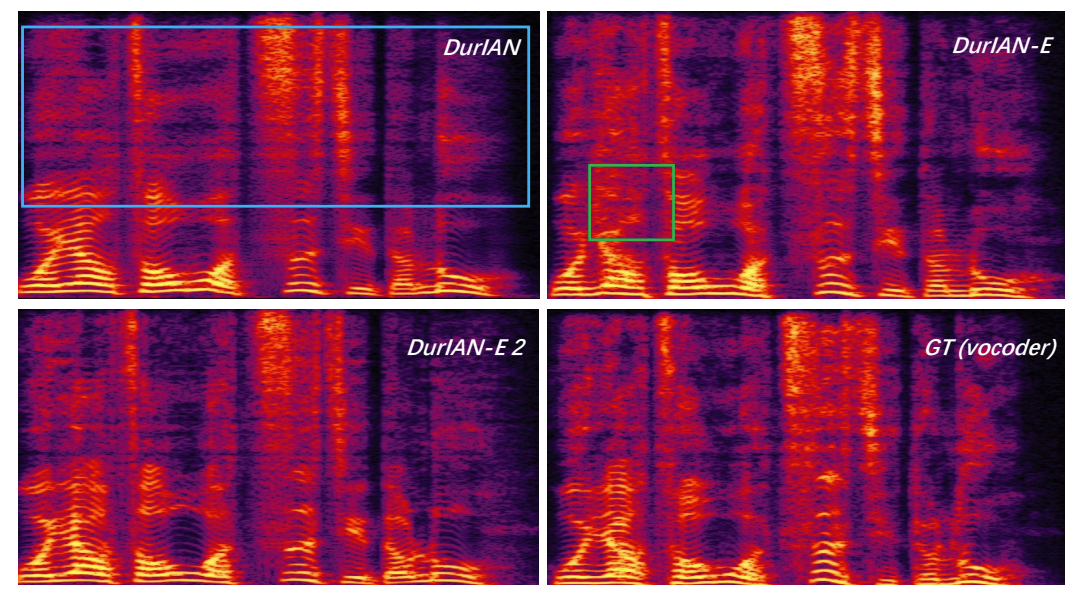

- 특히 mel-spectrogram 측면에서, DurIAN-E2는 더 명확한 harmonic structure와 ground-truth와 비슷한 spectral detail을 생성할 수 있음

- MOS 측면에서도 마찬가지로 DurIAN-E2가 가장 우수한 품질을 보임

반응형

'Paper > TTS' 카테고리의 다른 글

댓글