티스토리 뷰

Paper/TTS

[Paper 리뷰] StyleSpeech: Self-Supervised Style Enhancing with VQ-VAE-based Pre-training for Expressive Audiobook Speech Synthesis

feVeRin 2024. 5. 15. 11:30반응형

StyleSpeech: Self-Supervised Style Enhancing with VQ-VAE-based Pre-training for Expressive Audiobook Speech Synthesis

- Audiobook을 위한 음성 합성은 generalized architecture와 training data의 unbalanced style distribution으로 인해 한계가 있음

- StyleSpeech

- Expressive audiobook synthesis를 위해 VQ-VAE-based pre-training을 통한 self-supervised style enhancing method를 적용

- Text style encoder는 large-scale unlabeled text-only data로 pre-train 됨

- VQ-VAE-based spectrogram style extractor는 complex style variation을 cover 하는 audio data를 사용하여 self-supervised 방식으로 pre-train 됨

- 이후 2개의 encoder-decoder path를 가지는 architecture를 활용하여 style extractor의 guidance에 따라 pronunciation과 high-level style을 각각 모델링함

- 논문 (ICASSP 2024) : Paper Link

1. Introduction

- 기존 Text-to-Speech (TTS) 모델들은 대부분 neutral speaking style로 음성을 합성하므로 expressiveness의 한계가 존재함

- 특히 audiobook과 같은 long-form expressive data에 대해서는 wide-ranging voice characteristic으로 인해 averaged prosodic style로 collapse 되는 경향이 있음

- 이때 해당 prosody 문제를 개선하기 contextual informaiton을 반영하는 hierarchical context encoder나 BERT embedding 등을 추가하여 style prediction을 개선하는 방법들을 고려할 수 있음

- BUT, phoneme, timbre, style 등 너무 많은 information이 encoder에 mix 되므로 mel-spectrogram decoder로 쉽게 처리하기 어려움 - 추가적으로 audiobook dataset의 style distribution은 unbalance 하므로, style이나 expressiveness representation을 모델링하는데 근본적인 한계가 있음

- Dataset에서 대부분의 sentence는 plain narration voice를 가지고 일부만 rich style variation을 가짐

-> 그래서 음성 합성에서 expressiveness 문제를 해결하기 위해 VQ-VAE-based pre-training을 통한 self-supervised style enhancing method인 StyleSpeech를 제안

- StyleSpeech

- 먼저 StyleSpeech의 text style encoder는 unlabeled text-only data를 통해 pre-training 됨

- 다음으로 VQ-VAE-based spectrogram style extractor는 여러 domain의 expressive scenario를 cover 하는 large audio data를 사용하여 pre-train 됨

- 이후 style extractor의 guidance에 따라 2개의 encoder-decoder path를 가지는 architecturer를 채택

< Overall of StyleSpeech >

- 더 나은 style representation latent space를 모델링하고 unbalanced style distribution 문제를 완화하는 VQ-VAE-based style extractor를 도입하고 self-supervised 방식으로 complex style variation을 반영

- Pronunciation과 high-level style expressiveness variation을 각각 모델링하는 2개의 encoder-decoder path를 가지는 TTS architecture

- 결과적으로 기존보다 더 나은 naturalness와 expressiveness를 달성

2. Method

- StyleSpeech는 interaction이 있는 2개의 encoder-decoder path (Fine-grained phoneme path, Coarse-grained style path)로 구성됨

- Phoneme Encoder-Decoder Path

- Phoneme encoder-decoder path는 pronunciation 추출을 목표로 함

- 여기서 FastSpeech2를 기반으로 phoneme encoder와 decoder는 self-attention layer, 1D convolution, residual connection, layer normalization을 가지는 Feed-Forward Transformer (FFT) block으로 구성됨

- 아래 그림과 같이 phoneme hidden embedding $\mathcal{H}_{p}$는 extended variance adaptor의 Length Regulator (LR)에 의해 frame-level phoneme representation $\mathcal{H}'_{p}$로 repeat 됨

- 이때 해당 path는 pitch, energy 등을 반영하지 않고 $\mathcal{H}'_{p}$만 phoneme decoder에 전달함

- Style Encoder-Decoder Path

- Style encoder-decoder path는 합성된 음성에 대한 style 모델링을 목표로 함

- Text style encoder와 spectrogram style extractor는 각각 contextual text와 mel-spectrogram에서 style-related representation을 학습하도록 pre-train 됨

- 추가적으로 style decoder는 decoding stage에서 explicit/implicit style reprsentation을 잘 fusion 하기 위해 채택됨

- Style Encoder

- Context-aware Augmented Deep Embedded Clustering (CADEC) encoder를 style encoder로써 채택함

- 여기서 semantic feature를 추출하기 위해 pre-trained BERT를 backbone으로 사용하고 emotion feature를 추출하기 위해 emotion lexicon을 사용

- 특히 data augmentation을 통한 contrastive learning과 autoencoder를 활용한 deep embedded clustering을 통해 unlabeled plain text에 대해서도 context로부터 style-related represnetation을 얻을 수 있음

- 결과적으로 CADEC encoder는 contextual text $C$를 통해 global style representation을 output 함:

(Eq. 1) $\mathcal{H}_{s}=CADEC(C_{0})$

(Eq. 2) $\mathcal{H}_{cs}=Concat[CADEC(C_{i}),\, i=-k,...,k]$

- $Concat[\cdot]$ : concatenation operation

- $\mathcal{H}_{s}$ : current utterance의 contextual text $C_{0}$에 대한 hidden style embedding

- $\mathcal{H}_{cs}$ : $2k+1$ neighbor utterance에 대한 hidden style embedding

- Context-aware Augmented Deep Embedded Clustering (CADEC) encoder를 style encoder로써 채택함

- Extended Variance Adaptor

- FastSpeech2를 기반으로 하는 extended variance adaptor는 duration, pitch, energy 등의 style-related feature를 explicit 하게 모델링함

- 이를 위해 phoneme encoder output $\mathcal{H}_{p}$와 style encoder output $\mathcal{H}_{s}$는 서로 add 되어 $\mathcal{H}_{ps}$로써 각각 pitch/energy/duration predictor로 전달됨

- 예측된 pitch와 energy는 implicit style embedding $\mathcal{H}_{s}$와 함께 repeat 되어 length regulator에 의해 $\mathcal{H}'_{s}$를 embedding 하는 frame-level style embedding이 됨

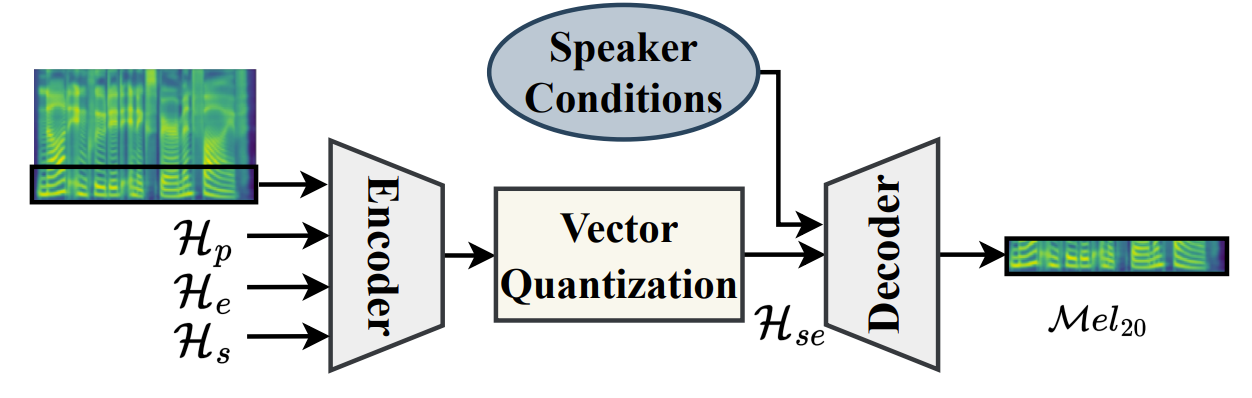

- Style Extractor

- 아래 그림과 같이 unlabeled large-scale audio dataset의 mel-spectrogram에서 style-related latent representation을 추출하기 위해 VQ-VAE를 style extractor로써 채택함

- 여기서 encoder와 decoder는 batch normalization, ReLU activation을 가지는 2개의 2D convolution과 여러 ResBlock layer를 사용해 대칭적으로 구성됨

- 추가적으로 one-hot speaker embedding condition도 decoder에 전달되어 timbre의 영향을 제거함

- 이때 mel-spectrogram의 low-frequency band (각 frame 당 첫 20개 bin) $\mathcal{M}el_{20}$만을 input으로 사용함

- 이는 full band에 비해 더 적은 content information을 가지면서 거의 완전한 style을 포함하고 있기 때문 - 추가적으로 style-related latent representation을 추출할 수 있도록 model을 guide 하기 위해, frame-level pitch $\mathcal{H}_{p}$, frame-level energy $\mathcal{H}_{e}$, text feature $\mathcal{H}_{s}$를 additional input으로 사용함

- 최종적으로 다음과 같이 well-pretrained style extractor의 vector quantization layer ouput에서 discrete style-related representation $\mathcal{H}_{se}$를 추출할 수 있음:

(Eq. 3) $\mathcal{H}_{se}=VQ\text{-}VAE(\mathcal{M}el_{20},\mathcal{H}_{p},\mathcal{H}_{e},\mathcal{H}_{s})$

- 아래 그림과 같이 unlabeled large-scale audio dataset의 mel-spectrogram에서 style-related latent representation을 추출하기 위해 VQ-VAE를 style extractor로써 채택함

- Style Decoder

- Style decoder는 decoding stage에서 pitch/energy와 같은 explicit style feature와 implicit style embedding을 integrating 하도록 설계됨

- 이를 위해 hierarchical context를 반영할 수 있는 residual connection이 있는 cross-attention module이 사용됨

- 여기서 current utterance의 frame-level style embedding $\mathcal{H}'_{s}$을 query로, style encoder의 hierarchical context style embedding $\mathcal{H}_{ce}$를 key/value로 사용함 - 최종적으로 batch normalization, ReLU activation을 가지는 1D-convolustion layer를 사용하여 style-related representation을 학습하고 style embedding $\mathcal{H}_{sd}$를 output 함

- Interaction Between Phoneme and Style Paths

- 기존의 expressive TTS 작업은 style information을 단순히 encoder에 추가하므로 mel-spectrogram decoder에 대한 문제가 발생함

- 따라서 StyleSpeech는 encoder 뿐만 아니라 mel-spectrogram decoder에도 phoneme과 style path에 대한 feature interaction을 추가

- 구체적으로,

- Style decoder의 output embedding $\mathcal{H}_{sd}$는 style과 pronunciation information을 fully integrate 하기 위해 additional style input으로 phoneme decoder의 각 FFT block에 전달됨

- 이후 2개의 encoder-decoder path를 기반으로 하는 mel-spectrogram decoder의 well-mixed output embedding $\mathcal{H}'_{ps}$를 post-linear layer에 전달하여 최종적으로 mel-spectrogram을 reconstruct 함

- Training Strategy and Inference Procedure

- StyleSpeech는 다음의 3-stage로 학습됨

- First stage에서 style encoder는 large-scale text data로 training 되고,

- Second stage에서는 large-scale audio data를 사용하여 style extractor를 training 함

- 이때 기존 VQ-VAE와 비슷하게 total training loss는 mel-spectrogram reconstruction loss, dictionary upadate를 위한 vector quantization loss, encoder의 embedding commit을 위한 commitment loss로 구성됨 - Third stage에서는 전체 TTS model이 audiobook data를 통해 training 됨

- 여기서 style encoder와 style extractor의 parameter는 gradient update 없이 frozen 됨

- 추가적으로 style loss $\mathcal{L}_{style}$이 pre-trained style extractor에 대한 guidance를 제공하기 위해 encoder-decoder path에 적용됨:

(Eq. 4) $\mathcal{L}_{style}=MSE(\mathcal{H}_{sd},\mathcal{H}_{se})$

- $MSE$ : Mean Square Error loss, $\mathcal{H}_{sd}$ : style decoder output, $\mathcal{H}_{se}$ : style extractor output - 결과적으로 total loss는:

(Eq. 5) $\mathcal{L}_{total}=\mathcal{L}_{tts}+\alpha\mathcal{L}_{style}$

- $\mathcal{L}_{tts}$ : FastSpeech2의 loss와 같음

- 추론 시 style extractor는 사용되지 않음

- 결과적으로 StyleSpeech는 phoneme과 context input을 사용하여 expressive style로 음성을 합성함

3. Experiments

- Settings

- Dataset : Madarin Dataset (internal)

- Comparisons : FastSpeech2, FastSpeech2+CADEC

- Results

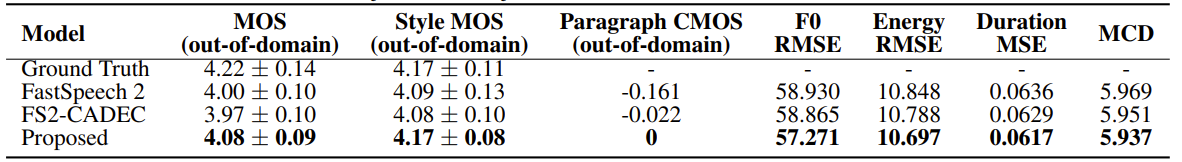

- Subjective/Objective Comparison

- 정성적, 정량적 metric 모두에서 제안된 StyleSpeech가 가장 우수한 성능을 보임

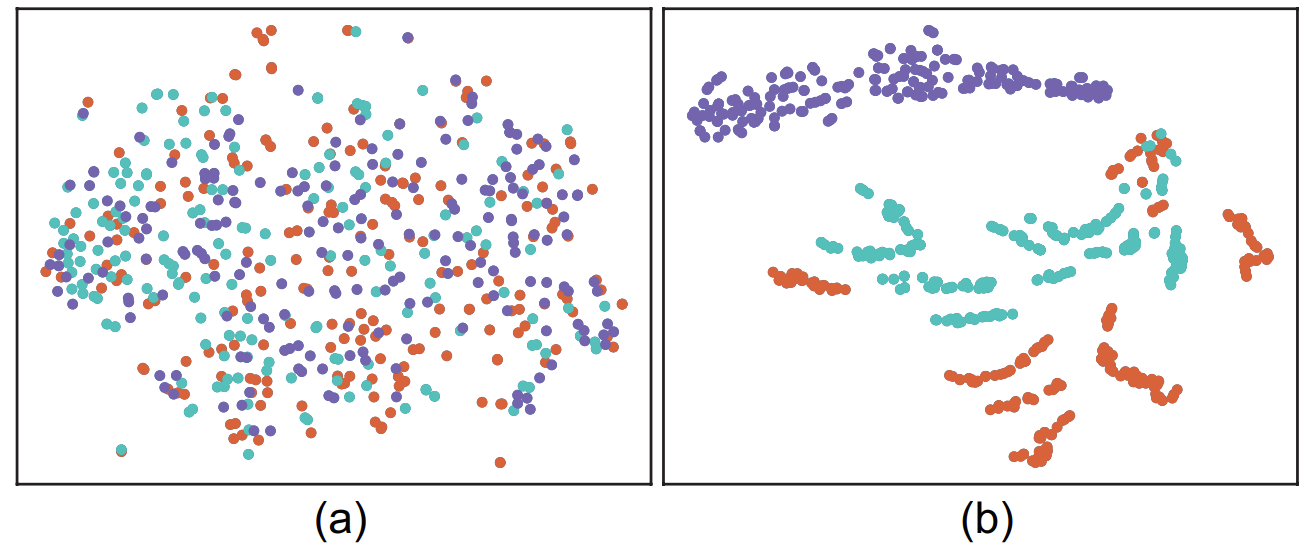

- Analysis for the Pre-training Strategy

- Style embedding에 대한 $t$-SNE 결과를 확인해 보면, large dataset을 사용했을 때 각 style들이 더 나은 cohesion과 distribution을 보임

- 즉, unbalance 하고 limit 된 audiobook dataset만으로 style representation latent를 학습하는 데는 한계가 있으므로, large dataset을 통한 pre-training을 사용하는 것이 성능 향상에 효과적임

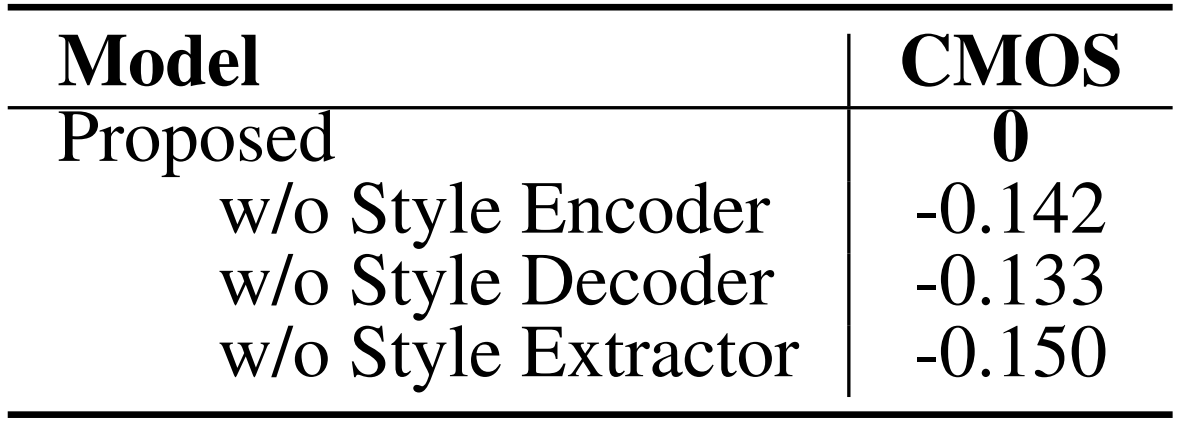

- Ablation Study

- Ablation study 측면에서 style encoder, style decoder, style extractor를 제거했을 때 성능 저하가 발생함

- 즉, 각 component 모두 StyleSpeech의 성능 향상에 주요함

반응형

'Paper > TTS' 카테고리의 다른 글

댓글