티스토리 뷰

Paper/Vocoder

[Paper 리뷰] AF-Vocoder: Artifact-Free Neural Vocoder with Global Artifact Filter

feVeRin 2025. 8. 21. 17:04반응형

AF-Vocoder: Artifact-Free Neural Vocoder with Global Artifact Filter

- Generative Adversarial Network 기반의 vocoder는 audible artifact로 인한 합성 품질의 한계가 있음

- AF-Vocoder

- Artifact removal을 위해 frequency-domain artifact filter인 GAFilter를 도입

- GAFilter는 frequency control을 위해 desired inductive bias를 enforce 함

- 논문 (INTERSPEECH 2025) : Paper Link

1. Introduction

- Vocoder는 acoustic feature를 speech waveform으로 변환하는 것을 목표로 함

- 특히 BigVGAN과 같은 Generative Adversarial Network (GAN) 기반의 vocoder는 higher speed로 high-quality speech를 생성할 수 있음

- BUT, GAN-based vocoder는 imperfect upsampling으로 인한 aliasing artifact, spectral detail loss로 인한 blurring artifact의 문제가 있음

-> 그래서 artifact를 효과적으로 filtering 할 수 있는 AF-Vocoder를 제안

- AF-Vocoder

- Learned frequency control을 통해 artifact를 처리하는 Global Artifact Filter (GAFilter)를 도입

- 해당 GAFilter를 기반으로 GAN-based Vocoder인 AF-Vocoder를 구성

< Overall of AF-Vocoder >

- GAFilter를 활용한 artifact-free vocoder

- 결과적으로 기존보다 우수한 성능을 달성

2. Method

- Overall Framework

- 논문은 GAN-based vocoder를 기반으로 주어진 mel-spectrogram $m\in M$을 artifact-free high-fidelity speech waveform $s\in S$로 변환하는 generative model $\Psi_{\theta}:M\rightarrow S$를 구축하는 것을 목표로 함

- 이때 AF-Vocoder는 BigVGAN과 마찬가지로 input feature를 upsampling 하고, temporal resolution을 progressively restore 하기 위해 stacked ConvTranspose1D layer를 활용함

- 각 upsampling layer 뒤에는 periodic inductive bias를 제공하기 위해 Snake activation을 포함한 Multi-Periodicity Composition (MPC) module을 도입함

- MPC module은 parallel residual block으로 구성되고, 각 block에는 dilated Conv1D layer, Conv1D-1$\times$1 layer, Snake activation이 포함됨

- 추가적으로 artifactr-free result를 얻기 위해 논문은 frequency-control inductive bias를 도입하고 frequency-domain artifact filter인 GAFilter를 적용함

- 해당 GAFilter는 last MPC module과 integrate 되어 Artifact-Free MPC (AF-MPC) architecture를 구성함 - 결과적으로 AF-Vocoder의 pipeline은:

- 먼저 주어진 input mel-spectrogram $m\in \mathbb{R}^{F\times T}$에 대해, Conv1D layer는 frequency dimension $F$를 higher-dimensional latent space로 project 함

- 이를 통해 speech의 intrinsic representation을 추출함 - 이후 MPC module을 따라 ConvTranspose1D layer가 temporal resolution을 progressively restore 하면서 frequency dimensionality를 reduce 함

- 이때 last MPC module은 residual artifact를 eliminate 하기 위해 AF-MPC로 replace 됨 - 최종적으로 Snake activation, GAFilter, Conv1D, Tanh activation을 통해 final waveform에 대한 post-processing stage를 수행함

- 먼저 주어진 input mel-spectrogram $m\in \mathbb{R}^{F\times T}$에 대해, Conv1D layer는 frequency dimension $F$를 higher-dimensional latent space로 project 함

- 추가적으로 AF-Vocoder는 BigVGAN 외에도 Slicing Adversarial Network (SAN) framework에 기반한 BigVSAN architecture를 활용할 수 있음

- 이때 AF-Vocoder는 BigVGAN과 마찬가지로 input feature를 upsampling 하고, temporal resolution을 progressively restore 하기 위해 stacked ConvTranspose1D layer를 활용함

- GAFilter: Global Artifact Filter

- GAFilter는 diverse artifact가 frequency-domain 내에서 anomalous residual component로 consistently manifest 한다는 것에 기반함

- 이를 위해 artifact를 autonomously suppress 하는 frequency-domain filter를 고려할 수 있음

- 따라서 GAFilter는 frequency control을 위한 inductive bias를 도입하고, temporally invariant 한 full frequency band에서 동작하는 global filter로 구성됨 - 특히 GAFilter는 다음의 이유로 인해 last upsampling layer에만 적용됨:

- Last upsampling layer 이후에 temporal resolution이 fully restore 되고, 다른 MPC module의 intermediate feature는 limited interpretability를 가지기 때문

- 해당 design을 통해 intermediate feature learning에 대한 constraint를 relax 하고 model complexity를 reduce 할 수 있기 때문

- 구조적으로 GAFilter는 STFT moduel $\Gamma$, learnable filter, iSTFT module $\Gamma^{-1}$로 구성됨

- Hidden feature $z\in\mathbb{R}^{B\times C\times T}$가 주어지면, STFT module은 이를 frequency-domain feature $Z\in \mathbb{C}^{B\times C\times F\times T}$로 transform 함

- Learnable parameter $W\in\mathbb{R}^{1\times C\times F\times 1}$을 가진 frequency filter가 $Z$에 적용되어 artifact-free feature $Z'$을 얻음

- 최종적으로 iSTFT를 통해 time resolution을 recover 하고 artifact-free feature $z'$을 output 함:

(Eq. 1) $z'=\Gamma^{-1}(\Gamma(z)*W)$

- $*$ : broadcasting element-wise multiplication

- 이를 위해 artifact를 autonomously suppress 하는 frequency-domain filter를 고려할 수 있음

- Training Objective

- GAN training을 위한 objective는:

(Eq. 2) $ \mathcal{L}_{adv}(G)=\sum_{k}\left[ \mathcal{L}_{adv}(G;D_{k})+ \lambda_{fm}\mathcal{L}_{fm}(G;D_{k})\right]$

(Eq. 3) $\mathcal{L}_{G}=\mathcal{L}_{adv}(G)+\lambda_{mel}\mathcal{L}_{mel}(G)$

(Eq. 4) $\mathcal{L}_{D}=\sum_{k}\left[\mathcal{L}_{adv}(D_{k};G)\right]$

- $\mathcal{L}_{adv}$ : least-square GAN loss

- $\mathcal{L}_{fm}$ : feature matching loss

- $\mathcal{L}_{mel}$ : mel-spectrogram loss

- $\lambda_{fm}, \lambda_{mel}$ : control scalar

3. Experiments

- Settings

- Results

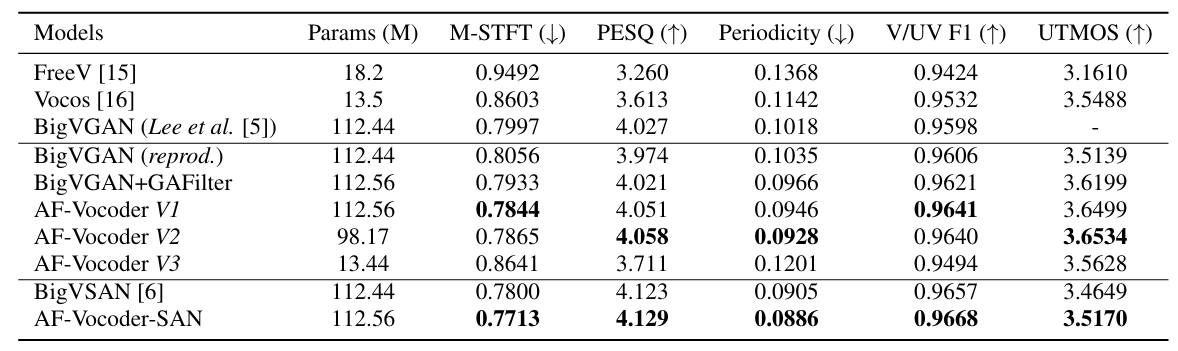

- 전체적으로 AF-Vocoder의 성능이 가장 우수함

- MOS 측면에서도 AF-Vocoder가 더 뛰어남

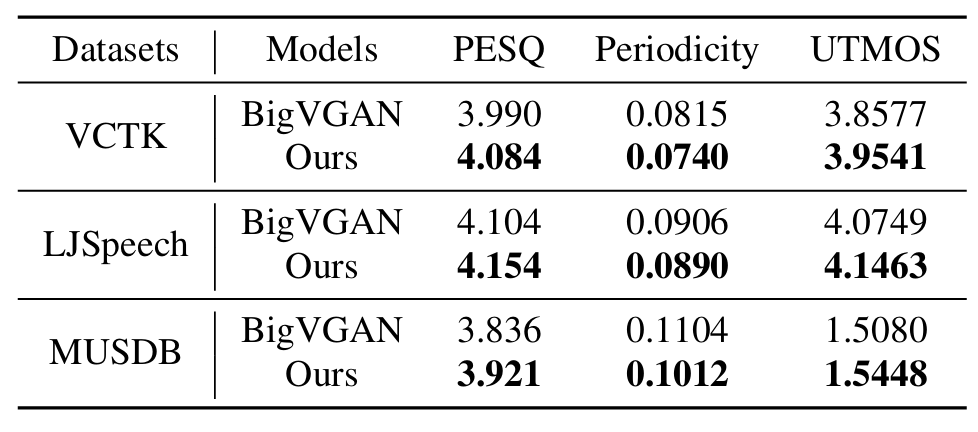

- Unseen scenario에 대해서도 우수한 성능을 보임

- Analysis

- AF-Vocoder는 blurring artifact가 적고 ground-truth에 가까운 output을 얻을 수 있음

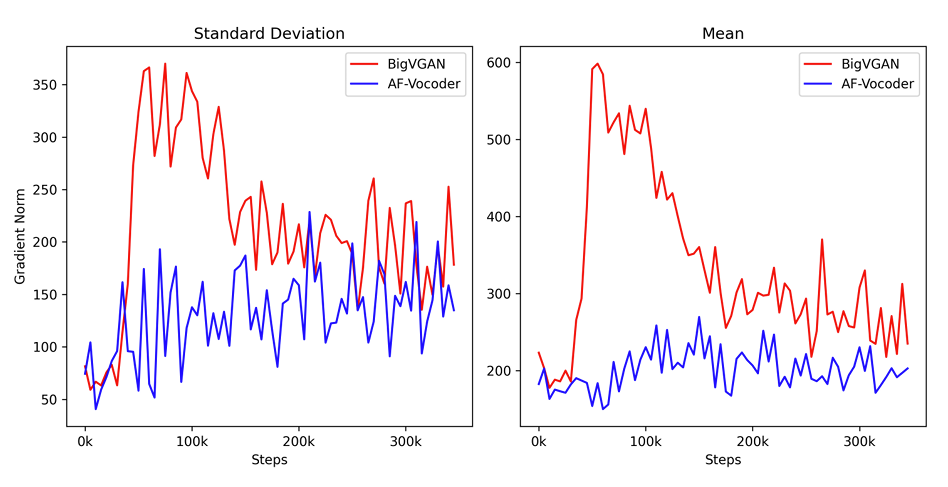

- AF-Vocoder는 더 stable 한 gradient curve를 가짐

반응형

'Paper > Vocoder' 카테고리의 다른 글

댓글