티스토리 뷰

Paper/TTS

[Paper 리뷰] MPE-TTS: Customized Emotion Zero-Shot Text-to-Speech Using Multi-Modal Prompt

feVeRin 2025. 7. 10. 17:02반응형

MPE-TTS: Customized Emotion Zero-Shot Text-to-Speech Using Multi-Modal Prompt

- Multi-modal prompt를 zero-shot Text-to-Speech에 활용할 수 있음

- MPE-TTS

- 다양한 prompt에서 emotion information을 추출하기 위해 Multi-Modal Prompt Emotion Encoder를 도입

- 추가적으로 prosody predictor와 emotion consistency loss를 적용

- 논문 (INTERSPEECH 2025) : Paper Link

1. Introduction

- Zero-Shot Text-to-Speech (ZS-TTS)는 unseen style의 speech를 생성하는 것을 목표로 함

- Speech-based ZS-TTS는 unseen speaker에 대한 speech를 생성하고, 이때 semantic acoustic information을 모두 포함한 speech clip을 사용함

- 대표적으로 Meta-StyleSpeech, GenerSpeech는 reference speech clip을 다양한 timbre, emotion, prosody 등을 포함한 style feature로 modeling 함

- BUT, feature entanglement로 인해 fine-grained cutomization이 어려움

- Text-based ZS-TTS는 PromptTTS, InstructTTS와 같이 text description을 prompt로 사용함

- BUT, specific style에 대한 accurate natural language description을 구성하기 어려움 - 한편으로 MM-TTS와 같이 multi-modal을 활용한 ZS-TTS model을 구성할 수도 있음

- BUT, MM-TTS 역시 speech generation 측면에서 여전히 한계가 있음

- Speech-based ZS-TTS는 unseen speaker에 대한 speech를 생성하고, 이때 semantic acoustic information을 모두 포함한 speech clip을 사용함

-> 그래서 text, image, speech의 여러 modality를 활용한 customizable ZS-TTS model인 MPE-TTS를 제안

- MPE-TTS

- Speech, text, image의 다양한 prompt modality를 지원하고 효과적인 emotion information 추출을 위해 Multi-Modal Prompt Emotion Encoder (MPEE)를 도입

- Hierarchical disentangling strategy를 적용하여 서로 다른 granularity의 speech feature를 modeling

- 추가적으로 LLM-like prosody predictor와 Emotion Consistency Loss (ECL)을 사용하여 naturalness를 향상

< Overall of MPE-TTS >

- 다양한 modality의 prompt를 활용한 zero-shot TTS model

- 결과적으로 기존보다 우수한 성능을 달성

2. Method

- MPE-TTS는 Multi-Modal Prompt Emotion Encoder (MPEE), diffusion-based acoustic model, LLM-like prosody predictor로 구성됨

- MPEE는 arbitrary emotion prompt에서 emotion code를 추출함

- Diffusion-based acoustic model은 target mel-spectrogram을 생성함

- 구조적으로는 timbre encoder, content encoder, prosody encoder, duration predictor (DP), length regulator (LR), diffusion decoder로 구성됨 - LLM-like prosody predictor는 local/long-range dependency를 capture 하는 LLM ability를 활용하여 content, emotion, timbre에 기반한 prosody distribution을 fit 함

- 추론 시에는 주어진 text sequence의 content, reference speech의 timbre, prosody predictor에 의해 predict 된 prosody를 integrate 함

- Disentangling Strategy

- Fine-grained customization을 위해서는 content, emotion, timbre, prosody 등을 disentangle 해야 함

- 이때 각 feature는 coarse-grained, fine-grained feature로 나눌 수 있음:

- Coarse-grained Feature

- 논문은 speech segment 내에서 거의 변하지 않는 timbre, emotion feature를 coarse-grained feature로 취급함

- 해당 feature는 global vector로 modeling 됨 - Fine-grained Feature

- Content, prosody feature는 fine-grained feature로 취급됨

- 특히 content의 경우 frame-related, temporal 하므로 semantic accuracy를 보장하기 위해 fine-grained modeling이 필요하고, prosody 역시 high dynamic range를 가지므로 frame-level modeling이 필요함

- Coarse-grained Feature

- 이후 information filtering을 위해 AutoVC의 bottleneck을 적용하고 encoder를 통해 disentangling을 수행함

- 특히 same speaker의 random sentence에서 timbre encoder를 통해 global speaker vector를 추출하여 timbre와 content information을 disentangle 함 - 추가적으로 VQ-based prosody encoder는 ground-truth mel-spectrogram의 low 20 bin에서 ground-truth prosody feature를 추출함

- 이때 각 feature는 coarse-grained, fine-grained feature로 나눌 수 있음:

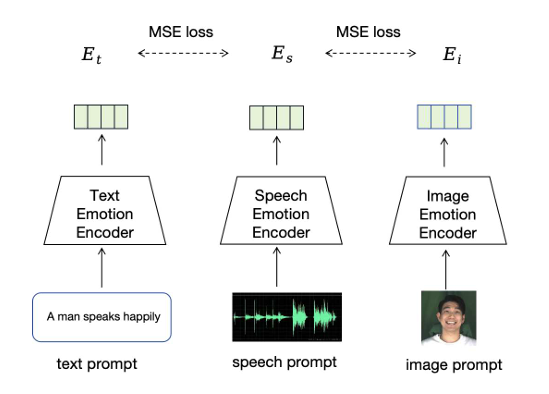

- Multi-Modal Prompt Emotion Encoder

- Generated speech의 emotion에 대한 flexible control을 위해서는 text, image, speech input prompt로부터 emotion frature를 추출할 수 있어야 함

- 이를 위해 먼저 논문은 pre-trained Emotion2Vec을 speech emotion enocder로 채택함

- Text, image encoding의 경우, MM-TTS와 같이 fixed CLIP encoder에 learnable adapter layer를 add 함 - 이후 text, image, speech modality를 unified emotion latent space로 unify 하기 위해, text emotion encoder와 image emotion encoder를 Mean Squared Error (MSE) loss로 training 함

- 결과적으로 얻어지는 MPEE loss는:

(Eq. 1) $\mathcal{L}_{MPEE}=\text{MSE}(E_{t},E_{s})+\text{MSE}(E_{i},E_{s})$

- $E_{t},E_{i}, E_{s}$ : 각각 text prompt, image prompt, speech prompt의 emotion code

- 이를 위해 먼저 논문은 pre-trained Emotion2Vec을 speech emotion enocder로 채택함

- LLM-like Prosody Predictor

- Autoregressive Transformer는 local/long-range dependency를 효과적으로 capture 할 수 있음

- 따라서 논문은 prosody predictor로써 content/timbre/emotion에서 target prosody를 modeling 하는 LLM-like model을 구성함

- 먼저 prosody predictor training을 위해 ground-truth mel-spectorgram의 low 20 bin에서 ground-truth prosody code를 추출하는 VQ-based prosody encoder를 도입함

- 해당 bin은 almost complete prosody를 포함하면서 full band에 비해 적은 timbre, content information를 가짐

- 이때 emotion을 다른 speech feature와 disentangle 하기 위해, emotion code는 similar label을 가지지만 서로 다른 speaker, content를 가진 selected speech clip에서 추출됨

- 이후 prosody predictor는 Cross-Entropy loss를 통해 teacher-forcing mode로 training 됨

- 추가적으로 논문은 predicted prosody의 emotion information을 preserve 하기 위해 Emotion Consistency Loss (ECL)을 도입함

- 즉, prosody predictor에 classifier를 add 하여 predicted prosody code에서 emotion을 recognize 한 다음, predicted result와 emotion label 간의 consistency를 achieve 하도록 함

- Diffusion-based Acoustic Model

- Acoustic model backbone은 content encoder, timbre encoder, prosody encoder, duration predictor (DP), length regulator (LR), diffusion decoder로 구성됨

- Content encoder는 local information을 capture 하는 Conformer-based model을 사용하고, DP는 content/timbre/prosody를 combine 하여 phoneme duration을 predict 해 accurate duration을 제공함

- LR은 phoneme-level latent를 mel-level latent로 upsampling 하고, Grad-TTS 기반의 diffusion-based decoder는 high-quality speech generation을 지원함 - 특히 논문은 duration loss, diffusion loss, VQ loss를 acoustic model training에 적용함

- Training 이후에는 trained prosody encoder를 사용하여 prosody predictor training을 위한 target prosody feature를 생성함

- Content encoder는 local information을 capture 하는 Conformer-based model을 사용하고, DP는 content/timbre/prosody를 combine 하여 phoneme duration을 predict 해 accurate duration을 제공함

3. Experiments

- Settings

- Dataset : LibriTTS, MEAD-TTS

- Comparisons : Meta-StyleSpeech, GenerSpeech, MM-TTS

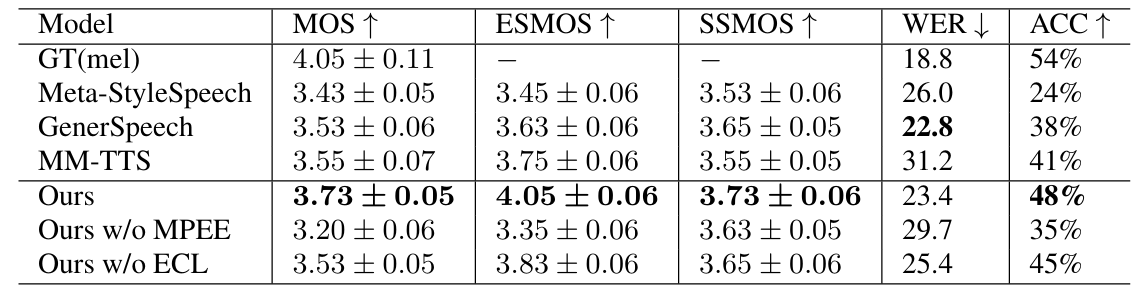

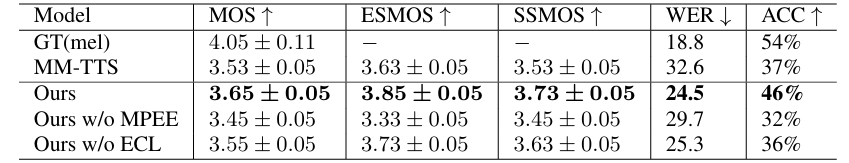

- Results

- 전체적으로 MPE-TTS의 성능이 가장 우수함

- Text prompt에 대해서도 MPE-TTS는 뛰어난 성능을 보임

- Image prompt를 사용하는 경우에도 MPE-TTS의 성능이 가장 뛰어남

반응형

'Paper > TTS' 카테고리의 다른 글

댓글