티스토리 뷰

Paper/Language Model

[Paper 리뷰] HALL-E: Hierarchical Neural Codec Language Model for Minute-Long Zero-Shot Text-to-Speech Synthesis

feVeRin 2025. 3. 15. 14:04반응형

HALL-E: Hierarchical Neural Codec Language Model for Minute-Long Zero-Shot Text-to-Speech Synthesis

- Discrete audio token을 활용하는 Large Language Model 기반의 text-to-speech model은 high frame rate로 인해 long-form speech synthesis가 어려움

- HALL-E

- Multi-Resolution Requantization을 도입해 neural audio codec의 frame rate를 절감

- 이때 teacher-student distillation으로 discrete audio token을 reorganize 하는 Multi-Resolution Residual Vector Quantization module을 incorporate 함 - Multi-Resolution Requantization의 hierarchical token을 기반으로 한 Large Language Model을 설계

- Multi-Resolution Requantization을 도입해 neural audio codec의 frame rate를 절감

- 논문 (ICLR 2025) : Paper Link

1. Introduction

- Large Language Model (LLM)-based Text-to-Speech (TTS)는 complex speech structure와 pattern을 효과적으로 modeling 하고 zero-shot manner로 natural-sounding speech를 생성할 수 있음

- 특히 LLM-based TTS는 natural language text를 audio token sequence로 translate 하는 것을 목표로 함

- 이를 위해 SoundStream, DAC, AudioDec과 같이 vector quantization을 통해 audio signal을 discrete token으로 quantization 하는 frozen Neural Audio Codec (NAC)이 사용됨

- BUT, NAC model을 활용하는 LLM-based TTS는 extended period에 대한 long-context를 handle 하지 못함

- 초당 audio token length가 상당히 크기 때문

- 대표적으로 VALL-E는 audio token을 예측할 때, NAC model의 Residual Vector Quantization (RVQ) first layer에서 high frame rate로 인한 문제가 존재함

- BUT, 단순히 NAC model에서 frame rate를 reduce 하는 경우 audio quality가 저하되고 incorrect phoneme pronunciation이 나타남

- 특히 LLM-based TTS는 natural language text를 audio token sequence로 translate 하는 것을 목표로 함

-> 그래서 NAC model과 LLM-based TTS를 효과적으로 bridge 하는 HALL-E를 제안

- HALL-E

- Lower quantization layer에서 frame rate를 reduce 하기 위해 pre-trained RVQ module을 hierarchically reorganizing 하는 Multi-Resolution Requantization (MReQ)를 도입

- MReQ는 Multi-Resolution Residual Vector Quantization (MRVQ)를 pre-trained NAC model에 incorporate 하고 teacher-student distillation으로 training 함 - MReQ의 hierarchical token을 predict 하는 hierarchical LLM-based TTS model을 설계

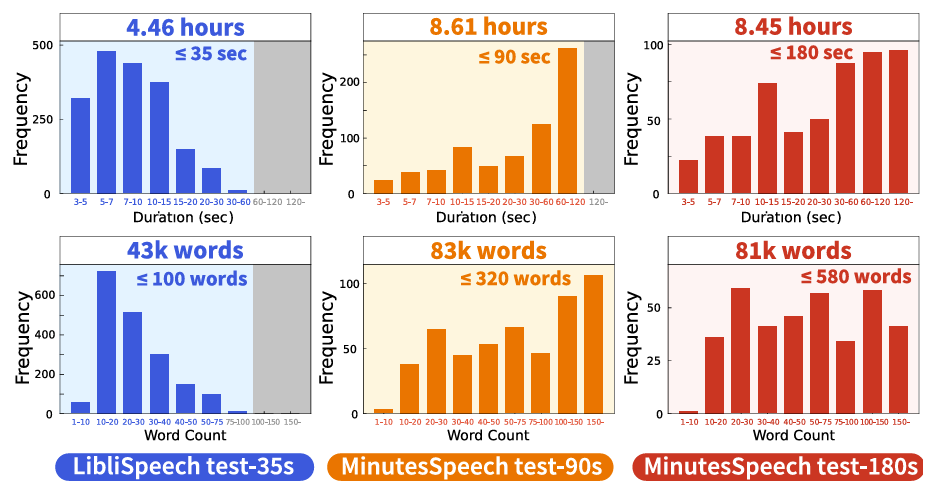

- 추가적으로 minute-long speech synthesis를 위해 MinuteSpeech dataset을 구성

- Lower quantization layer에서 frame rate를 reduce 하기 위해 pre-trained RVQ module을 hierarchically reorganizing 하는 Multi-Resolution Requantization (MReQ)를 도입

< Overall of HALL-E >

- Frame rate와 high quality speech 간의 trade-off를 manage 하기 위해 hierarchical post-training framework를 도입

- 결과적으로 long-form speech에 대해서도 기존보다 뛰어난 합성 성능을 달성

2. Preliminaries

- Neural Audio Codec

- NAC model은 encoder $\text{Enc}(\cdot)$, vector quantizer $\text{VQ}(\cdot)$, decoder $\text{Dec}(\cdot)$으로 구성됨

- 이때 quantizer는 discrete audio token을 생성하고, 대표적으로 Residual Vector Quantizer (RVQ) module은 다음과 같이 정의됨:

(Eq. 1) $z_{l}=\text{VQ}_{l}(x_{l-1})$

(Eq. 2) $x_{l}=x_{l-1}-\tilde{z}_{l}$

(Eq. 3) $\mathbf{h}=\sum_{l=1}^{L}\tilde{z}_{l}$

- $x_{0}=\text{Enc}(x_{\text{in}})\in\mathbb{R}^{d\times n}$ : input audio $x_{\text{in}}$에 대한 encoder output

- $d$ : latent dimension, $n$ : sequence length, $\text{VQ}_{l}$ : vector quantizer, $z_{l}\in\mathbb{N}^{n}$ : discrete token sequence

- $\tilde{z}_{l}=\text{Emb}_{l}(z_{l})\in\mathbb{R}^{d\times n}$ : learnable embedding layer $\text{Emb}_{l}(\cdot)$을 통해 얻은 $z_{l}$에 해당하는 embedding sequence

- $l\in\{1,2,...,L\}$ : layer index, $L$ : layer 수 - Output $\mathbf{h}\in\mathbb{R}^{d\times n}$은 decoder에 전달되어 input audio를 $y=\text{Dec}(\mathbf{h})$와 같이 reconstruct 함

- LLM-based TTS

- 일반적으로 LLM-based TTS는 VALL-E와 같이 AutoRegressive (AR) model $T_{\text{ar}}$과 Non-AutoRegressive (NAR) model $T_{\text{nar}}$의 두 decoder-only language model로 구성됨

- 그러면 speech synthesis procedure는 다음과 같이 정의됨:

(Eq. 4) $\hat{z}_{l}=T_{\text{ar}}(\mathbf{t},z_{1}^{\text{pr}})$

(Eq. 5) $\hat{z}_{l+1}=T_{\text{nar}}(\mathbf{t},\mathbf{h}_{L}^{\text{pr}},\hat{\mathbf{h}}_{l},l)$

(Eq. 6) $\hat{\mathbf{h}}_{l}=\sum_{l'=1}^{l}\hat{\tilde{z}}_{l'}$

(Eq. 7) $\hat{y}=\text{Dec}([\mathbf{h}_{L}^{\text{pr}},\hat{\mathbf{h}}_{L}])$

- $[\mathbf{h}_{L}^{\text{pr}},\hat{\mathbf{h}}_{L}]$ : time axis에 대한 matrix concatenation - 먼저 (Eq. 4)에서 $T_{\text{ar}}$은 text prompt $\mathbf{t}$와 audio input $x_{\text{pr}}$에서 추출된 audio prompt $z_{1}^{\text{pr}}=\text{VQ}_{1}(\text{Enc}(x_{\text{pr}}))$이 주어졌을 때 RVQ의 first layer에 해당하는 audio token sequence $\hat{z}_{1}\in\mathbb{N}^{n'}$을 생성함

- (Eq. 5)에서 $T_{\text{nar}}$은 (Eq. 6)의 accumulated hidden feature $\hat{\mathbf{h}}_{l}$과 audio prompt의 hidden feature $\mathbf {h}_{\text {pr}}$로부터 token sequence $\hat{z}_{l+1}\in\mathbb{N}^{n'}$를 iteratively generate 함

- 이후 (Eq. 7)을 통해 speech $\hat{y}$가 생성됨

- 여기서 $\text{Enc}, \text{VQ}_{1}, \text{Dec}$는 frozen NAC model에서 가져옴

- 일반적으로 LLM-based TTS model은 pre-defined context window size를 가지고 초단위의 speech data로 training 됨

- 한편으로 long speech segment를 생성하기 위해서는 NAC model의 frame rate를 reduce 해야 함

- BUT, frame rate를 48Hz 미만으로 reduce 하는 경우, 아래 그림과 같이 speech reconstruction 성능이 크게 저하됨

3. MReQ: Multi-Resolution Requantization

- MReQ는 frame rate를 reduce 하기 위해 pre-trained RVQ module을 hierarchically reorganizing 하는 post-training framework로써 사용됨

- 여기서 MReQ는 pre-trained NAC model에 Multi-Resolution Residual Vector Quantization (MRVQ)를 incorporate 하고 teacher-student distillation manner로 NAC model을 training 함

- 이를 통해 pre-trained 48Hz EnCodec의 경우 first quantization layer에서 8Hz로 frame rate가 reduce 됨

- 결과적으로 LLM-based TTS에서 longer context를 효과적으로 처리할 수 있음

- Architecture

- MRVQ module은 RVQ의 nested structrue로써 multiple Low frame-rate Residual Vector Quantization (LRVQ) block으로 구성된 residual structure를 가짐

- 여기서 각각의 block은 서로 다른 frame rate에서 동작하고 다음과 같이 정의됨:

- [Definition 1.] MRVQ Module

$x_{0}\in\mathbb{R}^{d\times n_{0}}$를 encoder ouptut라고 하자. $d$가 latent dimension이고 $n_{0}=Ts_{0}$를 time length $T$ (초), frame rate $s_{0}$ (Hz)에 대한 sequence length라고 하면, MRVQ module은 다음과 같이 정의된다:

(Eq. 8) $c_{k}=\text{LRVQ}^{(k)}_{\alpha-\beta-\gamma}(x_{k-1})$

(Eq. 9) $x_{k}=x_{k-1}-\tilde{c}_{k}$

(Eq. 10) $\mathbf{h}=\sum_{k=1}^{K}\tilde{c}_{k}$

- $\text{LRVQ}^{(k)}_{\alpha-\beta-\gamma}$ : LRVQ block, $K$ : block의 개수

- $\alpha-\beta-\gamma$ : block structure를 결정하기 위한 hyperparameter의 triplet - [Definition 2.] LRVQ Block

각 LRVQ block $\text{LRVQ}^{(k)}_{\alpha-\beta-\gamma}$는 pre-quantizer $\text{PreQ}_{\alpha}^{(k)}$, downsampling을 위한 sub-encoder $E_{k}$, main quantizer $\text{Quant}_{\beta}^{(k)}$, upsampling을 위한 sub-decoder $D_{k}$, post-quantizer $\text{PostQ}_{\gamma}^{(k)}$의 5가지 component로 구성된다. 그러면 quantization process는 다음과 같이 주어진다:

(Eq. 11) $a_{k}=\text{PreQ}_{\alpha}^{(k)}(x_{k-1})$

(Eq. 12) $b_{k}=\text{Quant}_{\beta}^{(k)}(E_{k}(\tilde{a}_{k}))$

(Eq. 13) $c_{k}=\text{PostQ}_{\gamma}^{(k)}(D_{k}(\tilde{b}_{k}))$

- $a_{k},b_{k},c_{k}$ : token sequence

여기서 3개의 quantizer $\text{PreQ}^{(k)}_{\alpha}, \text{Quant}_{\beta}^{(k)}, \text{PostQ}^{(k)}_{\gamma}$는 각각 $\alpha,\beta,\gamma$ layer와 RVQ를 사용하여 구현된다.

- [Definition 1.] MRVQ Module

- $b_{k}\in\mathbb{N}^{\beta\times n_{k}}$는 audio를 low frame rate로 represent 하는 token sequence로써, 이때 해당 length는 $n_{k}=Ts_{k}$와 같이 주어짐

- $s_{k}$ : $s_{1}<s_{2}<...<s_{K}$, $s_{K}=s_{0}$를 만족하는 frame rate

- $a_{k},c_{k}$는 LLM-based TTS model의 NAR model training을 위해서만 사용됨

- 여기서 각각의 block은 서로 다른 frame rate에서 동작하고 다음과 같이 정의됨:

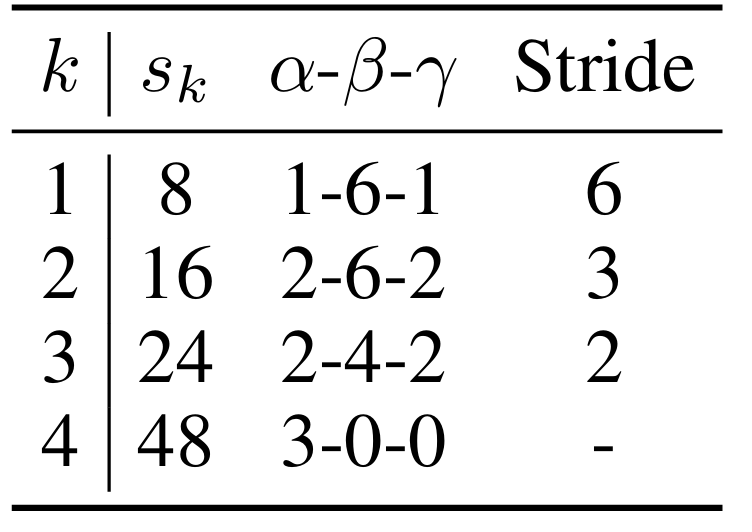

- Implementation Details

- EnCodec에 MRVQ를 적용하는 경우, frame rate는 4개의 LRVQ module을 사용하여 $s_{0}=48\text{Hz}$에서 $s_{1}=8\text{Hz}$로 reduce 됨

- LRVQ block에서 각 sub-encoder $E_{k}$는 convolution layer와 2개의 bi-LSTM layer로 구성되어 frame rate를 $s_{0}$에서 $s_{k}$로 reduce 함

- 각 sub-decoder $D_{k}$는 2개의 bi-LSTM layer와 $E_{k}$에 symmetric 한 transposed convolution layer를 가짐

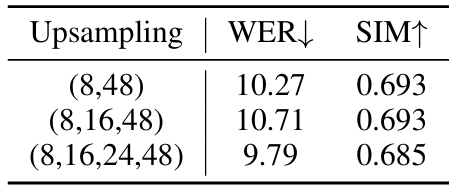

- HALL-E의 frame rate $s_{k}$, hyperparameter triplet $\alpha-\beta-\gamma$, convolution/transposed convolution layer의 stride는 아래 표와 같음

- $k=4$인 경우 pre-quantize만 사용되고 다른 component는 identical function으로 replace 되어 (Eq. 12), (Eq. 13)을 각각 $b_{4}=a_{4}, c_{4}=b_{4}$로 reduce 함

- EnCodec에 MRVQ를 적용하는 경우, frame rate는 4개의 LRVQ module을 사용하여 $s_{0}=48\text{Hz}$에서 $s_{1}=8\text{Hz}$로 reduce 됨

- Post-Training with Teacher-Student Distillation

- MRVQ module로 NAC model을 training 하는 경우 lower frame rate를 가지는 quantization layer가 ignore 될 수 있음

- 따라서 논문은 teacher-student distillation에 기반한 post-training technique을 도입함

- 이때 high frame rate로 pre-train 된 NAC model이 teacher model로 사용됨 - 먼저 teacher embedding을 frozen RVQ module에서 추출한 다음, student embedding을 MRVQ module에서 추출하고, Feature-Level Distillation (FLD) loss, Hidden-State Reconstruction (HSR) loss를 minimize 함

- FLD Loss

FLD loss는 teacher, student embedding 간의 MAE loss로 정의됨:

(Eq. 14) $\mathcal{L}_{FLD}=\sum_{(s,t)\in\mathcal{P}}\lambda_{(s,t)}^{FLD}||\hat{\mathbf{h}}_{s}-\mathbf{h}_{t}||$

(Eq. 15) $\hat{\mathbf{h}}_{s}=\sum_{k=1}^{s}\tilde{c}_{k}$

(Eq. 16) $\mathbf{h}_{t}=\sum_{l=1}^{t}\tilde{z}_{l}$

- $\mathbf{h}_{s}$ : student embedding, $\mathbf{h}_{t}$ : teacher embedding

- $\mathcal{P}$ : student-teacher index pair set, $\lambda_{(s,t)}^{FLD}$ : weight coefficient - 8-layer RVQ와 4개의 LRVQ block을 가지는 MRVQ의 경우, $\mathcal{P}=\{(1,1), (2,3),(3,5),(4,8)\}$을 사용하고 $\tilde{c}_{k},\tilde{z}_{l}$은 각각 (Eq. 8), (Eq. 1)에서 얻어짐

- $\mathcal{P}$의 student-teacher pair는 student post-quantization layer의 cumulative number가 teacher quantization layer의 cumulative number와 match 되도록 결정됨 - HSR Loss

HSR loss는 각 LRVQ block training을 facilitate 하기 위해 사용됨:

(Eq. 17) $\mathcal{L}_{HSR}=\sum_{k=1}^{K}\lambda_{k}^{HSR}||\tilde{a}_{k}-D_{k}(\tilde{b}_{k})||_{1}$

- $\tilde{a}_{k},\tilde{b}_{k}$ : 각각 (Eq. 11), (Eq. 12)로 얻어짐, $\lambda_{k}^{HSR}$ : weight coefficient - Total Loss

(Eq. 18) $\mathcal{L}_{total}=\mathcal{L}_{NAC}+\mathcal{L}_{FLD} + \mathcal{L}_{HSR}$

- $\mathcal{L}_{NAC}$ : NAC model loss

- 이때 teacher model로 사용되는 NAC model에서 copy 된 weight를 사용하여 MRVQ module로 encoder/decoder를 training 함

- FLD Loss

- 해당 post-training method는 RVQ 사용만을 가정하므로 기존 NAC model의 encode-decoder architecture와는 independent 함

- 결과적으로 SpeechTokenizer와 같은 state-of-the-art NAC model을 사용하는 경우 lower frame rate에서 더 우수한 성능을 달성할 수 있음

- 따라서 논문은 teacher-student distillation에 기반한 post-training technique을 도입함

4. Hierarchical Neural Codec Language Model

- HALL-E는 hierarchical LLM-based TTS model으로써 hierarchical token을 생성하는 방법을 학습함

- 특히 VALL-E를 기반으로 AR/NAR model의 2가지 language model을 활용함

- 먼저 AR model은 8Hz의 low frame-rate sequence를 처리하여 longer speech segment에 대한 audio token을 안정적으로 생성함

- 추가적으로 MRVQ module을 decomposing 하여 얻어진 frozen sub-module을 NAR model로 활용하여 token prediction process에 incorporate 함

- AR Model

- Text prompt $\mathbf{t}$와 audio prompt $x_{\text{pr}}$이 주어지면 AR model은 $\mathbf{t}$에 해당하는 low frame-rate token sequence $\hat{b}_{1}$을 예측함

- 즉, $\hat{b}_{1}=T_{ar}(\mathbf{t},b_{1}^{\text{pr}})$로 formulate 됨

- $T_{ar}$ : AR transformer decoder, $b_{1}^{\text{pr}}$ : first LRVQ block에서 얻어지는 audio prompt

- NAR Model

- Token sequence $\hat{b}_{k}$가 주어지면 NAR model은 next token sequence $\hat{b}_{k+1}$을 iteratively predict 함

- 이때 $\hat{b}_{k+1}$은 MRVQ module에서 얻은 frozen sub-module을 활용하여 3-step으로 예측됨:

- 먼저 sub-decoder와 post-quantizer를 $\hat{b}_{k}$에 적용하여 $\hat{c}_{k}=\text{PostQ}_{\gamma}^{(k)}(D_{k}(\hat{\tilde{b}}_{k}))$를 얻음

- 다음으로 NAR transformer decoder $T_{nar}$을 사용하여 $\hat{c}_{k}$에서 $\hat{a}_{k+1}$을 예측함

- 이때 MRVQ는 nested structure이므로 decoder를 $\alpha_{k+1}$번 적용해야 함 ($\alpha_{k+1}$ : block $k+1$에서 pre-quantizer layer 수)

- 즉, block $k+1$의 layer $l+1$에 대해 $\hat{a}_{k+1,l+1}$은 $\hat{a}_{k+1,l+1}=T_{nar}(\mathbf{t},\bar{\mathbf{h}}_{K,L}^{\text{pr}},\bar{\mathbf{h}}_{k+1,l},\ell_{k+1,l})$을 (Eq. 5)와 비슷하게 $\alpha_{k+1}$번 사용하여 계산함

- $\bar{\mathbf{h}}_{k+1,l}=\sum_{k'=1}^{k}\hat{\tilde{c}}_{k'}+\sum_{l'=1}^{l}\hat{\tilde{a}}_{k+1,l'}$ : accumulated feature, $\bar{\mathbf{h}}_{K,L}^{\text{pr}}$ : prompt의 accumulated feature

- $\ell_{k+1,l}=\sum_{k'=1}^{k}\alpha_{k}+l$ : pre-quantization layer 수에 대한 cumulative sum으로 얻어지는 layer ID - 최종적으로 $\hat{b}_{k+1}$은 $\hat{a}_{k+1}$에 sub-encoder와 main quantizer를 적용하여 $\hat{b}_{k+1}=\text{Quant}^{(k+1)}(E_{k+1}(\hat{\tilde{a}}_{k+1}))$과 같이 얻어짐

- Training

- AR model은 prediction $\hat{b}_{1}$과 training speech data에서 얻어진 ground-truth $b_{1}$ 간의 cross-entropy loss $\mathcal{L}_{CE}(\hat{b}_{1},b_{1})$로 training 됨

- 추가적으로 MusicGen의 delay pattern을 적용함 - NAR model도 마찬가지로 cross-entropy loss $\mathcal{L}_{CE}(\hat{a}_{k+1,l+1},a_{k+1,l+1})$을 통해 training 됨

- $\hat{a}_{k+1,l+1}$ : prediction, $a_{k+1,l+1}$ : ground-truth - HALL-E도 pre-trained LLM-based TTS model이 주어지는 경우 post-training 됨

- AR model은 prediction $\hat{b}_{1}$과 training speech data에서 얻어진 ground-truth $b_{1}$ 간의 cross-entropy loss $\mathcal{L}_{CE}(\hat{b}_{1},b_{1})$로 training 됨

5. Experiments

- Settings

- Dataset : MinuteSpeech

- Comparisons : VALL-E

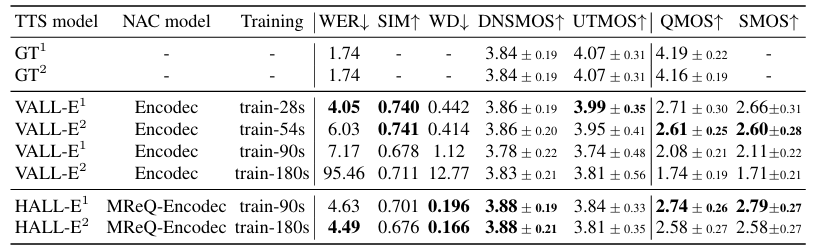

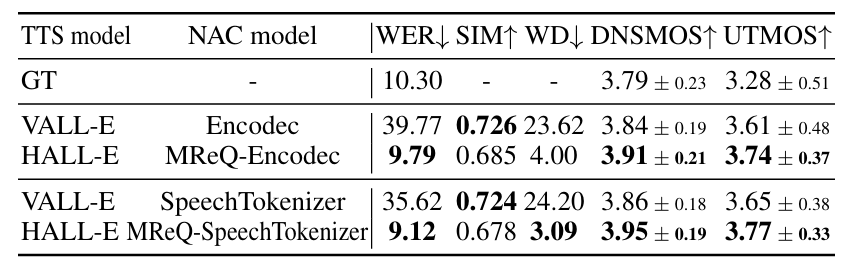

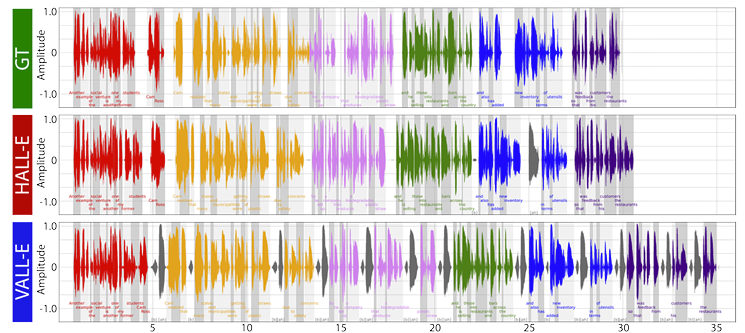

- Results

- Speech Reconstruction

- MReQ는 뛰어난 reconstruction 성능을 보임

- Zero-Shot Speech Synthesis

- MinuteSpeech dataset에 대해 HALL-E가 가장 우수한 성능을 보임

- LibriSpeech dataset에 대해서도 HALL-E의 성능이 가장 뛰어남

- SpeechTokenizer를 사용하는 경우 EnCodec에 비해 더 성능을 개선할 수 있음

- RTF 측면에서도 HALL-E는 VALL-E 보다 $\times 3.4$ 빠름

- 합성된 speech를 확인해 보면 HALL-E는 ground-truth 수준의 duration을 가짐

- Analysis

- Hierarchical manner로 frame rate를 gradually increase 하면 최상의 WER을 달성할 수 있음

- HALL-E는 audio length가 길어질수록 뛰어난 성능을 보임

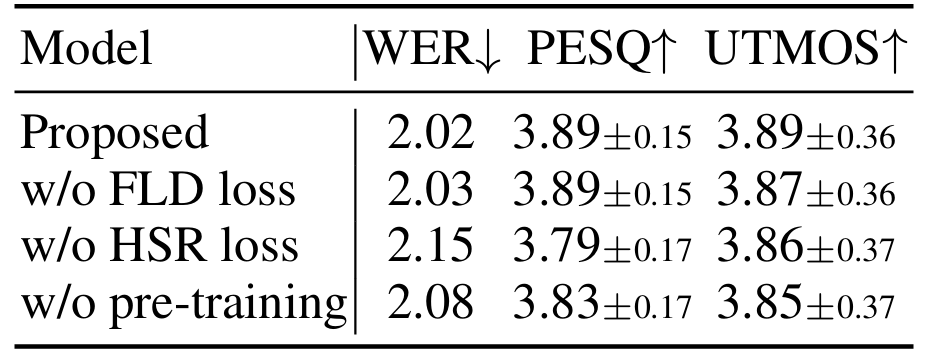

- Ablation Study

- MReQ 측면에서 각 component를 제거하는 경우 성능 저하가 발생함

- HALL-E 측면에서도 마찬가지로 각 component를 제거하는 경우 성능 저하가 발생함

반응형

'Paper > Language Model' 카테고리의 다른 글

댓글