티스토리 뷰

Paper/Language Model

[Paper 리뷰] CosyVoice: A Scalable Multilingual Zero-Shot Text-to-Speech Synthesizer based on Supervised Semantic Tokens

feVeRin 2025. 3. 16. 10:41반응형

CosyVoice: A Scalable Multilingual Zero-Shot Text-to-Speech Synthesizer based on Supervised Semantic Tokens

- Large Language Model-based Text-to-Speech에서 speech token은 unsupervised manner로 학습됨

- 즉, explict semantic information, text alignment information이 부족함 - CosyVoice

- Encoder에 vector quantization을 inserting 하여 multilingual speech recognition model에서 derive 된 supervised semantic token을 활용

- 해당 token을 기반으로 text-to-token generation을 위한 Large Language Model과 token-to-speech synthesis를 수행하는 conditional flow matching을 결합

- 논문 (Alibaba 2024) : Paper Link

1. Introduction

- VALL-E와 같은 최근의 Text-to-Speech (TTS) model은 Large Language Model (LLM)을 접목하여 zero-shot fashion으로 high quality, natural speech를 합성 가능함

- 해당 LLM-based TTS는 speech signal을 token sequence로 변환하여 사용하고 LLM은 해당 token sequence를 modeling 하는 condition으로써 text를 활용함

- 이후 HiFi-GAN과 같은 vocoder를 통해 tokenized speech로부터 raw waveform을 reconstruct함 - BUT, 일반적으로 token은 unsupervised manner로 얻어지므로 explicit semantic information을 capture 하지 못하거나 text와 align 되기 어려움

- 해당 LLM-based TTS는 speech signal을 token sequence로 변환하여 사용하고 LLM은 해당 token sequence를 modeling 하는 condition으로써 text를 활용함

-> 그래서 supervised semantic token을 활용한 LLM-based TTS model인 CosyVoice를 제안

- CosyVoice

- Vector Quantization을 encoder에 incorporate 하여 multilingual speech recognition model인 Whisper에서 추출한 supervised semantic token을 TTS에 활용

- 이를 통해 accurate semantic representation과 text alignment를 얻음 - Text를 semantic token sequence로 변환하는 LLM과 해당 token으로부터 speech를 합성하는 Conditional Flow Matching model을 채택

- Vector Quantization을 encoder에 incorporate 하여 multilingual speech recognition model인 Whisper에서 추출한 supervised semantic token을 TTS에 활용

< Overall of CosyVoice >

- Supervised token을 기반으로 LLM, Conditional Flow Matching을 결합한 scalable, efficient zero-shot synthesizer

- 결과적으로 기존보다 뛰어난 합성 성능을 달성

2. Method

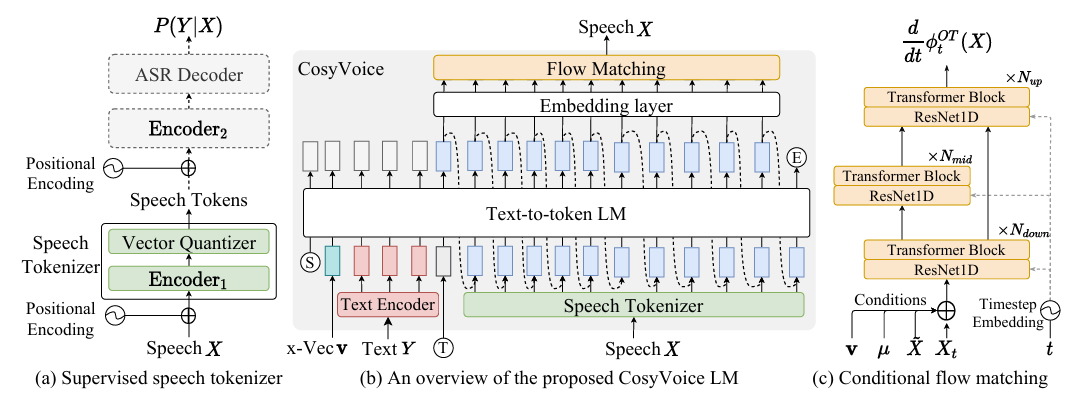

- CosyVoice는 text encoder, speech tokenizer, large language model, conditional flow matching model로 구성됨

- CosyVoice는 크게 4가지 component를 가짐

- Text encoder는 text, speech token의 semantic space를 align 하는 데 사용됨

- Speech tokenizer는 semantic token을 추출하는 데 사용됨

- Large Language Model은 text encoding, speech token의 whole sequence를 학습하는 데 사용되고, TTS task를 prompt로 주어진 text를 사용하여 auto-regressive sequence generation으로 reformulate 함

- Conditional flow matching model은 optimal path에서 denoising process를 통해 speech token을 mel-spectrogram으로 변환함

- 최종적으로 perceptible signal을 얻기 위해 HiFi-GAN vocoder를 사용하여 generated mel-spectrogram을 waveform으로 변환함

- CosyVoice는 크게 4가지 component를 가짐

- Supervised Semantic Tokens for Speech

- CosyVoice는 Automatic Speech Recognition (ASR) model을 사용하여 speech에 대한 supervised semantic speech $\mathcal{S}^{3}$ tokenizer를 derive 함

- 이를 위해 multilingual audio data에서 학습된 SenseVoice ASR model을 fine-tuning 하여 사용함

- 이때 기존 ASR model과 달리 encoder를 2-part로 split 하고 그 사이에 vector quantization layer를 insert 함

- 먼저 Input으로 mel-spectrogram $X$가 주어지면 positional encoding과 $\text{Encoder}_{1}$을 통해 context-aware representation $H$를 얻음:

(Eq. 1) $H=\text{Encoder}_{1}(\text{PosEnc}(X))$ - 이후 vector quantizer (VQ)를 통해 discrete token을 얻고, frame $l$의 hidden representation $\mathbf{h}_{l}$에 대해 codebook $C$의 nearest embedding index는 speech token $\mu_{l}$로 처리됨:

(Eq. 2) $\mu_{l}=\text{VQ}(\mathbf{h}_{l},C)=\arg\min_{\mathbf{c}_{n}\in C}||\mathbf{h}_{l}-\mathbf{c}_{n}||_{2}$

- $||\cdot||_{2}$ : $\text{L2}$ norm - Training stage에서 codebook embedding은 Exponential Moving Average (EMA)를 통해 update 됨:

(Eq. 3) $\mathbf{c}_{\mu_{l}}:=\alpha\mathbf{c}_{\mu_{l}}+(1-\alpha)\mathbf{h}_{l}$

- $\alpha$ : pre-defined decay coefficient - Speech token의 codebook embedding은 quantized hidden representation $\bar{H}=\{\mathbf{c}_{\mu_{1}},\mathbf{c}_{\mu_{2}},...,\mathbf{c}_{\mu_{L}}\}$으로 사용된 다음, encoder layer $\text{Encoder}_{2}$를 통과함:

(Eq. 4) $\tilde{H}=\text{Encoder}_{2}(\text{PosEnc}(\bar{H}))$

- 이때 temporal information을 enhance 하기 위해 extra positional encoding을 추가함 - $\text{Encoder}_{2}$ 이후 transformer-based ASR decoder를 통해 text label의 posterior probability를 예측함:

(Eq. 5) $P(Y|X)=\text{ASRDecoder}(\tilde{H},Y^{Z-1})$

- $Y^{Z-1}$ : teacher-forcing training scheme의 left-shifted text label

- 먼저 Input으로 mel-spectrogram $X$가 주어지면 positional encoding과 $\text{Encoder}_{1}$을 통해 context-aware representation $H$를 얻음:

- Large Language Model for TTS

- CosyVoice는 TTS task를 Large Language Model (LLM)을 사용한 autoregressive speech token generation으로 formulate 함

- 이때 LLM sequence construction은 다음과 같음:

(Eq. 6) $\left[Ⓢ, \mathbf{v},\{\bar{\mathbf{y}}_{u}\}_{u\in[1:U]},Ⓣ,\{\mu_{l}\}_{l\in[1:L]}, Ⓔ\right]$

- Ⓢ, Ⓔ : start/end of the sequence

- $\mathbf{v}$ : pre-trained voice-print model을 사용하여 speech $X$에서 추출된 speaker embedding vector - Text embedding $\bar{Y}=\{\bar{\mathbf{y}}_{u}\}_{u\in[1:U]}$는 text를 Byte Pair Encoded (BPE) tokenizer와 text encoder에 전달하여 얻어짐:

(Eq. 7) $\bar{Y}=\text{TextEncoder}(\text{BPE}(Y))$

- Text, speech token은 서로 다른 semantic level에 있으므로 text encoder를 사용하여 semantic space를 align 한 다음 LLM modeling을 수행함 - Start identifier Ⓣ는 text encoding, speech token $\{\mu_{l}\}_{l\in[1:L]}$ 사이에 insert 되고 supervised semantic tokenizer를 통해 추출됨

- Training stage에서 논문은 teacher forcing scheme을 활용함

- 여기서 left-shifted sequence를 mode input으로, original sequence를 expected output으로 사용함

- Training 중에는 speech token과 Ⓔ의 cross-entropy loss만 고려함:

(Eq. 8) $\mathcal{L}_{LM}=-\frac{1}{L+1}\sum_{l=1}^{L+1}\log q(\mu_{l})$

- $\mu_{L+1}$ : 'end of sequence' token Ⓔ

- $q(\mu_{l})$ : $\mu_{l}$의 posterior probability

- 이때 LLM sequence construction은 다음과 같음:

- Optimal-Transport Conditional Flow Matching

- CosyVoice는 Optimal-Transport Conditional Flow Matching (OT-CFM) model을 사용하여 mel-spectrogram distribution을 학습하고 generated speech token을 condition으로 하여 sample을 생성함

- OT-CFM은 Diffusion Probabilistic Model (DPM)에 비해 simpler gradient, easier training, faster generation을 제공할 수 있음

- 먼저 Continuous-time Normalizing Flow (CNF)에서 probability density path는 prior distribution $p_{0}(X)$에서 mel-spectrogram $q(X)$로의 data distribution으로 구성됨

- 여기서 probability density path는 time-dependent vector field $\nu_{t}(X):[0,1]\times\mathbb{R}^{L*D}\rightarrow \mathbb{R}^{L*D}$로 정의되고, $t\in[0,1]$에서 다음의 Ordinary Differential Equation (ODE)를 통해 flow $\phi_{t}$를 생성함:

(Eq. 9) $\frac{\text{d}}{\text{d}t}\phi_{t}(X)=\nu_{t}(\phi_{t}(X),t),\,\,\,\phi_{0}(X)\sim p_{0}(X)=\mathcal{N}(X;0,I),\,\,\,\phi_{1}(X)=p_{1}(X)$

- (Eq. 9)의 initial value problem을 solve 하면 speech distribution $q(X)$를 $p_{1}(X)$로 approximate 하고 sampling 할 수 있음 - Vector $\nu_{t}(X)$를 학습하기 위해 Optimal Transport (OT)를 정의하고, neural network에 다음 loss를 minimize 하여 match 함:

(Eq. 10) $\mathcal{L}_{OT\text{-}CFM}=\mathbb{E}_{t,p_{0}(X_{0}),q(X_{1})}\left|\omega_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|X_{1}\right)-\nu_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|\theta\right)\right|$

(Eq. 11) $\text{where}\,\,\, \phi_{t}^{OT}(X_{0},X_{1})=(1-(1-\sigma)t)X_{0}+tX_{1},$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\, \omega_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|X_{1}\right)=X_{1}-(1-\sigma)X_{0}$ - Speaker embedding $\mathbf{v}$, speech token $\{\mu_{l}\}_{1:L}$, masked mel-spectrogram $\tilde{X}_{1}$은 vector field를 learnable parameter $\theta$와 match 하기 위해 neural network에 feed 됨:

(Eq. 12) $\nu_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|\theta\right)=\text{NN}_{\theta}\left(\phi_{t}^{OT}(X_{0},X_{1}),t,\mathbf{v},\{\mu_{l}\}_{1:L},\tilde{X}_{1}\right)$

- $\tilde{X}_{1}$ : random start point에서 end까지 continuous frame을 0으로 설정하여 $X_{1}$을 mask 함 - 논문은 timestep $t$에 대해 cosine scheduler를 적용함:

(Eq. 13) $t:=1-\cos\left(\frac{1}{2}t\pi\right)$

- 여기서 probability density path는 time-dependent vector field $\nu_{t}(X):[0,1]\times\mathbb{R}^{L*D}\rightarrow \mathbb{R}^{L*D}$로 정의되고, $t\in[0,1]$에서 다음의 Ordinary Differential Equation (ODE)를 통해 flow $\phi_{t}$를 생성함:

- Classifier-Free Guidance (CFG)를 활용하면 diffusion model의 generation quality를 향상할 수 있음

- 따라서 논문은 CFG를 conditional flow matching model에 적용함

- 먼저 training stage에서 condition $\Psi=\{\mathbf{v},\{\mu_{l}\}_{1:L},\tilde{X}_{1}\}$을 fixed probability $0.2$로 drop 하면 conditional/unconditional flow를 모두 학습할 수 있음

- 그러면 generation 중에 vector field는 다음과 같이 modify 됨:

(Eq. 14) $\tilde{\nu}_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|\theta;\Psi\right)=(1+\beta)\cdot \nu_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|\theta;\Psi\right)-\beta\cdot \nu_{t}\left(\phi_{t}^{OT}(X_{0},X_{1})|\theta\right)$

- $\beta=0.7$ : guidance strength

- Zero-Shot In-Context Learning

- CosyVoice는 zero-shot in-context learning을 통해 brief reference speech sample 만으로도 arbitrary voice를 replicate 할 수 있음

- 해당 process를 수행하기 위해서는 아래 그림과 같이 token Language Model (LM)에 대한 input sequence를 construct 해야 함

- Same language의 prompt speech, input text의 경우 prompt speech token을 pre-generated로 취급하여 unified input을 형성하도록 merge 함

- 해당 input sequence를 사용하여 autoregressive LM은 'end of sequence' token Ⓔ를 만날 때까지 iteratively predict 함 - Prompt speech, input text가 linguistically differ 한 경우, original language의 prosodic characteristic이 target language에 influence 하지 않도록 prompt와 관련된 text, token을 omit 함

- Same language의 prompt speech, input text의 경우 prompt speech token을 pre-generated로 취급하여 unified input을 형성하도록 merge 함

- Prompt speech content에 해당하는 prompt text는 human annotation이나 ASR model을 통해 transcribe 될 수 있음

- Prompt token은 $\mathcal {S}^{3}$ tokenizer를 사용하여 prompt speech에서 추출됨

- 해당 process를 수행하기 위해서는 아래 그림과 같이 token Language Model (LM)에 대한 input sequence를 construct 해야 함

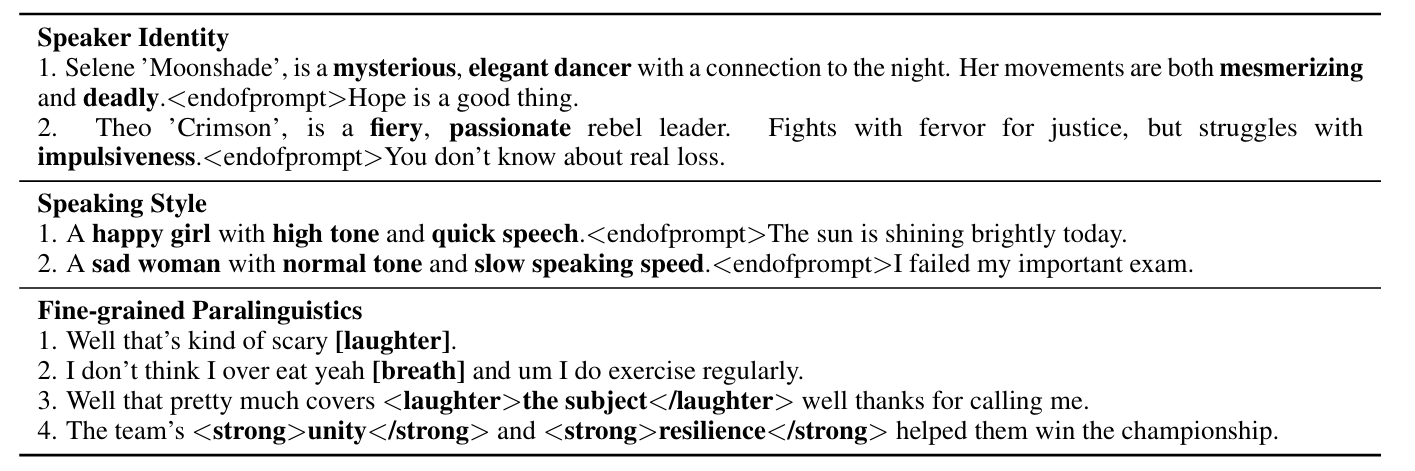

- Rich Generation with Insturction

- Further controllability를 제공하기 위해 additional instruction fine-tuning을 integrate 하여 CosyVoice-base를 CosyVoice-instruct로 확장함

- CosyVoice-instruct는 speaker identity, speaking style (emotion, gender, speaking rate, pitch 등), fine-grained paralinguistic feature에 대한 control을 지원함

- 이때 논문은 autoregressive language model에 speaker embedding을 incorporating 하지 않고 아래와 같은 training data를 사용하여 CosyVoice-base를 fine-tuning 하여 사용함

3. Experiments

- Settings

- Results

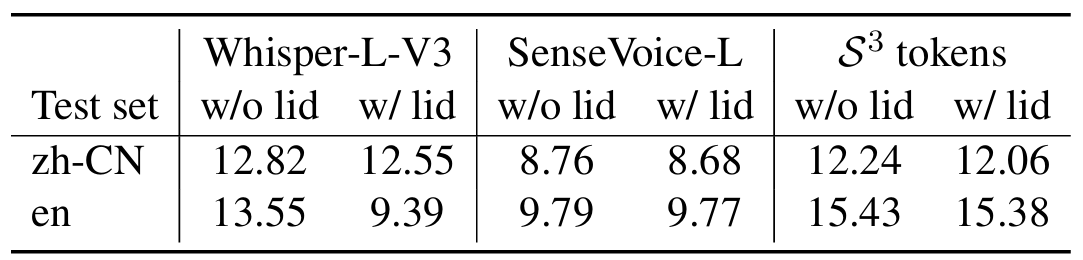

- Evaluation on $\mathcal{S}^{3}$ Tokenizer

- VQ-inserted Conformer는 3.18 WER을 달성함

- 즉, supervised manner로 training 된 tokenizer는 sufficient semantic information과 text alignment를 유지할 수 있음

- $\mathcal{S}^{3}$ token은 Whisper-Large-V3 보다 더 뛰어난 성능을 달성함

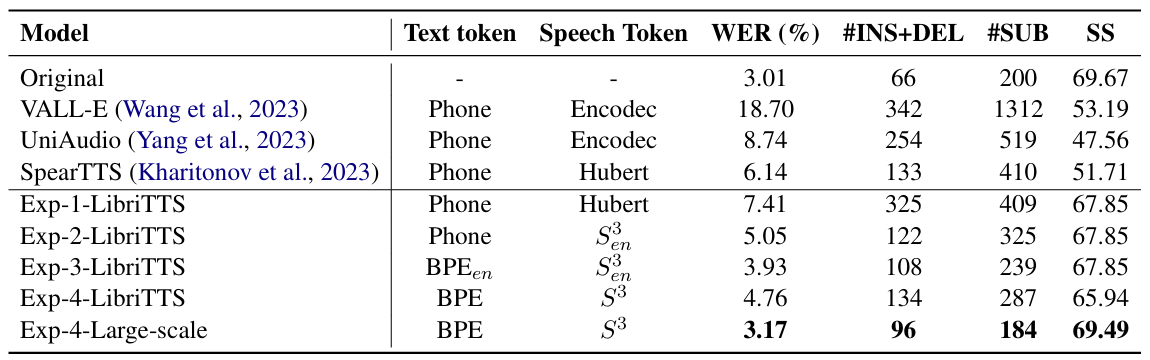

- Comparison with Baselines

- 전체적으로 CosyVoice가 가장 뛰어난 성능을 보임

- Speaker Similarity (SS) 측면에서도 CosyVoice가 가장 우수함

- Emotion Controllability of CosyVoice

- CosyVoice는 speaking style instruction을 통해 emotion control이 가능함

- CosyVoice as a Data Generator

- ASR, Speech-to-Speech Translation과 같은 task에 CosyVoice를 data generator로 사용할 수도 있음

반응형

'Paper > Language Model' 카테고리의 다른 글

댓글