티스토리 뷰

Paper/Conversion

[Paper 리뷰] ZSVC: Zero-Shot Style Voice Conversion with Disentangled Latent Diffusion Models and Adversarial Training

feVeRin 2025. 3. 28. 15:15반응형

ZSVC: Zero-Shot Style Voice Conversion with Disentangled Latent Diffusion Models and Adversarial Training

- Style voice conversion은 original speaker identity를 유지하면서 source speech의 speaking style을 desired style로 변환하는 것을 목표로 함

- ZSVC

- Speech codec과 speech prompting mechanism을 포함한 latent diffusion model을 활용

- Speaking style, timbre를 disentangle 하기 위해 information bottleneck을 도입하고 Uncetainty Modeling Adaptive Instance Normalization을 통해 style prompt에서 speaker timbre를 perturb 함

- 논문 (ICASSP 2025) : Paper Link

1. Introduction

- Zero-shot Voice Conversion (VC)는 linguistic content를 변경하지 않으면서 source speaker를 target speaker로 변환하는 것을 목표로 함

- 기존에는 AutoVC와 같이 source speaker의 linguistic content와 target speaker timbre를 merge 하여 converted speech를 생성함

- 특히 zero-shot style VC에서는 Variational AutoEncoder (VAE)나 CycleGAN, StarGAN과 같은 Generative Adversarial Network (GAN) 방식이 주로 활용됨

- BUT, human speech에는 intonation, rhythm과 같은 emotional-independent nuance와 다양한 style expression이 존재함 - 특히 기존 zero-shot style VC system에는 다음의 한계점이 존재함:

- 모든 human speech를 categorize/annotate 하는 것은 어려우므로 style annotation을 사용하기 어려움

- Speaker timbre, linguistic content, speaking style 간의 intricate entanglement로 인해 style/timbre leakage가 발생할 수 있음

- 대부분 speaker verficiation network에서 얻어지는 global embedding에 의존하므로 zero-shot VC 성능도 제한됨

-> 그래서 target speaker의 speaking style을 효과적으로 반영할 수 있는 zero-shot style VC model인 ZSVC를 제안

- ZSVC

- Speech codec을 사용하여 input speech로부터 speech token을 추출한 다음, latent diffusion model을 통해 speech token의 speaking style을 modulate

- 이후 speech prompting mechanism과 couple 하여 in-context learning을 지원함 - Information bottleneck을 적용하여 speech token 내의 speaking style을 isolate하고, prompted speech에서 speaker timbre를 distrub하는 Uncertainty Modeling Adaptive Instance Normalization (UMAdaIN)을 도입

- 이를 통해 다양한 speech component 간의 entanglement 문제를 해결함 - 추가적으로 in-context learning과 zero-shot style similarity를 개선하기 위해 adversarial training을 채택

- Speech codec을 사용하여 input speech로부터 speech token을 추출한 다음, latent diffusion model을 통해 speech token의 speaking style을 modulate

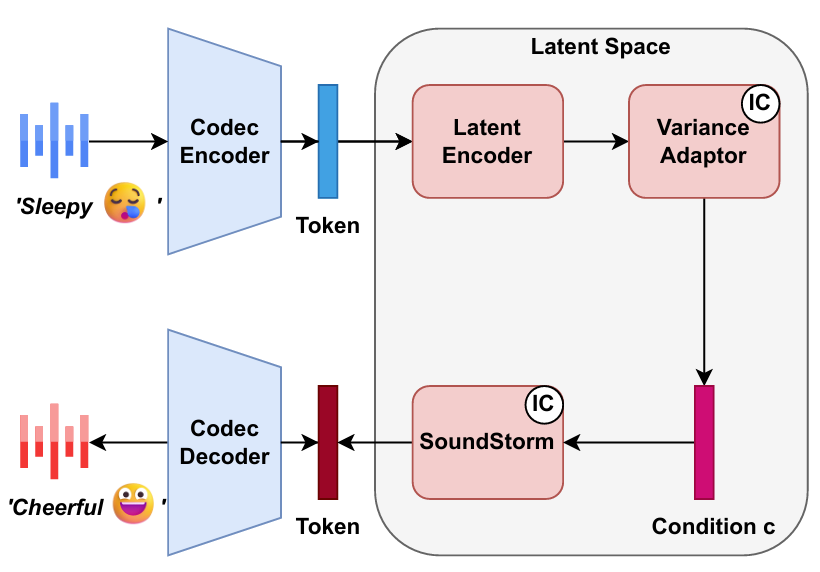

< Overall of ZSVC >

- Speech codec과 latent diffusion model을 활용한 zero-shot style VC model

- 결과적으로 zero-shot scenario에서 기존보다 우수한 speaking style similarity를 달성

2. Method

- ZSVC는 speech codec과 latent diffusion model을 기반으로 함

- 먼저 speech codec encoder는 input speech에서 speech token을 추출하고 speech codec decoder는 speech token으로부터 speech waveform을 reconstruct 함

- Latent diffusion model은 latent encoder, variance adaptor, SoundStorm decoder로 구성되어 speech token의 speaking style을 jointly modulate 함

- 이때 speech prompting mechanism은 prompt encoder를 통해 variance adaptor와 SoundStorm decoder에 integrate 되어 in-context learning을 통해 speaking style을 control 함

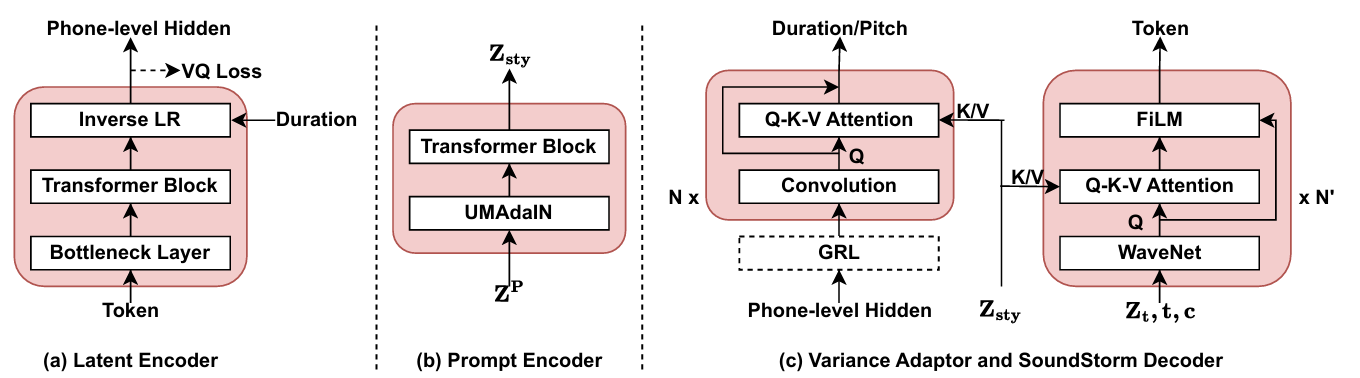

- Disentangled Latent Encoder and Prompt Encoder

- Speech token은 linguistic content, speaker timbre, speaking style을 모두 encapsulate 하여 high-quality reconstruction을 지원함

- 따라서 potential leakage를 방지하기 위해서는 speech token에서 speaking style과 speaker timbre를 효과적으로 disentangle 해야 함

- 이를 위해 latent encoder는 bottleneck layer, transformer block, inverse Length Regulator (LR)로 구성됨

- 먼저 input speech token은 speech codec codebook을 traverse하여 token embedding으로 얻어짐

- 이후 해당 embedding은 bottleneck layer를 통해 low-dimensional space (64-dimension)로 project 되어 unnecessary information을 eliminate 함

- 최종적으로 low-dimensional embedding은 transformer block과 phone-level duration을 가지는 inverse LR을 통과하여 phone-level hidden sequence $H$로 project 됨

- 이때 additional information bottleneck인 vector quantization (VQ) commit loss를 $H$에 적용하여 linguistic cluster를 구성함

- VQ는 서로 다른 speaking style의 hidden sequence $H$를 same linguistic cluster에 mapping 하여 $H$ 내에서 speaking style을 further filtering 함

- 한편으로 Instance Normalization (IN)을 통해 대부분의 speaker timbre를 eliminate 할 수 있으므로, 논문은 StyleSinger의 Uncertainty Modeling Layer Normalization (UMLN)에 기반한 UMAdaIN을 도입함

- UMAdaIN은 prompt encoder에서 speaker timbre를 perturb 하고 disentangle 하는 역할을 수행함 - 먼저 prompt speech token은 codebook에 전달되어 prompt embedding $Z^{P}$를 생성함

- 여기서 $Z^{P}$의 mean $\mu$, variance $\sigma$를 계산한 다음, $\mu,\sigma$를 averaging 하여 scale $\bar{\mu}$, bias $\bar{\sigma}$ vector를 얻음

- 이때 speaker information을 perturb 하기 위해 논문은 Gaussian distribution을 사용하여 speaker embedding의 uncertainty scope를 modeling 함

- 즉, standard Gaussian distribution에서 $\omega_{1},\omega_{2}$를 sampling 함 - 결과적으로 얻어지는 speaker-agnostic hidden representation은:

(Eq. 1) $\text{UMAdaIN}(x)=\omega_{1}\odot \bar{\mu}\odot \frac{x-\mu}{\sigma}+\omega_{2}\odot \bar{\sigma}$

- 해당 speaker-agnostic hidden representation은 transformer block으로 전달되어 style representation $Z_{sty}$를 생성함

- SoundStorm-based Latent Diffusion

- Phone-level hidden sequence $H$, style representation $Z_{sty}$가 주어지면 variance adaptor는 duration, pitch를 predict 함

- 이후 hidden sequence $H$는 duration을 기준으로 frame-level expand 되고 pitch embedding과 combine 되어 final condition information $c$를 구성함

- 결과적으로 condition $c$는 SoundStorm decoder로 전달되어 speech token을 predict 하는데 사용됨

- 즉, condition $c$와 $Z_{sty}$가 주어졌을 때 speech token $Z_{0:T}$를 predict 하는 process는:

(Eq. 2) $p(Z_{0:T}|c,Z_{sty};\theta_{s})=\prod_{t=0}^{T}p(Z_{t}|Z_{<t},c,Z_{sty};\theta_{s})$

- $\theta_{s}$ : SoundStorm decoder parameter, $T$ : speech codec의 quantizer 수 - 여기서 논문은 masking function $m(i)$를 사용하여 각 time step $i$에서 $Z_{t}$의 subset을 mask, predict 하기 위해 (Eq. 2)를 다음과 같이 expand 함:

(Eq. 3) $p(Z_{0:T}|c,Z_{sty};\theta_{s})=\prod_{t=0}^{T}\prod_{i=0}^{n}p\left(m(i)\odot Z_{t}| (1-m(i))\odot Z_{t},Z_{<t},c,Z_{sty};\theta_{s}\right)$

- $n$ : total decoding step

- 이때 VALL-E와 같이 Q-K-V attention을 통해 speech prompt $Z_{sty}$를 incorporate 함

- 즉, condition $c$와 $Z_{sty}$가 주어졌을 때 speech token $Z_{0:T}$를 predict 하는 process는:

- Enhancing In-Context Learning with Adversarial Training

- 논문은 speaking style converting에서 in-context learning을 향상하기 위해 variance adaptor 내에 adversarial training을 incorporate 함

- 먼저 hidden sequence $H$와 $Z_{sty}$가 주어지면 variance adaptor는 다음과 같이 duration $D$, pitch $P$를 predict 함:

(Eq. 4) $\mathcal{L}_{va}=p(D,P|H,Z_{sty};\theta_{va})$

- $\theta_{va}$ : variance adaptor parameter - Adversarial training 시에는 variance adaptor에서 $Z_{sty}$와 Q-K-V attention을 제거하고 $H$에 Gradient Reversal Layer (GRL)을 도입함:

(Eq. 5) $\mathcal{L}_{va'}=p(D,P|\text{GRL}(H);\theta_{va'})$

- $\theta_{va'}$ : GRL을 적용한 modified variance adaptor parameter - 해당 adversarial training을 통해 $H$의 residual speaking style을 remove 하고 $Z_{sty}$에 focus 하여 speaking style을 효과적으로 capture 하도록 함

- 먼저 hidden sequence $H$와 $Z_{sty}$가 주어지면 variance adaptor는 다음과 같이 duration $D$, pitch $P$를 predict 함:

- Training and Inference

- NaturalSpeech2를 따라 target speech의 random segment를 prompt speech로 사용하고 나머지 segment는 input speech로 사용함

- 그러면 ZSVC의 training objective는:

(Eq. 6) $\mathcal{L}=\mathcal{L}_{diff}+\mathcal{L}_{VQ}+\mathcal{L}_{va}+\lambda_{grl}\mathcal{L}_{va'}$

- $\mathcal{L}_{diff}$ : predicted/ground-truth token 간의 Cross-Entropy loss

- $\mathcal{L}_{VQ}$ : $H$에 대한 VQ commit loss

- $\mathcal{L}_{va},\mathcal{L}_{va'}$ : predicted/ground-truth pitch/duration 간의 $L1$ loss

- $\lambda_{grl}=0.5$ : adversarial training weight - 추론 시에는 source speech, prompt speech가 주어지면, source speech의 linguistic content와 speaker timbre를 preserve 하면서 prompt speech의 speaking style을 incorporate 함

- 그러면 ZSVC의 training objective는:

3. Experiments

- Settings

- Dataset : MLS

- Comparisons : LGVC, StyleVC

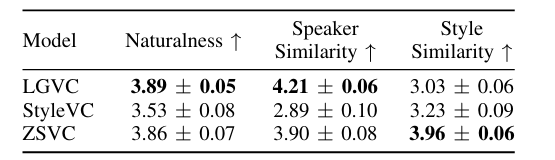

- Results

- ZSVC는 style similarity 측면에서 우수한 성능을 보임

- Objective evaluation 측면에서도 우수한 성능을 보임

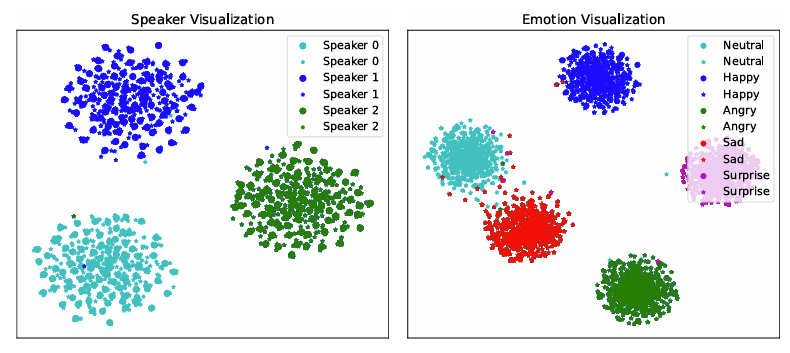

- Visual Analysis

- $t$-SNE 측면에서 ZSVC는 speaker timbre를 효과적으로 maintain 함

- Ablation Study

- ZSVC의 각 component를 제거하는 경우 성능 저하가 발생함

반응형

'Paper > Conversion' 카테고리의 다른 글

댓글