티스토리 뷰

Paper/Conversion

[Paper 리뷰] ALO-VC: Any-to-Any Low-Latency One-Shot Voice Conversion

feVeRin 2024. 8. 12. 10:17반응형

ALO-VC: Any-to-Any Low-Latency One-Shot Voice Conversion

- Non-parallel low-latency one-shot phonetic posteriorgrams-based voice conversion을 통해 빠른 합성이 가능함

- ALO-VC

- Pre-trained speaker encoder, pitch predictor, positional encoding을 결합해 구성됨

- ALO-VC-R은 pre-trained d-vector speaker encoder를 활용하고 ALO-VC-E는 ECAPA-TDNN을 활용해 성능을 개선

- 논문 (INTERSPEECH 2023) : Paper Link

1. Introduction

- Voice Conversion (VC)는 linguistic content를 유지하면서 source speaker의 utterance를 target speaker의 voice로 변환하는 것을 목표로 함

- 특히 any-to-any one-shot VC system은 하나의 reference utterance 만을 사용하여 any target speaker에 대한 conversion을 수행할 수 있어야 함

- BUT, 이러한 기존의 non-causal VC system은 많은 parameter를 요구하고 상당한 future frame look-ahead를 사용하므로 real-time application에서 latency 요구사항을 초과함

- 이를 위해 FastVC, Streamable VQMIVC 등을 고려할 수 있지만, 합성 품질 측면에서 한계가 있음 - 한편으로 Phonetic Posteriorgram (PPG) representation을 활용하면 고품질 causal system을 구축할 수 있음

-> 그래서 PPG representation을 기반으로 한 low-latency one-shot VC system인 ALO-VC를 제안

- ALO-VC

- Pitch predictor와 Causal positional encoding을 통합하여 PPG에 phoneme location information을 제공

- 47.5ms의 look-ahead를 사용하여 low-latency one-shot VC를 수행하는 2가지 variant를 구축:

- ALO-VC-R은 pre-trained d-vector speaker encoder를 활용

- ALO-VC-E는 ECAPA-TDNN speaker encoder를 활용해 성능을 개선

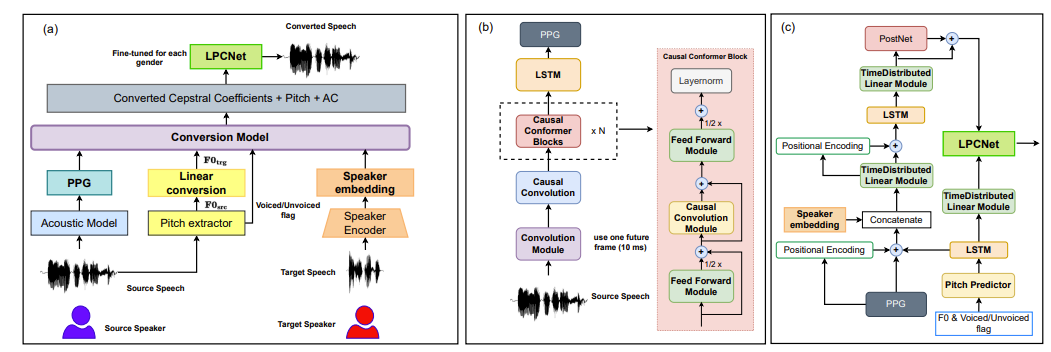

< Overall of ALO-VC >

- PPG를 causal content representation으로 채택하고 pitch predictor를 통해 pitch variance information을 반영

- 추가적으로 pre-trained speaker encoder를 활용하여 similarity를 개선

- 결과적으로 기존보다 뛰어난 합성 품질과 latency를 달성

2. Method

- ALO-VC는 acoustic model, pitch extractor, speaker encoder, conversion model, LPCNet의 5가지 component로 구성됨

- Acoustic Model

- Acoustic model은 source utterance의 speaker independent linguistic content representation을 추출하는 것을 목표로 함

- 이를 위해 논문에서는 Phonetic Posteriorgram (PPG)를 사용하고, 구조적으로는 Conformer architecture에 기반한 architecture를 활용

- 이때 multi-head attention은 latency를 증가시키므로 사용되지 않음 - 전체적으로 ALO-VC의 acoustic model은 convolution module, causal convolution module, causal conformer block, uni-directional LSTM layer로 구성됨

- $3\times 3$ kernel을 가지는 single 1D convolution layer로 구성된 convolution module은 adjacent frame 간의 local correlation을 detect 하는 역할을 수행

- 해당 module 다음에는 ReLU activation이 포함된 causal convolution layer, 4개의 causal Conformer block, 2개의 uni-directional LSTM, softmax activation이 포함된 time-distributed fully-connected layer가 이어짐

- Causal conformer block에서는 causality를 보장하기 위해 각 time frame에 대해 independent하게 layer normalization을 적용함

- 최종적으로 512-dimensional PPG representation은 LSTM layer를 통해 추출됨

- Acoustic model은 2.7M의 parameter를 가지고 10ms future look-ahead frame을 사용함

- Training 시 ground-truth phoneme alignment와 acoustic model output 간의 cross-entropy로 최적화됨

- 이때 PPG representation에서 source speaker identity가 expose되는 것을 방지하기 위해 conversion model과는 개별적으로 training 됨

- 이를 위해 논문에서는 Phonetic Posteriorgram (PPG)를 사용하고, 구조적으로는 Conformer architecture에 기반한 architecture를 활용

- Speaker Encoder

- Speaker embedding을 얻기 위해, Resemblyzer의 pre-trained d-vector와 SpeechBrain의 pre-trained ECAPA-TDNN을 활용

- d-vector speaker encoder는 VoxCeleb2로 train 되어 1.4M의 parameter를 가지고, ECAPA-TDNN은 VoxCeleb1, VoxCeleb2로 train되어 14.7M의 parameter를 가짐

- 해당 pre-trained model을 통해 target speaker identity와 content representation을 separate 할 수 있음

- 특히 speaker encoder는 acoustic/conversion model과 independent 하게 training 되므로 content information leakage를 방지 가능 - 결과적으로 해당 speaker encoder를 기반으로 ALO-VC에 대한 2가지 variant를 구축할 수 있음:

- ALO-VC-R : d-vector speaker encoder를 사용

- ALO-VC-E : ECAPA-TDNN speaker encoder를 사용

- Conversion Model

- Conversion model에서는 LPCNet을 통해 converted speech를 합성할 수 있도록 converted 18-dimensional Bark-scale cepstral coefficient (BFCC)와 converted pitch, voiced/unvoiced flag (VUF)를 생성함

- 구조적으로는 pitch predictor, positional encoding module, time-distributed fully-connected layer, uni-directional LSTM layer로 구성됨

- Pitch predictor는 4개의 1D causal convolution layer, 1개의 uni-directional LSTM으로 구성되고, converted pitch $F0_{trg}$와 VUF를 input으로 사용

- 여기서 LPCNet의 bulit-in pitch detector를 source speech에서 $F0$와 VUF를 추출하는데 사용함 - $F0_{trg}$는 target speech의 log-scaled $F0$ statistics로 계산됨:

(Eq. 1) $\log F0_{trg}=(\log F0_{src}-\mu_{src})*\left(\frac{\sigma_{trg}}{\sigma_{src}}\right)+ \mu_{trg}$

- $\mu_{src}, \mu_{trg}$ : 각각 source speaker, target speaker의 $\log F0$ 평균

- $\sigma_{src}, \sigma_{trg}$ : 각각 source speaker, target speaker의 $\log F0$ 분산

- 해당 pitch conversion 이후, $\log F0_{trg}$는 $F0_{trg}$로 다시 변환됨 - 최종적으로 time-distributed fully-connected layer는 $F0_{trg}$와 VUF representation을 2D로 project 하고, pitch predictor는 VUF와 target speech prosody를 예측에 활용함

- 이때 VUF와 pitch variance information은 PPG에 추가됨

- Pitch predictor는 4개의 1D causal convolution layer, 1개의 uni-directional LSTM으로 구성되고, converted pitch $F0_{trg}$와 VUF를 input으로 사용

- Positional encoding은 PPG에서 phoneme location을 제공하기 위해 사용됨

- 이때 streaming inference를 위한 positional encoding은:

(Eq. 2) $P(L+1,2i)=\sin\left(\frac{L+1}{10000^{2i/d}}\right), \,\,\, P(L+1,2i+1)=\cos\left(\frac{L+1}{10000^{2i/d}}\right)$

- $L$ : previous input representation length, $d$ : output embedding space dimension

- $i$ : output embedding space에서 dimension에 대한 position function을 mapping 하는 index ($0\leq i <d/2$) - Streaming inference에서 $L$을 positional encoding으로 사용하면 future information이 사용되는 것을 방지 가능

- 이때 streaming inference를 위한 positional encoding은:

- 이후 output representation을 post-process 하기 위해 Tanh activation과 3개의 1D causal convolution layer로 구성된 PostNet을 도입함

- 결과적으로 conversion model은 5.6M parameter를 가짐 - Training 과정에서 conversion model은 ground-truth BSCC와 PostNet output representation 간의 Mean Absolute Error (MAE)를 통해 최적화됨

- 이때 ground-truth pitch, predicted pitch 간의 MAE와 ground-truth VUF, predicted VUF 간의 MAE를 추가

- 구조적으로는 pitch predictor, positional encoding module, time-distributed fully-connected layer, uni-directional LSTM layer로 구성됨

- Fine-tuned LPCNet for each Gender

- VC system의 성능을 더욱 향상하기 위해, 논문은 VCTK dataset의 male/female speaker에 대해 각각 fine-tuning 된 average LPCNet을 활용함

- 이때 하나의 gender에 대해 0.0001의 learning rate로 base LPCNet을 training 함

3. Experiments

- Settings

- Results

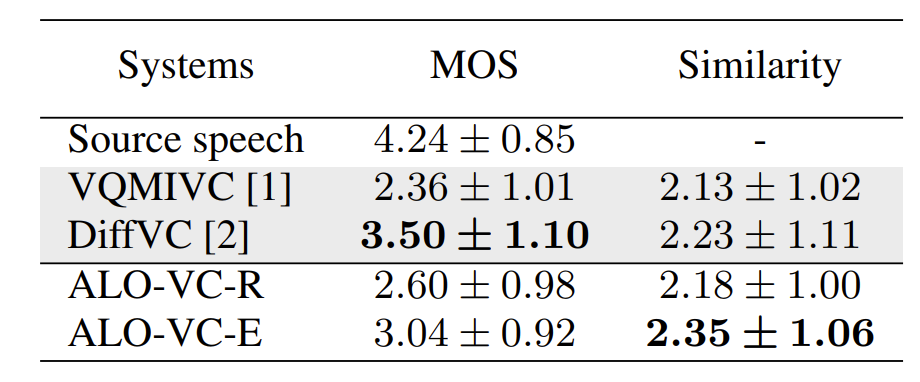

- Subjective Test

- Similarity 측면에서 ALO-VC는 가장 뛰어난 성능을 보임

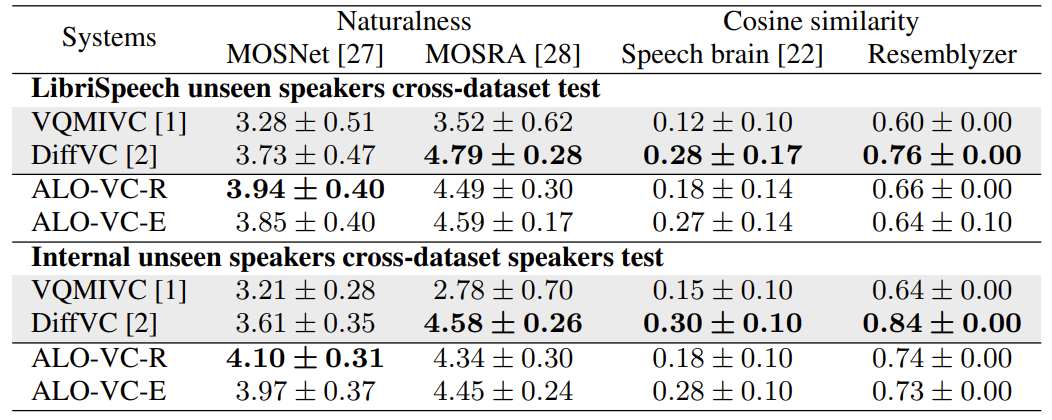

- Objective Test

- Objective test에서도 ALO-VC가 가장 우수한 naturalness와 similarity를 달성함

- Real-Time Factors and Latency

- RTF, Latency 측면에서도 ALO-VC가 가장 뛰어남

반응형

'Paper > Conversion' 카테고리의 다른 글

댓글