티스토리 뷰

Paper/TTS

[Paper 리뷰] EE-TTS: Emphatic Expressive TTS with Linguistic Information

feVeRin 2025. 7. 24. 17:02반응형

EE-TTS: Emphatic Expressive TTS with Linguistic Information

- 기존의 Text-to-Speech model은 expressive speech를 합성하는데 한계가 있음

- EE-TTS

- Text에서 appropriate emphasis position을 identify 하는 emphasis predictor를 도입

- 추가적으로 emphasis, linguistic information을 포함한 expressive speech를 합성하기 위해 conditional acoustic model을 활용

- 논문 (INTERSPEECH 2023) : Paper Link

1. Introduction

- Text-to-Speech (TTS) model은 여전히 expressiveness 측면에서 한계가 있음

- 여기서 emphasis는 pitch, phoneme duration, spectral energy와 같은 prosody의 여러 측면에 영향을 미치고, speech expressiveness를 결정하는데 중요한 역할을 함

- BUT, 기존 방식들은 highly expressive speech를 생성하지 못함 - 특히 emphasis의 position과 expression은 syntax와 text semantic에 크게 의존함

- 여기서 emphasis는 pitch, phoneme duration, spectral energy와 같은 prosody의 여러 측면에 영향을 미치고, speech expressiveness를 결정하는데 중요한 역할을 함

-> 그래서 syntax, semantic information을 활용하여 emphasis를 개선하는 EE-TTS를 제안

- EE-TTS

- Part-of-Speech (POS) 기반의 intra-word, Dependency Parsing (DP) 기반의 inter-word syntatic information과 pre-trained BERT를 통해 추출되는 semantic information을 incorporate

- Linguistic information extractor, Emphasis predictor를 사용하여 emphasis를 modeling

- 추가적으로 Continuous Wavelet Transform (CWT)을 활용해 dataset을 pseudo-labeling 한 다음 emphasis preidctor를 pre-training

< Overall of EE-TTS >

- Linguistic information과 emphasis predictor를 활용한 expressive TTS model

- 결과적으로 기존보다 우수한 성능을 달성

2. Method

- Overview

- EE-TTS는 FastSpeech2를 기반으로 emphasis position과 linguistic embedding을 condition으로 활용함

- 각 condition은 emphasis predictor와 linguistic encoder를 통해 얻어짐

- 이때 linguistic information extractor는 input text에서 syntatic, semantic information을 생성하여 emphasis predictor, linguistic encoder에 전달함 - 추가적으로 논문은 nuanced prosody를 modeling 하기 위해 hierarchical prosodic module을 도입함

- 각 condition은 emphasis predictor와 linguistic encoder를 통해 얻어짐

- Linguistic Information Extractor

- Linguistics에 inductive bias를 반영하기 위해 논문은 linguistic information extractor를 도입함

- 먼저 syntactic information을 추출하기 위해 input text를 segment 한 다음, 모든 word의 Part-of-Speech (POS) tag와 Dependency Parsing (DP) relation을 각각 intra-word, inter-word level로 predict 함

- 여기서 DP result는 graphically present 되고 각 word는 root word를 제외하고 하나의 out edge만 가짐 - Semantic information의 경우 pre-trained BERT를 사용하여 character-level에서 capture 됨

- Multi-level linguistic information은 text의 hierarchical structure를 reflect 함

- 먼저 syntactic information을 추출하기 위해 input text를 segment 한 다음, 모든 word의 Part-of-Speech (POS) tag와 Dependency Parsing (DP) relation을 각각 intra-word, inter-word level로 predict 함

- Conditioned Acoustic Model

- Acoustic model은 linguistic embedding과 emphasis position에 따라 speech를 합성함

- 특히 논문은 Conformer를 활용하여 local, global dependency를 모두 modeling 함

- 추가적으로 Conformer에서 input sequence의 varying length를 처리하고 accurate position information을 생성하기 위해 positional encoding을 적용함 - Emphasis position과 linguistic embedding은 추출된 linguistic information으로부터 생성됨

- 여기서 emphasis position은 emphasis predictor를 통해 제공되고, DP relation은 Graph2Relation operation을 통해 serialize 됨

- 해당 operation은 각 word의 out edge type을 label로 select 하고 root word에 대한 root label을 assign 함 - 이후 DP relation과 POS tag는 2개의 separate embedding layer로 전달되고 encoder output size와 맞추기 위해 phone-level length regulator를 사용하여 BERT output과 함께 expand 됨

- 최종적으로 POS embedding, DP embedding, BERT output은 linguistic embedding으로 sum 되어 encoder output에 add 됨

- 여기서 emphasis position은 emphasis predictor를 통해 제공되고, DP relation은 Graph2Relation operation을 통해 serialize 됨

- 특히 논문은 Conformer를 활용하여 local, global dependency를 모두 modeling 함

- Emphasis Predictor

- Emphasis predictor는 각 character node에 대한 initial vector를 생성함

- 이를 위해 intra-word POS tag를 embed 하고 character-level로 expand 한 다음 BERT의 character-level output과 concatenate 함

- DP relation의 경우,

- DP relation graph에 Begin of Sentence (BOS)와 End of Sentence (EOS) node를 add 하고,

- Gated Graph Neural Network (GGN)을 사용해 graph를 node initial vector로 encode 하여 character-level feature를 얻음

- 최종적으로 2개의 linear layer는 각 character에 대한 binary classification을 수행함

- $0$은 character에 emphasis가 없음을 의미하고, $1$은 emphasis가 있음을 의미함 - Character-level label은 이후 embedding layer로 전달되어 phone-level로 expand 되고 phone embedding과 concatenate 됨

- Pre-Train with Unsupervised Emphasis Labeling

- Emphasis가 포함된 large-scale labeled data를 확보하는 것은 어려우므로, 논문은 unlabeled data 기반의 pre-training, fine-tuning을 활용함

- 특히 unlabeled data에서 pitch, energy, duration signal에 대한 Continuous Wavelet Transform (CWT)를 통한 prominence score를 calcute 하여 pseudo emphasis label을 얻음

- 이후 해당 score는 pre-trained dataset에서 emphasize 여부를 나타내기 위해 2가지 category로 quantize 됨 - Acoustic model과 emphasis predictor는 해당 pseudo-emphasis label을 기반으로 pre-training 됨

- 특히 unlabeled data에서 pitch, energy, duration signal에 대한 Continuous Wavelet Transform (CWT)를 통한 prominence score를 calcute 하여 pseudo emphasis label을 얻음

3. Experiments

- Settings

- Dataset : Mandarin Datset (internal)

- Comparisons : FastSpeech2

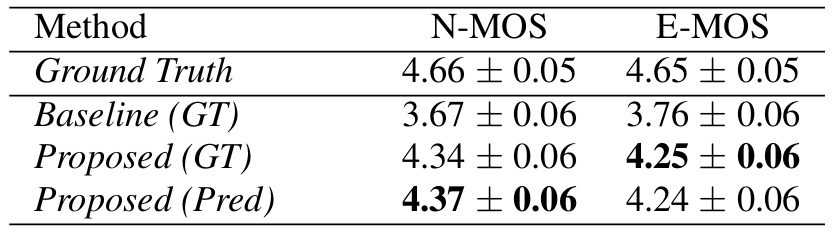

- Results

- 전체적으로 EE-TTS는 우수한 성능을 달성함

- AB test 측면에서도 EE-TTS가 더 선호됨

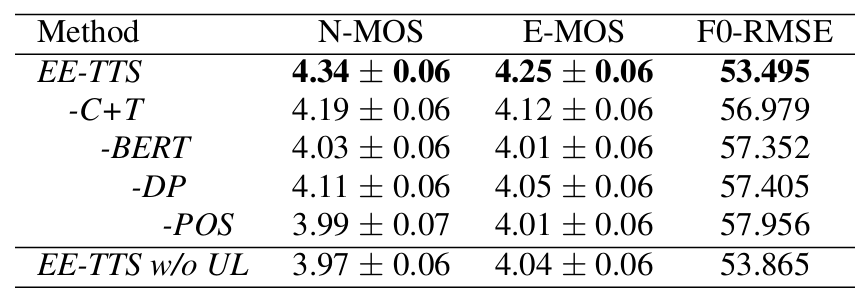

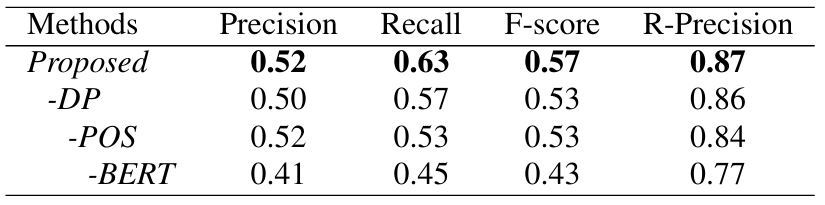

- Ablation Study

- 각 component를 제거하는 경우 성능 저하가 발생함

- Emphasis Predictor 역시 성능 향상에 중요한 역할을 함

반응형

'Paper > TTS' 카테고리의 다른 글

댓글