티스토리 뷰

Paper/TTS

[Paper 리뷰] QI-TTS: Question Intonation Control for Emotional Speech Synthesis

feVeRin 2024. 7. 30. 09:24반응형

QI-TTS: Question Intonation Control for Emotional Speech Synthesis

- Expressive text-to-speech는 intonation과 같은 fine-grained style이 무시되는 경우가 많음

- QI-TTS

- Reference speech의 emotion을 transfer 하면서 questioning intonation을 효과적으로 deliver 하기 위해 2가지의 서로 다른 level에서 style embedding을 추출하는 multi-style extractor를 활용

- Fine-grained intonation control을 위해 relative attribute를 통해 syllable level에서 intonation intensity를 represent 함

- Reference speech의 emotion을 transfer 하면서 questioning intonation을 효과적으로 deliver 하기 위해 2가지의 서로 다른 level에서 style embedding을 추출하는 multi-style extractor를 활용

- 논문 (ICASSP 2023) : Paper Link

1. Introduction

- Emotional speech synthesis를 위해 주로 reference audio를 활용하여 desired speech style을 반영하는 style-transfer text-to-speech (TTS)를 구성함

- 이를 위해 대표적으로 Global Style Token (GST), Variational AutoEncoder (VAE) 등을 활용할 수 있음

- BUT, learned setence-level style embedding을 emotion transfer에 활용하는 것만으로는 speaker attitude를 충분히 반영하지 못함

- Emotion embedding은 'angry statement', 'angry question' 같이 emotion과 intonation 간의 mutually exclusive combination을 동시에 모델링하지 못하기 때문 - 특히 speaker는 questioning intonation을 사용하여 delcarative question 형식으로 statement를 제시할 수 있음

- 따라서 single aspect에서 speech prosody를 모델링하는 것은 부적절하고, intention clarification을 위해 intonation을 반영할 수 있어야 함 - 결과적으로 expressive TTS는 다음에 대한 개선점을 가짐

- Normal statement 외에도 questioning과 같은 multiple, differential prosody를 모델링할 수 있어야 함

- Intonation expression은 상당히 다양하므로 specific intensity로 intonation을 flexibly deliver 할 수 있어야 함

- Expressiveness를 향상하기 위해 prosody와 다른 attribute를 disentangle 할 수 있어야 함

-> 그래서 앞선 expressive TTS의 한계를 개선한 QI-TTS를 제안

- QI-TTS

- FastSpeech2를 기반으로 sentence-level과 final syllable-level에서 emotion, intonation을 추출하는 multi-style extractor를 도입

- Relative attribute를 활용한 ranking function을 통해 각 audio sample에 intonation strength를 할당

- 추가적으로 content embedding과 style embedding 간의 information overlap을 최소화하기 위해 content predictor와 gradient reversal layer (GRL)을 적용

< Overall of QI-TTS >

- Reference audio의 emotion, intonation을 end-to-end manner로 deliver 하고, explicit label 없이 intonation intensity를 효과적으로 control 함

- 결과적으로 기존 방식보다 뛰어난 성능을 달성

2. Method

- QI-TTS는 FastSpeech2를 기반으로 ranking function이 포함된 multi-style extractor, Gradient Reversal Layer (GRL)이 포함된 content predictor로 구성됨

- Extractor는 sentence와 final syllable level에서 embedding 된 emotion과 intonation을 추출

- Ranking function은 relative intonation intensity를 output 하고 intonation intensity embedding으로 encode 함

- 이후 emotion, intonation embedding과 concatenate 하여 multi-style embedding을 구성 - GRL content predictor는 multi-style embedding에서 content information을 disentangle 함

- Multi-Style Extractor

- Sentence-final의 duration, fundamental frequency는 utterance의 다른 position과 다름

- 실제로 english에서 final syllable duration은 non-final syllable보다 1.53배 길고, endpoint $F0$의 absolute value는 question/statement를 distinguish 하는데 효과적임

- 따라서 논문은 duration variance와 intonation-related feature를 capture 하기 위해 final syllable을 포함하는 audio의 last 0.52초를 intonation으로 모델링함 - 추가적으로 reference speech에서 emotion, intonation information을 추출하기 위해 multi-style extractor를 도입함

- 해당 module은 reference encoder와 style token layer를 가지고, sentence의 mel-spectrogram과 final syllable의 mel-spectrogram이 모두 reference encoder에 전달됨

- $R_{s}, R_{f}$ : 각각 output sentence reference embedding, final syllable reference embedding - 이때 emotion, intonation 간의 relationship은 hierarchical 하지 않으므로 final syllable reference embedding의 효과는 sentence reference embedding과 overlap 될 수 있음

- 따라서 해당 overlap을 회피하기 위해 $R_{f}-R_{s}$를 사용하여 final syllable level의 residual embedding을 represent 함 - Emotion style embedding $G_{s}$와 intonation style embedding $G_{f}$는 $R_{f}$와 $R_{f}-R_{s}$를 해당 style token layer에 전달하여 얻어짐

- 이후 해당 embedding을 intonation intensity를 나타내는 ranking embedding과 concatenate 하여 multi-style embedding을 구성함

- 해당 module은 reference encoder와 style token layer를 가지고, sentence의 mel-spectrogram과 final syllable의 mel-spectrogram이 모두 reference encoder에 전달됨

- 실제로 english에서 final syllable duration은 non-final syllable보다 1.53배 길고, endpoint $F0$의 absolute value는 question/statement를 distinguish 하는데 효과적임

- Modelling Intonation Intensity

- 논문에서는 intensity label 없이 questioning intonation을 fine-grained control 하는 것을 목표로 함

- 해당 unsupervised intensity modeling을 위해 ranking-based method인 relative attribute를 활용함

- 여기서 questioning intensity를 learned relative attribute로 depict 할 수 있는 speech attribute로 취급

- Questioning intensity는 quenstioning intonation variation이 없는 경우 0이므로 questioning intensity를 statement와 question 간의 relative difference로 고려

- Training set $T=X_{t}$가 있고, $X_{t}$는 $t$-th training sample의 acoustic feature라고 하자

- $A,B$를 각각 question, statement set이라고 했을 때, QI-TTS는 다음의 ranking function을 학습해야 함:

(Eq. 1) $f(X_{t})=WX_{t}$

- $W$ : weighting matrix - Question의 intonation intensity는 statement보다 항상 높아야 하므로 다음의 constraint를 충족해야 함:

(Eq. 2) $\forall (X_{a}\in A\, \text{and}\, X_{b}\in B):WX_{a}>WX_{b}$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\forall (X_{a},X_{b})\in A \,\text{or}\,(X_{a},X_{b})\in B:WX_{a}=WX_{b}$ - 그러면 weighting matrix $W$를 추정하기 위해 다음을 solve 함:

(Eq. 3) $\min_{W}\left(\frac{1}{2}||W||_{2}^{2}+C \left(\sum\xi_{a,b}^{2}+\sum\gamma_{a,b}^{2} \right)\right)$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\text{s.t.}\,\, W(X_{a}-X_{b})\geq 1-\xi_{a,b};\,\,\, \forall(X_{a}\in A \,\text{and}\,X_{b}\in B),$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,|W(X_{a}-X_{b})|\leq \gamma_{a,b};\,\,\forall (X_{a},X_{b})\in A\,\text{or}\,(X_{a},X_{b})\in B,$

$\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\,\xi_{a,b}\geq 0;\gamma_{a,b}\geq 0$

- $C$ : slack variable $\xi_{a,b}^{2}$와 $\gamma_{a,b}^{2}$의 margin과 size 간의 trade-off

- $A,B$를 각각 question, statement set이라고 했을 때, QI-TTS는 다음의 ranking function을 학습해야 함:

- Relative ranking function $f(x)$가 training 되면, $[0,1]$ range의 normalized relative attribute가 speech sample에 대해 계산될 수 있음

- 이후 해당 attribute는 FC layer로 전달되어 intensity embedding $h_{i}$를 생성함 - 추론 시에는 reference speech나 manual instruction을 사용하여 fine-grained intonation control이 가능

- Reference audio를 analyze 하여 intensity를 예측하고 $[0,1]$ interval 내의 value를 수동 할당하는 방식

- 해당 unsupervised intensity modeling을 위해 ranking-based method인 relative attribute를 활용함

- Prediction Tasks

- Multi-style extractor는 reference audio에서 multi-level style을 unsupervisedly learning 함

- 이때 논문은 emotion, intonation prediction task를 추가하여 각 level module이 해당 style을 효과적으로 학습하도록 함

- Emotion predictor는 cross-entropy (CE) loss를 사용하고, intonation loss function은 sparse question label로 인해 weighted cross-entropy를 사용:

(Eq. 4) $L=-\hat{y}_{1}\log y_{1}-\sigma \hat{y}_{2}\log y_{2}$

- $[\hat{y}_{1},\hat{y}_{2}]$ : statement, question category의 probability

- $[y_{1},y_{2}]$ : ground-truth label의 one-hot encoding

- $\sigma$ : balance parameter - Adversarial content predictor network는 Mask-And-Predict (MAP)를 활용하여 multi-style embedding에서 overlapped content information을 disentangle 하도록 설계됨

- Network는 gradient reverse layer와 content predictor로 구성

- Predictor는 $L_{content}=||\hat{c}-c||_{1}$의 loss를 최소화하여 content representation을 예측하도록 training 됨

- $c, \hat{c}$ : 각각 phoneme encoder에 의해 생성된 content embedding, adversarial content predictor output - Multi-style embedding에 포함된 content information을 최소화하기 위해 gradient가 reverse 된 다음, multi-style extractor로 backpropagate 됨

3. Experiments

- Settings

- Dataset : ESD

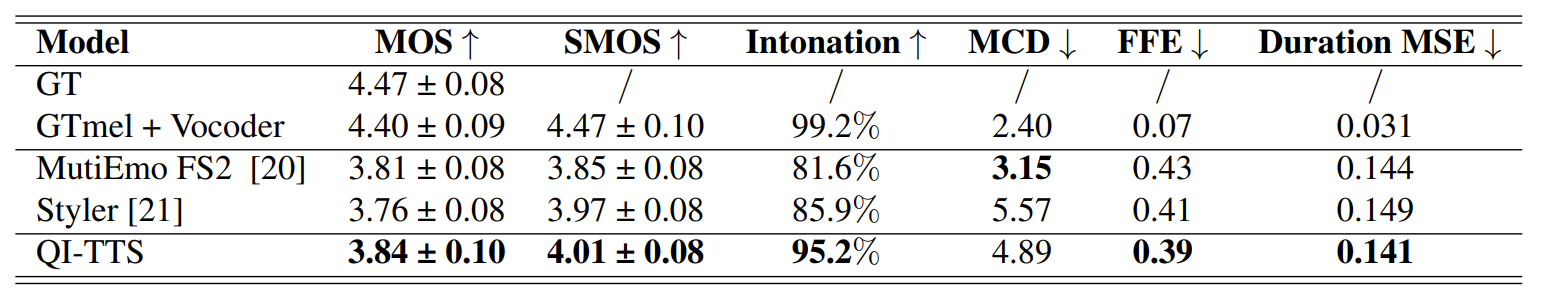

- Comparisons : Multi-Emotional FastSpeech2, Styler

- Results

- 전체적으로 QI-TTS가 가장 우수한 성능을 달성함

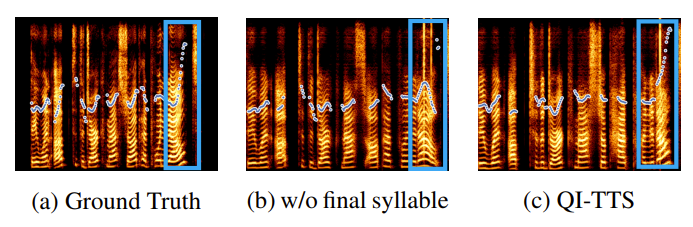

- Mel-spectrogram 측면에서도 ground-truth와 비슷한 합성 결과를 보임

- Ablation study 측면에서 각 component를 제거하는 경우 성능 저하가 발생함

- Intonation intensity control 성능을 확인하기 위해 Best-Worst Scaling (BWS) test를 수행해 보면, QI-TTS는 emotion을 효과적으로 반영할 수 있음

반응형

'Paper > TTS' 카테고리의 다른 글

댓글