티스토리 뷰

Paper/Vocoder

[Paper 리뷰] StyleMelGAN: An Efficient High-Fidelity Adversarial Vocoder with Temporal Adaptive Normalization

feVeRin 2024. 5. 1. 10:21반응형

StyleMelGAN: An Efficient High-Fidelity Adversarial Vocoder with Temporal Adaptive Normalization

- Lightweight neural vocoder는 여전히 perceptual quailty 측면에서 열등한 성능을 보임

- StyleMelGAN

- 낮은 complexity를 가지면서 high-fidelity의 음성을 합성할 수 있는 lightweight neural vocoder

- Temporal Adaptive Normalization을 사용하여 target speech의 acoustic feature로 low-dimensional noise vector를 style 함

- Random Window Discriminator는 multi-scale spectral reconstruction loss에 의해 제공되는 regularization을 통해 filter bank에서 analyze 된 speech signal을 adversarially evaluate 함

- 논문 (ICASSP 2021) : Paper Link

1. Introduction

- Neural vocoder는 text-to-speech (TTS), speech coding, speech enhancement 등의 다양한 task에서 우수한 성능을 보이고 있음

- BUT, 대부분의 neural vocoder는 computational cost가 상당히 높고 합성 속도가 느림

- 이러한 추론 속도 문제를 개선하기 위해 Generative Adversarial Network (GAN)을 사용할 수 있음

- BUT, 빠른 생성 속도에 비해 합성된 음성의 품질은 여전히 만족스럽지 않음

-> 그래서 낮은 computational cost로 고품질의 음성 합성이 가능한 StyleMelGAN을 제안

- StyleMelGAN

- GAN architecture를 기반으로 feature modulation method를 적용하기 위해, Temporal Adaptive DEnormalization (TADE)를 generator block에 삽입

- 이러한 conditioning feature inserting을 통해 모델은 더 효율적으로 동작할 수 있음 - 이때 adversarial loss는 Pseudo Quadrature Mirror Filter Bank (PQMF) 다음에 이어지는 4개의 discriminator의 ensemble에 의해 계산됨

- 이를 통해 training 중에 음성의 다양한 frequency band를 analyze 할 수 있음 - Robust, generalize 한 training을 위해 discriminator는 generator의 input acoustic feature로 condition 되지 않고, 대신 random window에서 sampling 된 signal을 사용함

- GAN architecture를 기반으로 feature modulation method를 적용하기 위해, Temporal Adaptive DEnormalization (TADE)를 generator block에 삽입

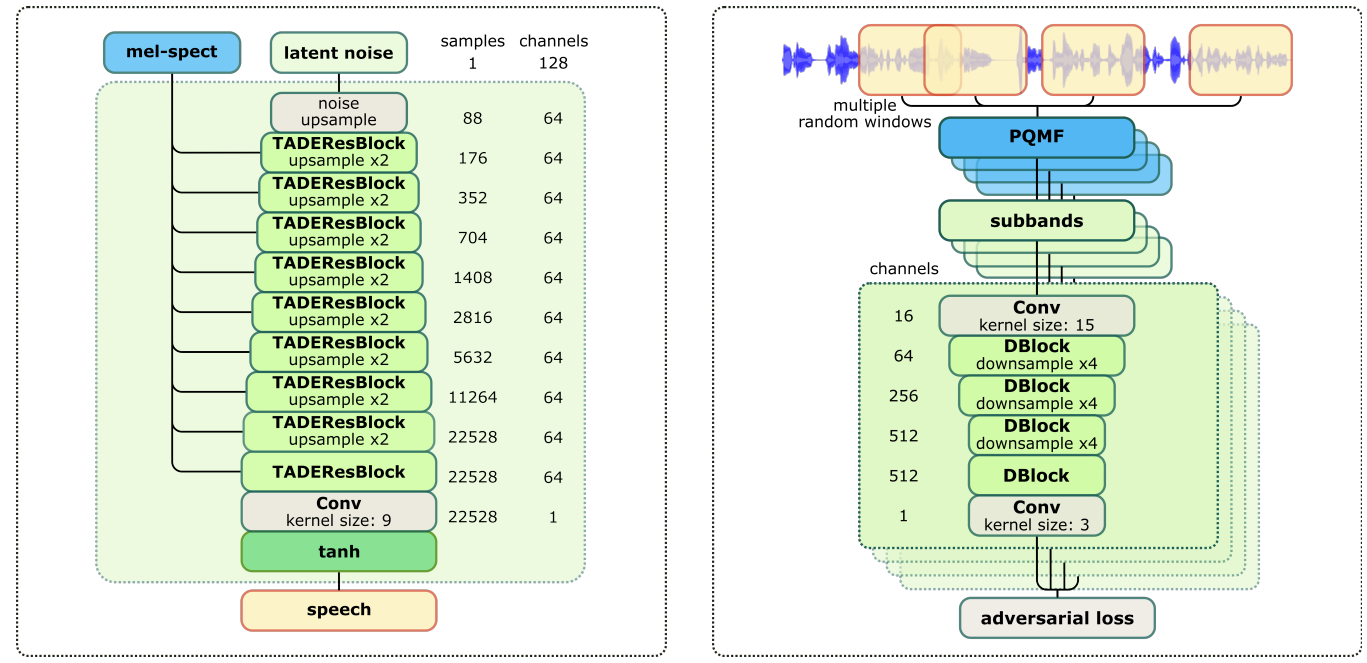

< Overall of StyleMelGAN >

- TADE layer를 통해 generator를 highly parallelizable, completely convolutional 하게 구성

- Multi-scale spectral reconstruction loss로 regularize 된 PQMF multi-sampling random window discriminator의 ensemble을 사용하여 generator를 adversarially training

- 결과적으로 기존보다 우수한 합성 품질을 달성하면서, 빠른 추론 속도를 확보

2. Method

- Generator Architecture

- Generator는 mel-spectrogram을 condition으로 하여 점진적인 upsampling을 통해 noise vector $z\sim\mathcal{N}(0,I_{128})$을 22.05kHz의 waveform으로 mapping 함

- 이때 normalized activation map의 linear modulation을 기반으로 한 Temporal Adaptive DEnormalization (TADE)를 사용

- 여기서 modulation parameter $\gamma, \beta$는 conditioning feature로부터 adaptive 하게 학습되고, input activation signal과 동일한 dimension을 가짐

- 이를 통해 generator의 모든 layer에 conditioning feature를 제공하게 되므로 모든 upsampling stage에서 signal strcutre가 preserving 됨 - 아래 그림과 같이 TADE layer의 input activation은 instance normalization을 통해 normalize 되어 $\gamma \odot c+\beta$를 통해 adaptively modulate 되는 content feature map $c$를 생성함

- $\odot$ : element-wise mulitplication

- 이러한 normalization과 modulation의 조합을 통해 generator에서 style transfer process를 수행할 수 있음 - 추가적으로 generator는 ReLU activation 대신 Softmax-gated tanh activation을 사용하여 waveform 생성 시 artifact 발생을 방지함

- 전체 generator architecture는 8번의 upsampling stage로 구성됨

- 각 stage는 TADEResBlock과 $2\times$ upsampling layer, 1개의 final activation module로 구성됨

- Final activation은 1개의 TADEResBlock과 tanh non-linearity를 가지는 channel-change convolution layer로 구성됨

- 해당 architecture를 사용하면 maximum dilation factor 2에 대해 64의 channel depth만을 사용할 수 있으므로 computational complexity를 줄일 수 있음

- 이때 normalized activation map의 linear modulation을 기반으로 한 Temporal Adaptive DEnormalization (TADE)를 사용

- Filter Bank Random Window Discriminators

- StyleMelGAN은 adversarial training을 위해 4개의 discriminator를 사용함

- 각각의 discriminator는 Multi-Band MelGAN의 architecture를 기반으로 하지만, downsampling에 대한 average pooling은 사용하지 않음

- 추가적으로 각 discriminator는 input speech waveform에서 slice 된 random window에서 동작하면서, PQMF를 통해 얻은 input speech signal의 sub-band를 analyze 함

- 이때 1초의 waveform에서 추출된 512, 1024, 2048, 4096 sample의 random window에서 각각 계산된 1, 2, 4, 8개의 sub-band를 사용 - 이를 통해 얻어지는 Filter Bank Randow Window Discriminator (FB-RWD)의 구조는 아래 그림과 같음

- 결과적으로 FB-RWD를 통해 StyleMelGAN은 time, frequency domain 모두에서 speech signal에 대한 multi-resolution adversarial evaluation이 가능해짐

- 각각의 discriminator는 Multi-Band MelGAN의 architecture를 기반으로 하지만, downsampling에 대한 average pooling은 사용하지 않음

- Training Procedure

- GAN training 과정에서 weight에 대한 random initialization을 사용하면 adversarial loss로 인해 audio artifact 발생과 unstable training으로 이어짐

- 이를 해결하기 위해 StyleMelGAN은 Parallel WaveGAN의 training procedure를 따름

- 먼저 generator는 서로 다른 STFT에서 계산된 log-magnitude와 spectral convergence의 error estimates로 구성된 spectral reconstruction loss $\mathcal{L}_{aux}$만을 사용하여 pretrain 됨

- 이를 통해 얻어지는 generator는 high-frequency에서 상당히 smearing 되어 있는 tonal signal을 생성할 수 있음

- 결과적으로 adversarial training 과정에서 random initialization 보다 더 나은 harmonic structure를 활용 가능 - 이후 adverasrial training을 통해 tonal effect를 제거하고 smeared frequency band를 sharpening 하여 naturalness를 향상함

- 먼저 generator는 서로 다른 STFT에서 계산된 log-magnitude와 spectral convergence의 error estimates로 구성된 spectral reconstruction loss $\mathcal{L}_{aux}$만을 사용하여 pretrain 됨

- 해당 adversarial training을 위해, 논문에서는 hinge loss를 사용하여 $k=1,2,3,4$의 각 discriminator $D_{k}$의 adversarial metric을 evaluate 함

- 이때 spectral reconstruction loss $\mathcal{L}_{aux}$ 역시 adversarial artifact의 발생을 방지하기 위해 regularization으로 사용됨 - 결과적으로 final generator objective는:

(Eq. 1) $\min_{G}\left(\mathbb{E}_{z}\left[\sum_{k=1}^{4}-D_{k}(G(s,z))\right]+\mathcal{L}_{aux}(G)\right)$

- $s$ : mel-spectrogram과 같은 conditioning feature, $z$ : latent noise

- Weight normalization은 $G, D_{k}$의 모든 convolution operation에 적용됨

- 이를 해결하기 위해 StyleMelGAN은 Parallel WaveGAN의 training procedure를 따름

3. Experiments

- Settings

- Dataset : LJSpeech

- Comparisons : MelGAN, Parallel WaveGAN, WaveGlow, WaveNet

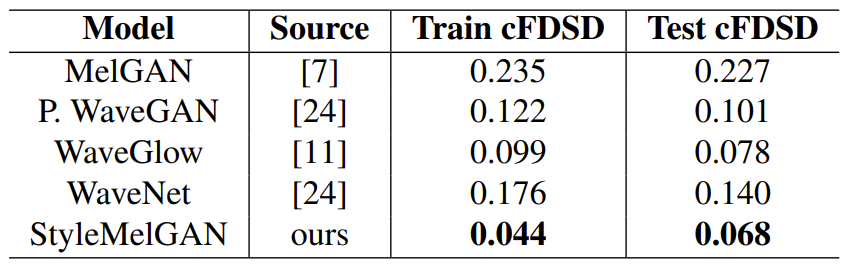

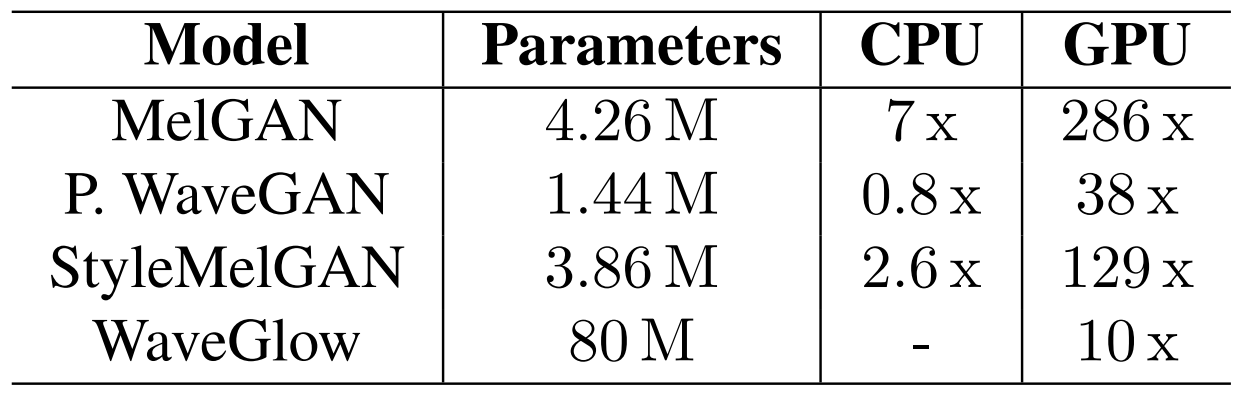

- Results

- 합성 결과에 대해 정량적인 평가를 수행해 보면, StyleMelGAN이 가장 우수한 성능을 보임

- MUSHRA 측면에서도 StyleMelGAN은 다른 모델들보다 뛰어남

- Transformer v3를 사용하여 TTS 측면에서 각 vocoder들을 평가해 보면, 마찬가지로 StyleMelGAN이 가장 뛰어난 것으로 나타남

- 추가적으로 StyleMelGAN은 complexity 측면에서도 빠르고 합리적임

반응형

'Paper > Vocoder' 카테고리의 다른 글

댓글