티스토리 뷰

Paper/Neural Codec

[Paper 리뷰] Codec Does Matter: Exploring the Semantic Shortcoming of Codec for Audio Language Model

feVeRin 2025. 8. 2. 07:39반응형

Codec Does Matter: Exploring the Semantic Shortcoming of Codec for Audio Language Model

- 기존 audio codec은 audio compression을 위해 설계되어 있으므로 Large Language Model에서 최적의 성능을 발휘하기 어려움

- X-Codec

- Residual Vector Quantization 이전에 pre-trained semantic encoder를 incorporate

- Residual Vector Quantization 이후에는 semantic reconstruction loss를 적용

- 논문 (AAAI 2025) : Paper Link

1. Introduction

- AudioLM, VALL-E와 같이 audio generation을 위해 Large Language Model (LLM)이 자주 활용됨

- 특히 SoundStream과 같은 audio codec은 audio LLM에서 continuous audio waveform과 token-based language model을 bridge 하기 위해 사용됨

- 해당 codec은 high-rate audio signal을 finite token set으로 discretize 하여 LLM architecture를 지원함 - BUT, DAC, HiFi-Codec과 같은 기존 audio codec은 low-compression rate, high-reconstruction quality를 달성하는 것을 목표로 함

- 즉, 대부분 audio compression을 목적으로 하므로 audio language modeling과는 misalignment가 있음

- 특히 SoundStream과 같은 audio codec은 audio LLM에서 continuous audio waveform과 token-based language model을 bridge 하기 위해 사용됨

-> 그래서 audio content understanding에 초점을 맞춘 audio tokenizer인 X-Codec을 제안

- X-Codec

- Semantic, acoustic feature를 integrate 한 unified tokenization framework

- 2개의 input, 2개의 output에 기반한 X-shaped structure를 사용하여 Residual Vector Quantization (RVQ) 내에서 semantic, acoustic information을 unify

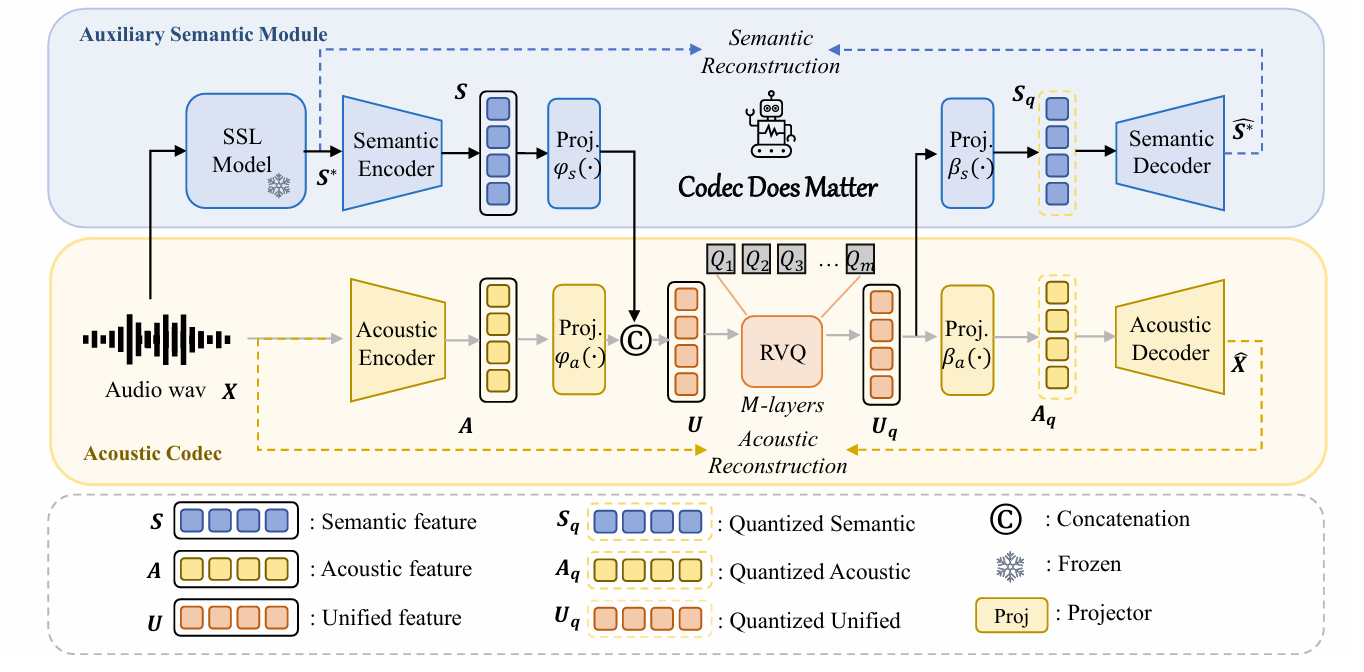

< Overall of X-Codec >

- Semantic, acoustic information을 combine 하여 audio understanding capability를 향상한 neural codec

- 결과적으로 audio generation task에서 기존 codec 보다 뛰어난 성능을 달성

2. Method

- Acoustic Audio Codec

- X-Codec은 EnCodec, DAC framework를 기반으로 acoustic encoder, quantizer, acoustic decoder로 구성됨

- Waveform sample 수를 $n$이라고 하면, codec input은 $\mathbf{X}\in \mathbb{R}^{n}$과 같음

- 해당 waveform은 acoustic encoder에 input 되어 frame-level latent acoustic feature $\mathbf{A}\in\mathbb{R}^{H_{a}\times T}$를 추출함

- $H_{a}$ : acoustic feature의 hidden size, $T$ : frame 수 - 이후 continuous feature는 $M$ quantizer layer를 가진 Residual Vector Quantization (RVQ)를 사용하여 discrete token $\mathbf{Q}\in\mathbb{R}^{M\times T}$로 transform 됨

- 이때 quantizer의 specific codebook이 학습되므로, discrete token을 continuous feature $\mathbf{A}_{q}\in\mathbb{R}^{H_{a}\times T}$로 다시 transform 할 수 있음 - Acoustic decoder는 temporal upsampling을 사용하여 $\mathbf{A}_{q}$로부터 waveform $\hat{\mathbf{X}}$를 reconstruct 함

- 해당 waveform은 acoustic encoder에 input 되어 frame-level latent acoustic feature $\mathbf{A}\in\mathbb{R}^{H_{a}\times T}$를 추출함

- Training process는 mel-loss, STFT loss, GAN loss 등을 통해 supervise 됨

- Waveform sample 수를 $n$이라고 하면, codec input은 $\mathbf{X}\in \mathbb{R}^{n}$과 같음

- Analysing Semantic Shortcoming

- Text-to-Speech (TTS)에 language modeling을 접목한 VALL-E를 통해 acoustic codec을 분석해 보면

- 아래 표와 같이 VALL-E를 EnCodec을 통해 training 하는 경우, 높은 WER과 content generation 측면에서 frequent inaccuracy가 나타남

- 즉, EnCodec은 inadequate semantic processing capability로 인해 phoneme을 differentiate 하지 못함 - 이를 해결하기 위해서는 codec architecture에 comprehensive semantic feature를 integrate 하여 language model의 interpreting load를 alleviate 해야 함

- 아래 표와 같이 VALL-E를 EnCodec을 통해 training 하는 경우, 높은 WER과 content generation 측면에서 frequent inaccuracy가 나타남

- Designing Auxiliary Semantic Module

- X-Codec은 semantic, acoustic feature를 directly concatenate 하여 audio codec을 개선함

- 먼저 audio waveform $\mathbf{X}$에 HuBERT, Wav2Vec 2.0과 같은 self-supervised model을 적용하여 semantic feature vector $\mathbf{S}^{*}\in\mathbb{R}^{H_{s}\times T}$를 추출함

- 추출된 feature는 semantic encoder를 통해 process 되어 refined semantic feature vector $\mathbf{S}$를 yield 하고, acoustic branch는 feature $\mathbf{A}$를 produce 함

- 해당 output $\mathbf{S},\mathbf{A}$는 linear projection $\phi$를 통해 concatenate 됨:

(Eq. 1) $\mathbf{U}=\text{concat}\left(\phi_{s}(\mathbf{S}),\phi_{a}(\mathbf{A}) \right)$

- $\mathbf{U}\in\mathbb{R}^{H_{u}\times T}$ : concatenated feature로써, semantic/acoustic source의 information preservation을 maximize 하는 것을 목표로 함 - Combined feature는 $M$-layer quantizer를 사용하는 RVQ로 전달되어 sematic, acoustic-rich token을 생성함

- Quantized feature $\mathbf{U}_{q}$는 decoder가 original semantic feature $\hat{\mathbf{S}}^{*}$과 audio waveform $\hat{\mathbf{X}}$를 reconstruct 할 수 있도록 2개의 projector $\beta_{s},\beta_{a}$를 사용함

- 이때 논문은 semantic reconstruction을 위해 Mean Squared Error (MSE) loss를 도입하고, constant weight $\gamma$를 적용하여 training objective를 balance 함

- 먼저 audio waveform $\mathbf{X}$에 HuBERT, Wav2Vec 2.0과 같은 self-supervised model을 적용하여 semantic feature vector $\mathbf{S}^{*}\in\mathbb{R}^{H_{s}\times T}$를 추출함

3. Experiments

- Settings

- Dataset : LibriSpeech, MLS

- Comparisons : EnCodec, DAC, SpeechTokenizer

- Results

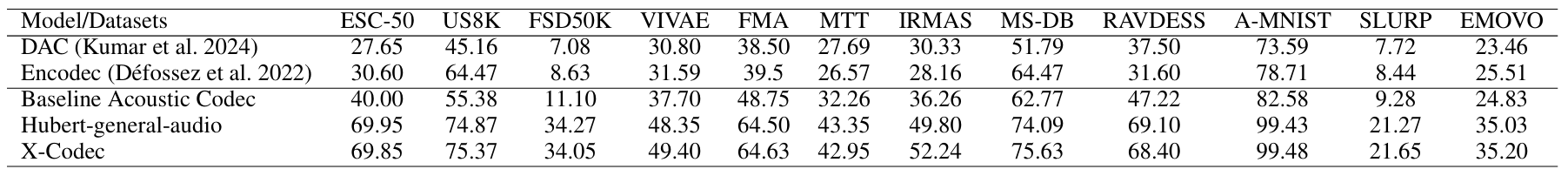

- Phonetic discriminability 측면에서 X-Codec은 우수한 성능을 보임

- Reconstruction 측면에서도 높은 MOS를 달성함

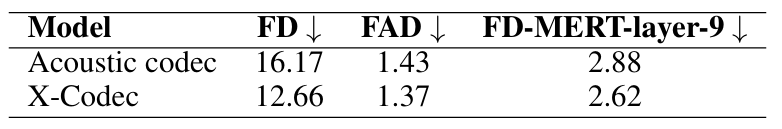

- Music and Sound Generation

- Music continuation task에서 X-Codec은 기존보다 우수한 성능을 달성함

- X-Codec은 Text-to-Sound task에서도 뛰어난 성능을 보임

- 다양한 benchmark에 대해 X-Codec은 우수한 semantic understanding ability를 보임

반응형

'Paper > Neural Codec' 카테고리의 다른 글

댓글