티스토리 뷰

Paper/TTS

[Paper 리뷰] RAD-MMM: Multilingual Multiaccented Multispeaker Text to Speech

feVeRin 2024. 7. 19. 09:37반응형

RAD-MMM: Multilingual Multiaccented Multispeaker Text to Speech

- Individual voice characteristic을 retaining 하면서 native accent를 가지는 음성을 생성할 수 있는 multilingual system이 요구됨

- 이를 위한 bilingual data는 expansive 하지만, 해당 data가 부족한 경우 speaker, language, accent 간의 entangle로 인해 합성 성능이 저하됨

- RAD-MMM

- Accent, language, speaker, fine-grained $F_{0}$, energy feature를 explicit control 하는 RAD-TTS를 기반으로 multilingual task로 확장

- 7개의 language로 구성된 dataset을 활용하여 다양한 speaker의 accent를 control

- 논문 (INTERSPEECH 2023) : Paper Link

1. Introduction

- Text-to-Speech (TTS)에서 대부분의 모델은 speaker embedding table을 학습하는 방식으로 speaker selection을 지원하므로 speaker, language, accent 등을 desired combination으로 control 할 수 없음

- 특히 bilingual dataset을 얻는 것은 expansive하고 dataset 내의 각 speech attribute는 highly-correlated 되어 있음

- 따라서 해당 entangled dataset으로 TTS 모델을 training하는 경우, transferability가 크게 저하됨 - 해당 문제를 해결하기 위해 YourTTS, VALL-E는 zero-shot multilingual conversion에 중점을 둠

- BUT, 여전히 활용할 수 있는 language가 제한적이고 training process를 확장하기 어렵다는 한계가 있음 - 한편으로 FastPitch, FastSpeech2와 같이 $F_{0}$, energy 등의 fine-grained speech attribute를 factorizing 하면 desired conmbination을 효과적으로 반영할 수 있음

- 특히 bilingual dataset을 얻는 것은 expansive하고 dataset 내의 각 speech attribute는 highly-correlated 되어 있음

-> 그래서 accent, speaker 등에 대한 fine-grained control을 지원하기 위해 monolingual TTS를 확장한 RAD-MMM을 제안

- RAD-MMM

- Shared alphabet set와 alignment learning framework를 사용하여 single language TTS를 multilingual TTS로 확장

- Accent를 control하기 위한 explicit accent conditioning을 도입

- Multilingual speaker에 의존하지 않고 speaker, accent, language, text 등을 효과적으로 disentangling

- $F_{0}$, energy와 같은 speech attribute의 fine-grained control과 speaker timbre retention 효과를 탐색

< Overall of RAD-MMM >

- Accent, language, speaker, fine-grained $F_{0}$, energy feature를 explicit control 하는 RAD-TTS를 multilingual task로 확장

- 결과적으로 기존보다 우수한 합성 품질과 fine-grained control을 지원

2. Method

- RAD-MMM은 RAD-TTS를 기반으로 구축됨

- 이때 encoded text $\Phi\in \mathbb{R}^{C_{txt}\times T}$, accent $A\in \mathbb{R}^{D_{accent}}$, speaker $S\in \mathbb{R}^{D_{speaker}}$를 conditioning variable로 하여 mel-spectrogram $X\in \mathbb{R}^{C_{mel}\times F}$를 합성함

- 추가적으로 fundamental frequency $F_{0}\in \mathbb{R}^{1\times F}$, energy $\xi\in \mathbb{R}^{1\times F}$를 optional conditioning으로 사용할 수 있음

- $F$ : mel-frame 수, $T$ : text length - 논문에서는 phoneme sequence 내에 language가 implicit되어 있다고 가정하므로 conditioning을 accent로 취급함

- 이때 accent embedding으로 capture된 information은 다양한 language에서 phoneme이 pronounce 되는 방식의 fine-grained difference를 설명할 수 있어야 함

- Shared Text Token Set

- RAD-MMM은 dataset의 모든 speaker에 대해 desired accent로 target language를 합성하는 것을 목표로 함

- 먼저 phoneme-based shared textual representation을 얻기 위해 International Phonetic Alphabet (IPA)로 text token을 represent 함

- Shared alphabet은 speaker identity에 대한 의존성을 줄이고 code-switching을 지원할 수 있음

- Scalable Alignment Learning

- External aligner 없이 speech-text alignment $\Lambda \in \mathbb{R}^{T\times F}$를 학습하기 위해 RAD-TTS의 alignment learning을 활용함

- 이때 shared alphabet set는 distinct set 대신 single token set에서 학습됨

- BUT, speaker accent의 차이로 인해 동일한 token을 다른 방식으로 spoken할 수 있으므로 alignment가 brittle 해짐 - 따라서 해당 multi-modality를 curb 하기 위해 accent $A$를 conditioning variable로 사용하여 $(\text{text, accent})$와 mel-spectrogram 간의 alignment를 학습함

- 이때 shared alphabet set는 distinct set 대신 single token set에서 학습됨

- Disentangling Factors

- 논문은 text $\Phi$, accent $A$, speaker $S$가 entangle되어있는 non-parallel data에서 각 attribute를 distentangle 하도록 다음의 startegy들을 활용함

- Speaker-Adversarial Loss

- TTS dataset 내에는 speaker $S$, text $\Phi$, prosody 간에 entanglement가 존재하므로 domain adversarial training을 도입하여 gradient reversal layer를 통해 $S, \Phi$를 disentangle함:

(Eq. 1) $\mathcal{L}_{adv} =\sum_{i=1}^{N} P(s_{i}| \phi_{i};\theta_{spkclassifier})$ - 이때 speaker classification loss를 활용하고, text encoder와 token embedding을 통해 classifier의 negative gradient를 backpropagte 함

- TTS dataset 내에는 speaker $S$, text $\Phi$, prosody 간에 entanglement가 존재하므로 domain adversarial training을 도입하여 gradient reversal layer를 통해 $S, \Phi$를 disentangle함:

- Data Augmentation

- Speaker와 accent 간에는 strong association이 존재하므로 speaker와 accent를 disentangle 하는 것은 어려움

- 특히 non-parallel data에서 해당 문제를 해결하지 않으면, speaker language와 accent가 dataset에서 trivially train 될 수 있음 - 따라서 desired accent가 있는 target language speaker에 대한 음성을 합성하기 위해서는, speaker $S$와 accent $A$를 disentangle 해야 함

- 이를 위해 논문은 formant, $F_{0}$, duration scaling과 같은 data augmentation을 도입

- 먼저 speaker identity $s_{i}$와 accent $a_{i}$를 가지는 speech sample $x_{i}$에 대해 fixed transformation $t=\{1,2,...,\tau\}$를 적용하여 transformed speech sample $x_{i}^{t}$를 얻음

- 그리고 speaker identity를 $s_{i}+t\cdot N_{speakers}$로 assign 하고 accent를 original accent $a_{i}$로 설정함

- $\tau$ : augmentation 수

- 결과적으로 fixed accent를 통해 speaker identity variant가 있는 sample을 생성함으로써 decorrelate 할 수 있음

- Speaker와 accent 간에는 strong association이 존재하므로 speaker와 accent를 disentangle 하는 것은 어려움

- Embedding Regularization

- 추가적으로 accent, speaker embeding 간의 disentanglement를 위해 다음의 variable을 decorrelate 함:

- Accent embedding의 random variable

- Speaker embedding의 random variable

- Speaker, accent embedding 간의 random variable - 이때 VICReg의 constraint를 사용하여 decorrelation을 수행할 수 있음

- 먼저 $E^{A} \in \mathbb{R}^{D_{a}\times N_{a}}, E^{S}\in \mathbb{R}^{D_{s}\times N_{s}}$를 각각 accent, speaker embedding table이라고 하자

- 그러면 column vector $e^{j}\in E$는 $j$-th embedding을 나타내고, $\mu_{E}$와 $\text{Cov}(E)$는 각각 평균, 공분산 matrix를 나타냄 - 이후 VICReg를 사용하여 표준편차를 최소 $\gamma$를 가지도록 constrain 하고, 공분산 matrix ($\gamma=1,\epsilon=1e-4$)의 off-diagonal element를 suppress 함:

(Eq. 2) $\mathcal{L}_{var}=\frac{1}{D}\sum_{i=j} \max\left(0,\gamma-\sqrt{\text{cov}(E)_{i,j}+\epsilon}\right)$

(Eq. 3) $\mathcal{L}_{covar}=\sum_{i\neq j}\text{Cov}(E)^{2}_{i,j}$

- 먼저 $E^{A} \in \mathbb{R}^{D_{a}\times N_{a}}, E^{S}\in \mathbb{R}^{D_{s}\times N_{s}}$를 각각 accent, speaker embedding table이라고 하자

- 최종적으로 batch statistics에서 cross-correlation matrix를 최소화하여 accent, speaker variable을 decorrelate 함

- $\tilde{E}^{A}, \tilde{E}^{S}$를 batch size $B$에서 sampling 된 accent, speaker embedding vector의 sampled column matrix라고 하자

- 그러면 batch cross-correlation matrix $R^{AS}$는 embedding table에서 계산된 $\mu_{E^{A}}, \mu_{E^{S}}$로부터 다음과 같이 얻어짐:

(Eq. 4) $R^{AS}=\frac{1}{B-1}(\tilde{E}^{A}-\mu_{E^{A}})(\tilde{E}^{S}-\mu_{E^{S}})^{T}$

(Eq. 5) $\mathcal{L}_{xcorr}=\frac{1}{D_{a}D_{s}}\sum_{i,j}\left( R_{i,j}^{AS}\right)^{2}$

- 추가적으로 accent, speaker embeding 간의 disentanglement를 위해 다음의 variable을 decorrelate 함:

- Speaker-Adversarial Loss

- Accent Conditioned Speech Synthesis

- Accent controllable synthesis를 위해 accent $A$에 대한 extra conditioning variable을 RAD-TTS에 도입하여 다음과 같은 multilingual version의 RADTTS-ML을 얻을 수 있음:

(Eq. 6) $P_{radtts}(X,\Lambda)=P_{mel}(X|\Phi, \Lambda,A,S)P_{dur}(\Lambda | \Phi,A,S)$

- Fine-grained Frame-level Control of Speech Attributes

- $F_{0}$와 energy $\mathcal{E}$와 같은 speech attribute를 fine-grained control 하면 고품질의 음성 합성이 가능함

- 따라서 논문은 training 중에 ground-truth frame-level $F_{0}$와 energy에 따라 mel-decoder를 condition 함

- 추가적으로 deterministic attribute predictor를 training 하여 speaker $S$, encoded text $\Phi$, accent $A$에 대한 phoneme duration $\Lambda$, $F_{0}$, energy $\mathcal{E}$를 예측함

- 이때 speaker $F_{0}$ 평균, 표준편차를 사용하여 $F_{0}$를 standardize 해 speaker-dependent information을 제거 - 결과적으로 얻어지는 RAD-MMM은 모든 speaker, accent, language에 대한 speech attribute를 예측하고 해당 feature로 mel-synthesis를 control 할 수 있음:

(Eq. 7) $P_{radmmm}(X)=P_{mel}(X| \Phi,\Lambda^{h},A,S,F_{0}^{h},\mathcal{E}^{h})$

3. Experiments

- Settings

- Dataset : English, Spanish, German, French, Hindi, Portuguese, Spanish speech dataset (아래 표 참고)

- Comparisons : Tacotron2, RAD-TTS

- Results

- Ablation of Disentanglement Strategies

- Disentanglement의 효과를 알아보기 위해 다음과 같이 정의되는 Character Error Rate (CER)을 활용:

(Eq. 8) $CER=\frac{\text{substitutions} + \text{deletions}+\text{insertions}}{\text{substitutions}+ \text{deletions}+\text{correct}}\times 100$ - 결과적으로 disentanglement를 적용한 RAD-MMM이 기존 RAD-TTS 보다 낮은 CER을 보임

- Disentanglement의 효과를 알아보기 위해 다음과 같이 정의되는 Character Error Rate (CER)을 활용:

- Ablation study 측면에서도 RAD-MMM의 각 component를 제거하는 경우 성능 저하가 발생함

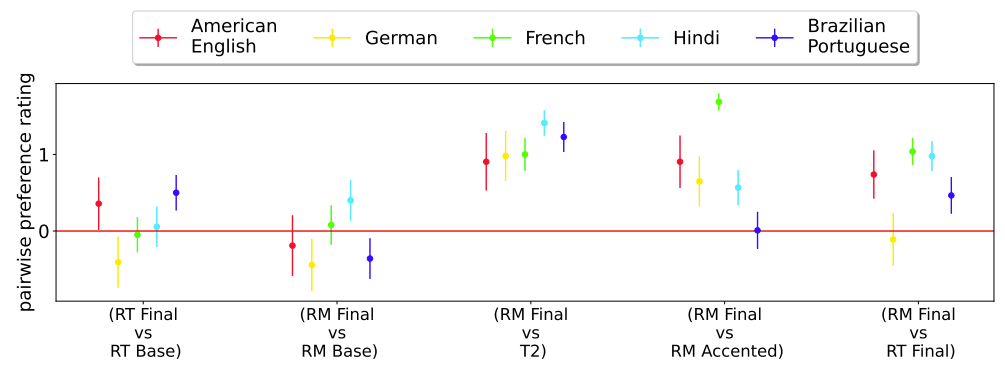

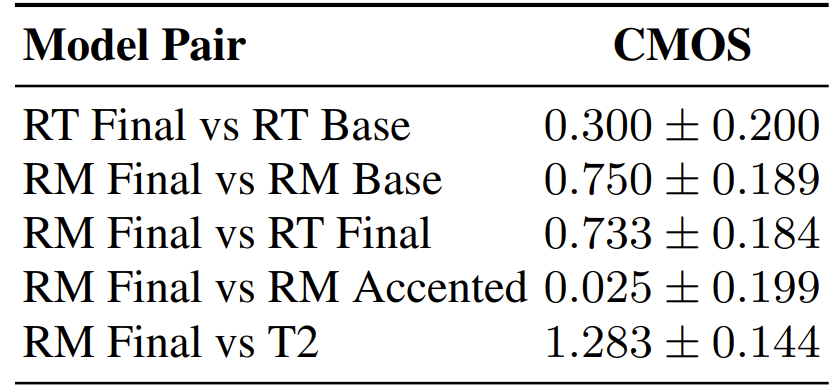

- Comparing Proposed Models with Existing Methods

- Speaker timbre retention 측면에서 RAD-MMM은 다른 모델들보다 높은 cosine similarity를 보임

- Accent similarity에서도 RAD-MMM이 더 높은 CMOS를 달성함

- Speaker timbre에서도 RAD-MMM은 기존 모델과 큰 차이를 보임

- Speaker and Accent Role Assignment

- Role assignment 측면에서 RAD-MMM은 mono-/cross-lingual 합성 모두에서 낮은 CER을 달성함

- PER을 통한 accent 품질 역시 큰 차이를 보이지 않음

반응형

'Paper > TTS' 카테고리의 다른 글

댓글