티스토리 뷰

Paper/TTS

[Paper 리뷰] Mels-TTS: Multi-Emotion Multi-Lingual Multi-Speaker Text-to-Speech System via Disentangled Style Tokens

feVeRin 2024. 4. 24. 10:21반응형

Mels-TTS: Multi-Emotion Multi-Lingual Multi-Speaker Text-to-Speech System via Disentangled Style Tokens

- 효과적인 emotion transfer를 위해 disentangled style token을 활용할 수 있음

- Mels-TTS

- Global style token에서 영감을 받아 emotion, language, speaker, residual information을 disentangle 하는 개별적인 style token을 활용

- Attention mechanism을 적용하여 각 style token에서 target speech에 대한 speech attribute를 학습

- 논문 (ICASSP 2024) : Paper Link

1. Introduction

- Text-to-Speech (TTS) 작업은 multi-emotion, multi-lingual TTS로 확장되고 있지만, 여전히 real-world scenario에서는 합성의 한계가 존재함

- 특히 emotion transfer/cross-lingual TTS는 source speaker로부터 emotion/language information을 학습하여 target speaker에 반영하는 것을 목표로 함

- BUT, content, speaker identity, emotion, language 등의 speech attribute는 본질적으로 intertwining 되어 있음 - 따라서 desired speech attribute를 target speaker에 잘 transfer하기 위해서는 해당 attribute를 분리할 수 있어야 함

- 만약 해당 speech attribute에 적절한 label이 존재하는 경우, 보다 쉽게 disentangle할 수 있지만 unseen label에 대해서는 대응이 어렵고 cross-lingual scenario에는 적합하지 않음

- Speech attribute 중에서도 emotion은 상당한 complexity와 variability를 띄기 때문

- 이러한 disentanglement 문제를 극복하기 위해 Reference-based TTS를 고려해 볼 수 있음

- 앞서 unsupervised 방식으로 emotion을 추출하는 방법이 제안되기는 했으나, 여전히 exclusive separation을 보장하지는 못함

- 특히 utterance 내에는 speech attribute의 intensity에 대한 상당한 variation이 존재함

- 즉, intended information이 utterance에서 명확하게 전달되지 않으면 reference-based system은 reference speech에서 information을 제대로 추출할 수 없음 - 결과적으로 individual utterance 내에서 다양한 speech attribute의 intensity가 fluctuate 하는 경우, intended informatino의 정확한 추출을 방해함

- 앞서 unsupervised 방식으로 emotion을 추출하는 방법이 제안되기는 했으나, 여전히 exclusive separation을 보장하지는 못함

- 특히 emotion transfer/cross-lingual TTS는 source speaker로부터 emotion/language information을 학습하여 target speaker에 반영하는 것을 목표로 함

-> 그래서 이러한 reference-based TTS의 disentanglement 문제를 해결하고 multi-emotion, multi-lingual, multi-speaker 작업을 효과적으로 수행하는 Mels-TTS를 제안

- Mels-TTS

- Global Style Token (GST)에서 영감을 받아 style control을 위한 emotion encoder를 설계

- GST 방법론을 사용하여 target speaker의 reference embedding과 style token 간의 similarity를 학습 - Disentanglement ability를 향상하기 위해 speaker, language, residual, emotion에 대한 4가지 style token을 활용

- Training phase에서 attention mechanism을 활용해 각각의 disentangled style token이 target speech에 미치는 영향을 학습함

- 이를 통해 다양한 speech attribute의 영향을 개별적으로 학습하여 성공적인 disentanglement를 달성 - 추론 시에는 disentangled style token 중에서 desired emotion token을 selectively choice 함

- 해당 token은 attention을 통해 desired reference embedding에서 emotion embedding을 추출하는 데 사용되고 robust emotion transfer를 가능하게 함

- Global Style Token (GST)에서 영감을 받아 style control을 위한 emotion encoder를 설계

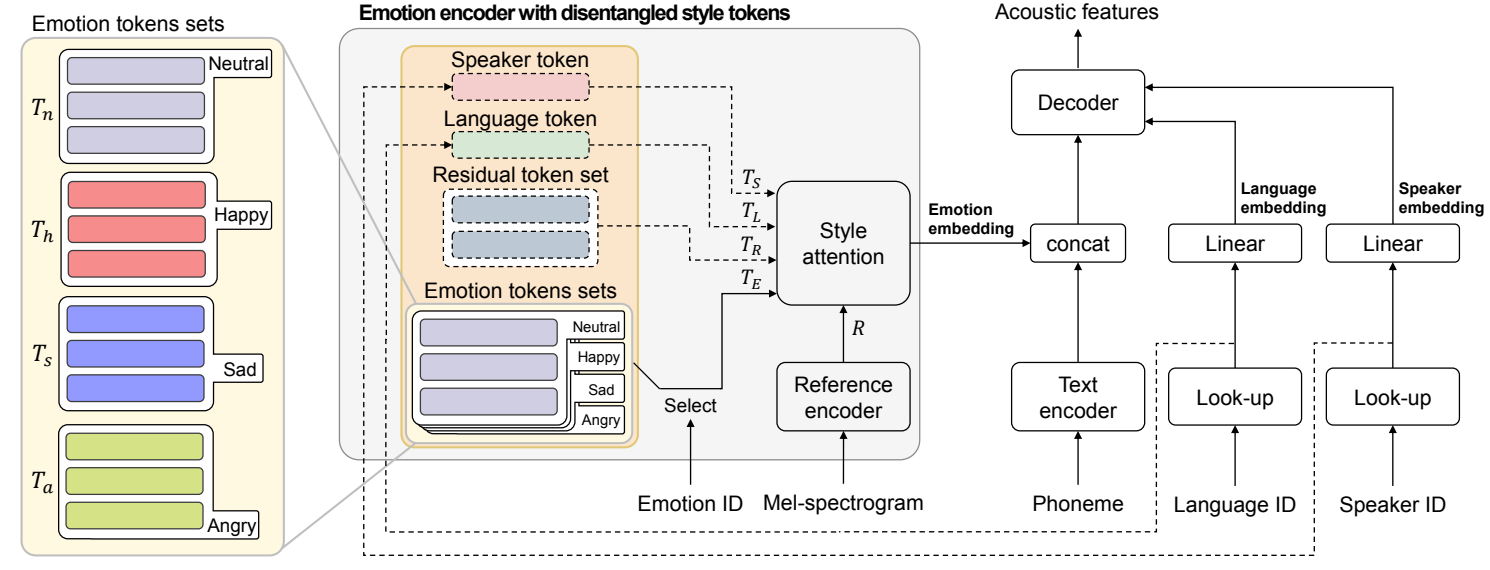

< Overall of Mels-TTS >

- Global style token을 기반으로 emotion, language, speaker, residual information을 disentangle 함

- Attention mechanism을 적용하여 각 style token에서 target speech에 대한 speech attribute를 학습

- 결과적으로 multi-lingual, multi-speaker 환경에서 기존 reference-based TTS 보다 뛰어난 emotion transfer 성능을 달성

2. Method

- Overall Architecture

- Mels-TTS는 Tacotron-variant를 기반으로 함

- Text encoder는 phoneme sequence를 text embedding으로 처리하고 decoder는 autoregressive 하게 acoustic feature를 생성함

- 각 decoder step에서 pre-net은 추론 중에 예측되는 target acoustic feature의 previous frame을 처리

- Pre-net output은 previous attention context와 concatenate 되어 current context vector를 생성

- 이는 decoder RNN stack으로 전달되어 target acoustic feature와 stop token을 예측함

- Mels-TTS는 emotion, speaker, language information을 처리하는 것을 목표로 함

- 이를 위해 disentangled style token이 포함된 emotion encoder에서 emotion embedding을 추출하고 text embedding에 concatenate

- 여기서 speaker, language ID는 look-up table을 통해 처리되어 disentangled style token을 생성 - Linear layer 이후, speaker, language embedding은 decoder의 pre-net output과 concatenate되어 speaker와 language에 대한 control을 제공함

- 이를 위해 disentangled style token이 포함된 emotion encoder에서 emotion embedding을 추출하고 text embedding에 concatenate

- Text encoder는 phoneme sequence를 text embedding으로 처리하고 decoder는 autoregressive 하게 acoustic feature를 생성함

- Emotion Encoder with Disentangled Style Tokens

- Mels-TTS는 reference encoder와 style attention을 활용

- Reference encoder는 target speech의 mel-spectrogram을 reference embedding으로 처리하여 style attention에 대한 query 역할을 수행함

- 한편으로 style attention에 대한 key, value를 얻기 위해 speaker, language, emotion, residual의 4가지 speech attribute를 나타내는 disentangled style token을 활용함

- Disentangled Style Tokens

- Emotion Token Sets

- Emotion token set은 reference embedding에서 emotion information만 학습하도록 구성

- Dataset 내의 imbalanced emotion의 문제를 해결하고 balanced learning이 가능하도록 하기 위함 - 각 emotion token set은 emotion category 내의 다양한 nuance를 capture 하기 위해 randomly initialized embedding bank로 구성됨

- 이후 emotion ID를 사용하여 target mel-spectrogram의 emotion에 따라 해당하는 token set을 choice 함

- Emotion token set은 reference embedding에서 emotion information만 학습하도록 구성

- Speaker Token

- Emotion embedding을 지원하기 위해 speaker token을 활용하여 reference embedding에서 speaker information을 segregate 함

- Training 중에 speaker token은 speaker look-up table의 output embedding을 활용하여 reference embedding의 speaker information을 학습

- 추론 시에는 disentangled style token에서 speaker token을 excluding 함으로써 speaker information을 포함하지 않고 reference embedding에서 emotion embedding을 추출

- Language Token

- Language token은 reference embedding에서 language detail을 separate 하는 것을 목표로 함

- 앞선 speaker token과 유사하게 동작 - Language token은 학습 시에는 language look-up table을 활용하지만 추론 시에는 사용하지 않음

- Language token은 reference embedding에서 language detail을 separate 하는 것을 목표로 함

- Residual Token Set

- Speaker, language attribute를 제외한 non-emotion information 내의 additional detail을 반영하는 역할

- Residual token set는 randomly initialized embedding으로 구성

- 추론 시에는 앞선 speaker, language token과 비슷하게 exclude 됨

- Emotion Token Sets

- Style Attention

- Training

- Reference embedding $R\in \mathbb{R}^{1\times d_{R}}$에서 다양한 speech information을 capture 하기 위해, Mels-TTS는 all dinsentangled style token $T_{A}\in\mathbb{R}^{N_{A}\times d_{T}}$를 style attention mechanism의 key, value로 사용함

- 해당 token은 selected target emotion token set $T_{E} \in \mathbb{R}^{N_{E}\times d_{T}}$, speaker token $T_{S} \in \mathbb{R}^{N_{S}\times d_{T}}$, language token $T_{L}\in\mathbb{R}^{N_{L}\times d_{T}}$, residual token set $T_{R}\in \mathbb{R}^{N_{R}\times d_{T}}$로 구성

- $T_{E}$는 training data 내의 emotion diversity에 따라 달라질 수 있는 emotion token set에서 choice 됨

- 논문에서는 neutral, happy, sad, angry에 대한 emotion token을 나타내는 4개의 emotion token set $\{T_{n}, T_{h}, T_{s}, T_{a}\}$를 활용 - 여기서 $N_{E}, N_{S}, N_{L}, N_{R}$은 각각 emotion token set, speaker token, language token, residual token set의 token 수를 나타내고, 그 합은 $N_{A}$와 같음

- 최종적으로 style attention을 위해 다음과 같이 $n_{h}$개의 head를 가지는 multi-head attention을 사용:

(Eq. 1) $\mathrm{MultiHead}(R,T_{A})=\mathrm{concat}_{i\in[n_{h}]}\left[H^{(i)}(R,T_{A})\right]W_{O}$

(Eq. 2) $H^{(i)}(R,T_{A})=\mathrm{Attention}(RW_{Q}^{(i)},T_{A}W_{K}^{(i)},T_{A}W_{V}^{(i)})$

- $\mathrm{Attention}(Q,K,V)=\mathrm{softmax}(QK^{T}/\sqrt{d_{k}})V$, $d_{k}$ : 각 head의 dimension

- Projection parameter $W_{Q}^{(i)}, W_{K}^{(i)}, W_{V}^{(i)}$는 $i$-th head에 대해 학습되고, $W_{O}$는 모든 head에 대한 attention output의 concatenation을 emotion embedding에 project 함

- Inference

- Emotion-specific salience를 위해 speaker, language, residual token set을 deactivate 함

- 여기서 $T_{A}$ 대신 selected emotion token set $T_{E}$를 (Eq. 1), (Eq. 2)의 style attention에 대한 key, value로 사용

- Training

- Inference of Mels-TTS

- Emotion 전반에 걸쳐 음성을 합성하기 위해,

- 먼저 emotion 별로 representative emotion embedding을 결정함

- 이때 emotion token set에서 desired emotion token set을 select - 다음으로 모든 training database uttterance에 대한 emotion embedding을 계산하고, 각 emotion에 대한 mean emotion embedding을 얻음

- 해당 평균에 가장 가까운 utterance의 emotion embedding이 representative emotion embedding의 역할을 수행함 - 이러한 representative emotion embedding을 사용하면 추론 과정에서 reference speech 없이도 desired emotion이 포함된 음성을 안정적으로 합성할 수 있음

- Desired representative emotion embedding은 text encoder output과 concatenate 되고,

- Desired speaker, language ID는 decoder에 제공되기 전에 look-up table과 linear layer를 통해 처리됨

- 먼저 emotion 별로 representative emotion embedding을 결정함

3. Experiments

- Settings

- Dataset : AI-Hub Korean database, VCTK

- Comparisons

- LB : Label-based

- GST : Global Style Token-based

- GST-C : GST + emotion classifier

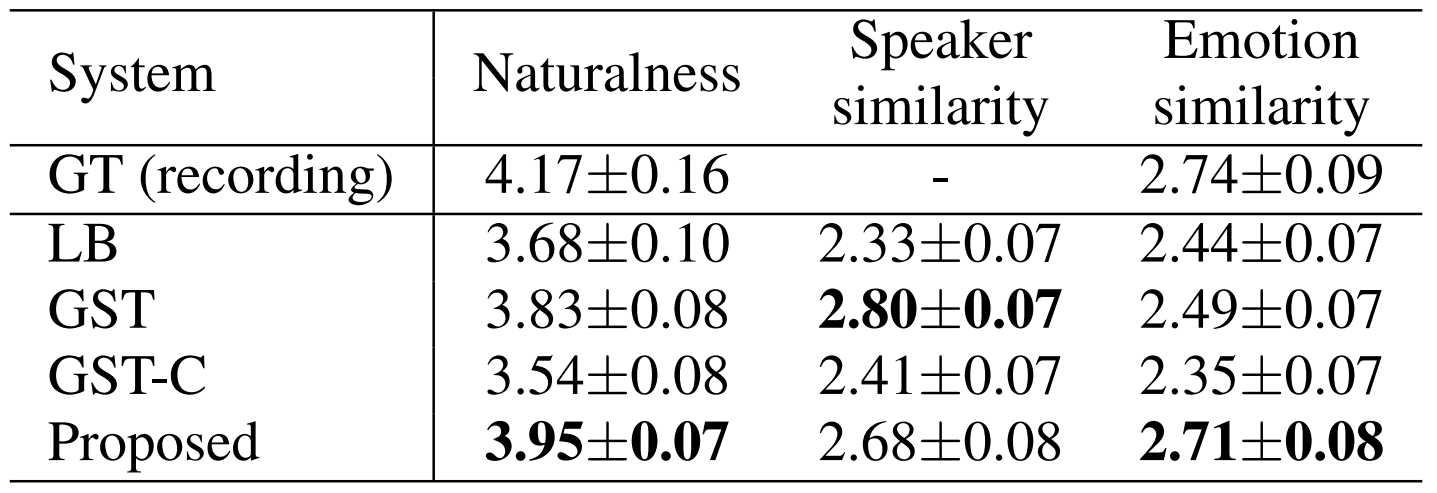

- Results

- Subjective Evaluation

- 먼저 English -> Korean의 경우, MOS측면에서 Mels-TTS가 가장 우수한 성능을 보임

- 마찬가지로 Korean -> English에서도 Mels-TTS는 nautralness, emotion similarity 측면에서 가장 뛰어난 결과를 달성

- Objective Evaluation

- Pre-trained emotion classifier를 통해 합성된 음성의 emotion accuracy를 평가해 보면

- Mels-TTS에 대한 결과가 ground-truth와 가장 비슷하게 나타남

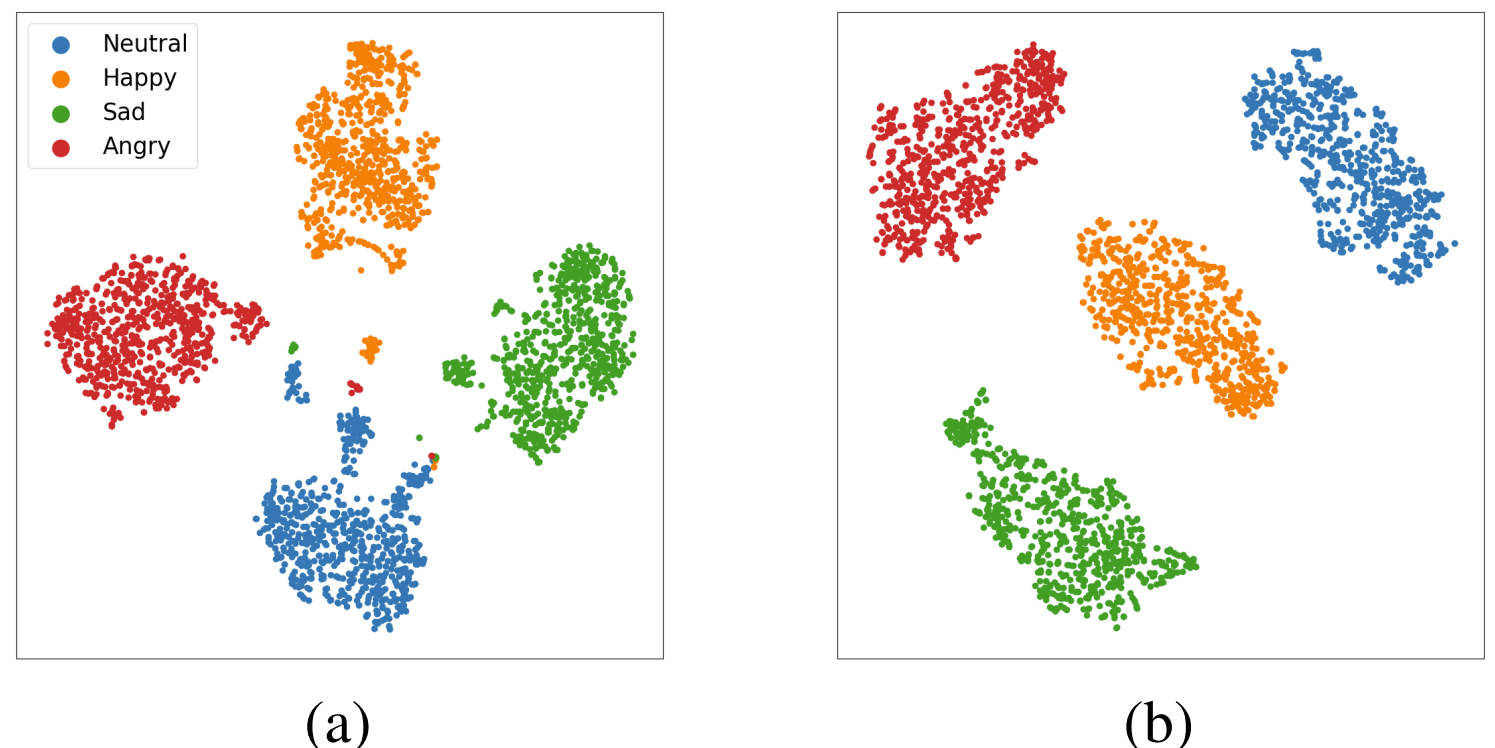

- Ablation Study

- 한편으로 SLR token을 제거하는 경우 emotion classification의 성능이 저하되는 것으로 나타남

- BUT, SLR token이 없더라도 Mels-TTS는 여전히 다른 모델들보다 우수한 성능을 보임 - 추가적으로 t-SNE를 사용해 emotion embedding을 시각화해 보면

- 아래 그림의 (a)와 같이 SLR token이 없는 경우 utterance가 제대로 cluster 되지 못함

- (b)와 같이 SLR token을 사용하는 Mels-TTS는 emotion embedding에 대한 완벽한 clustering을 수행할 수 있음 - 즉, SLR token은 speech attribute를 disentangle 하고 emotion embedding이 emotion information에 집중하도록 함

- 한편으로 SLR token을 제거하는 경우 emotion classification의 성능이 저하되는 것으로 나타남

반응형

'Paper > TTS' 카테고리의 다른 글

댓글