[Paper 리뷰] CompOFA: Compound Once-For-All Networks for Faster Multi-Platform Deployment

[Paper 리뷰] CompOFA: Compound Once-For-All Networks for Faster Multi-Platform Deployment

CompOFA: Compound Once-For-All Networks for Faster Multi-Platform Deployment Once-For-All (OFA)는 Neural Architecture Search (NAS)에서 한 번에 여러 모델을 학습시킬 수 있는 방식을 제안함 OFA를 적용하더라도 NAS 비용은 여전히 높음 CompOFA Accuracy-latency Pareto frontier에 가까운 모델로 search 범위를 제한 더 작은 search space를 구성하기 위한 모델 magnitude 간의 compound relationship 파악 논문 (ICRL 2021) : Paper Link 해당 논문의 Baseline : Once-For-All (OFA) 리뷰 1. Introd..

[Paper 리뷰] Once-For-All: Train One Network and Specialize it for Efficient Deployment

[Paper 리뷰] Once-For-All: Train One Network and Specialize it for Efficient Deployment

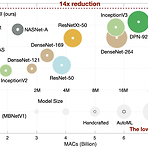

Once-For-All: Train One Network and Specialize it for Efficient Deployment 다양한 edge device에서 자원 제약을 만족하는 효율적인 inference의 어려움 Once-For-All (OFA) training / search를 분리하여 cost를 줄임 OFA에서 추가적인 training 없이 sub-network를 얻을 수 있음 Progressive Shrinking OFA network training을 위해 제안 -> depth/width/kernel/resolution pruning 논문 (ICRL 2020) : Paper Link OFA의 개선버전 : CompOFA 리뷰 1. Introduction model size의 증가는 har..